Er is echter een coole ontwikkeling ontstaan met OpenVoice, een gezamenlijke creatie van teams van het Massachusetts Institute of Technology (MIT), Tsinghua University in Beijing en het Canadese AI-bedrijf MyShell. OpenVoice is een open-sourceplatform voor stemklonen, dat zich onderscheidt door zijn snelle verwerking en geavanceerde aanpassingsmogelijkheden, waardoor het zich onderscheidt van bestaande technologieën voor stemklonen.

Tegenwoordig openen we met trots ons OpenVoice-algoritme en omarmen we ons kernethos: AI voor iedereen.

Ervaar het nu: https://t.co/zHJpeVpX3t. Kloon stemmen met ongeëvenaarde precisie, met gedetailleerde controle van de toon, van emotie tot accent, ritme, pauzes en intonatie, met slechts een… pic.twitter.com/RwmYajpxOt

— MijnShell (@myshell_ai) 2 januari 2024

Om de toegankelijkheid en transparantie te vergroten, heeft het bedrijf een link gedeeld naar het grondig herziene document onderzoekspapier waarin de ontwikkeling van OpenVoice wordt beschreven. Bovendien hebben ze toegangspunten geboden waarmee gebruikers met deze technologie kunnen experimenteren. Deze omvatten de MyShell-webapp-interface, waarvoor gebruikersregistratie vereist is, en Knuffelend Gezichttoegankelijk voor het publiek zonder enig account.

MyShell streeft ernaar bij te dragen aan de bredere onderzoeksgemeenschap en beschouwt OpenVoice als nog maar het begin. Vooruitkijkend zijn ze van plan de steun uit te breiden via subsidies, datasets en computerbronnen om open-sourceonderzoek te versterken. Het leidende principe van MyShell is ‘AI for All’, waarbij de nadruk wordt gelegd op de betekenis van taal, visie en stem als de drie belangrijkste componenten van toekomstige kunstmatige algemene intelligentie (AGI).

Hoewel taal- en visiemodaliteiten in het onderzoeksdomein substantiële ontwikkelingen hebben doorgemaakt in open-sourcemodellen, blijft er een leemte bestaan in de stemsector. Er is met name behoefte aan een robuust, direct reagerend stemkloneringsmodel dat aanpasbare mogelijkheden voor spraakgeneratie biedt. MyShell wil deze leemte opvullen en de grenzen van spraaktechnologie in AGI verleggen.

Ontmoeten Murf AI: Tekst-naar-spraak voice-overs in enkele seconden

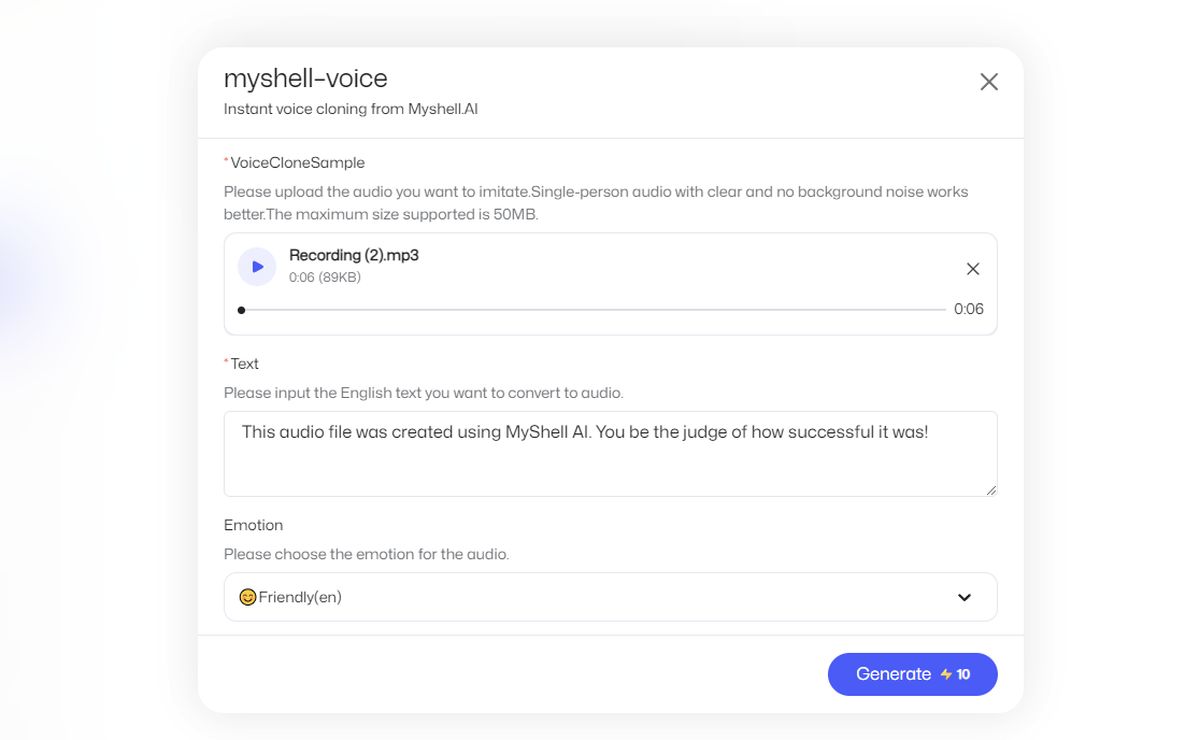

Hoe Myshell AI gebruiken?

Volg deze stappen:

- Ga naar de officiële website van MyShell AI.

- Klik op “Start de app”

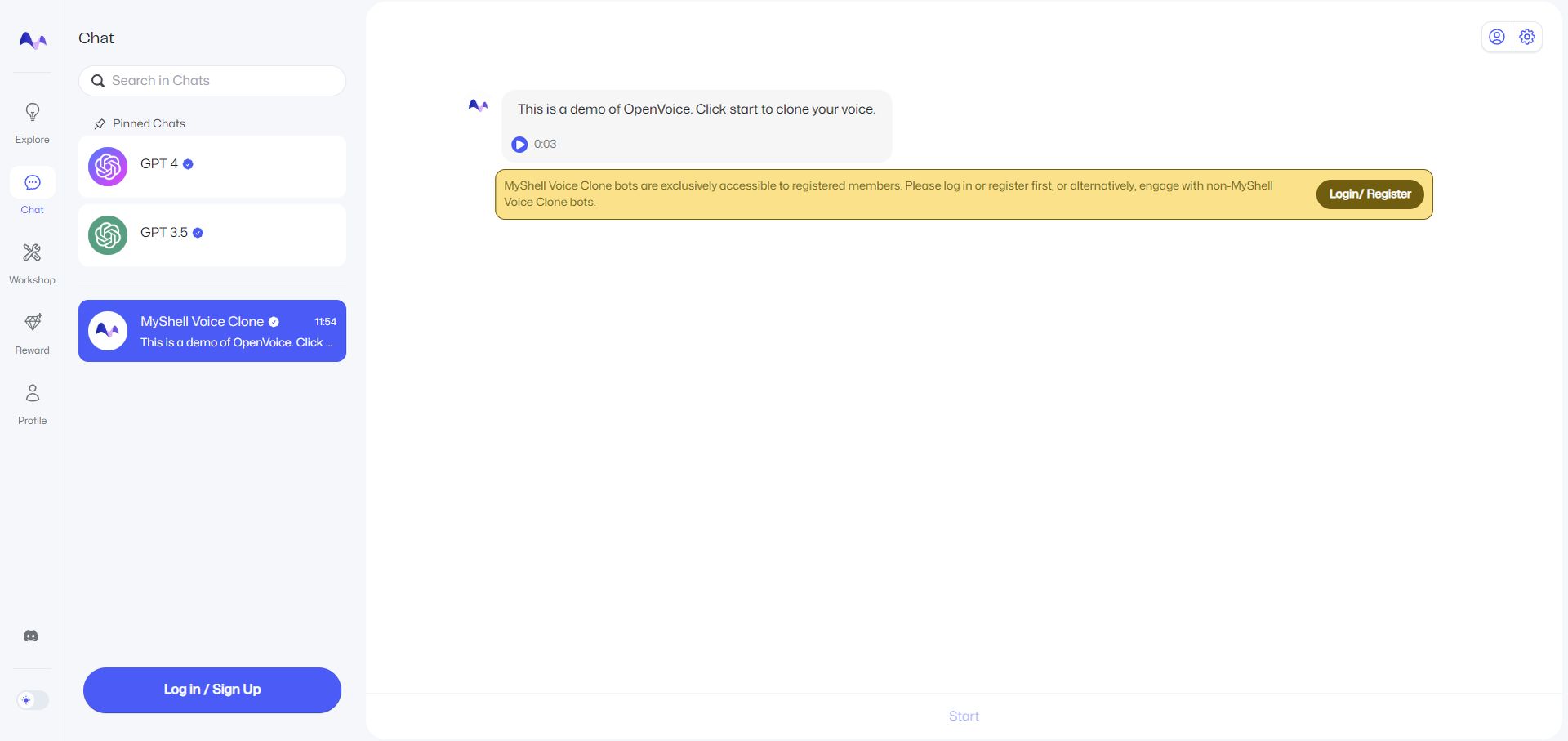

- Selecteer ‘Chat’ aan de linkerkant.

- Om de functie “MyShell Voice Clone” te kunnen gebruiken, moet u zich aanmelden met een account. Je kunt altijd een Google-account gebruiken.

- Klik vervolgens op ‘Start’. Deze bevindt zich onderaan de pagina.

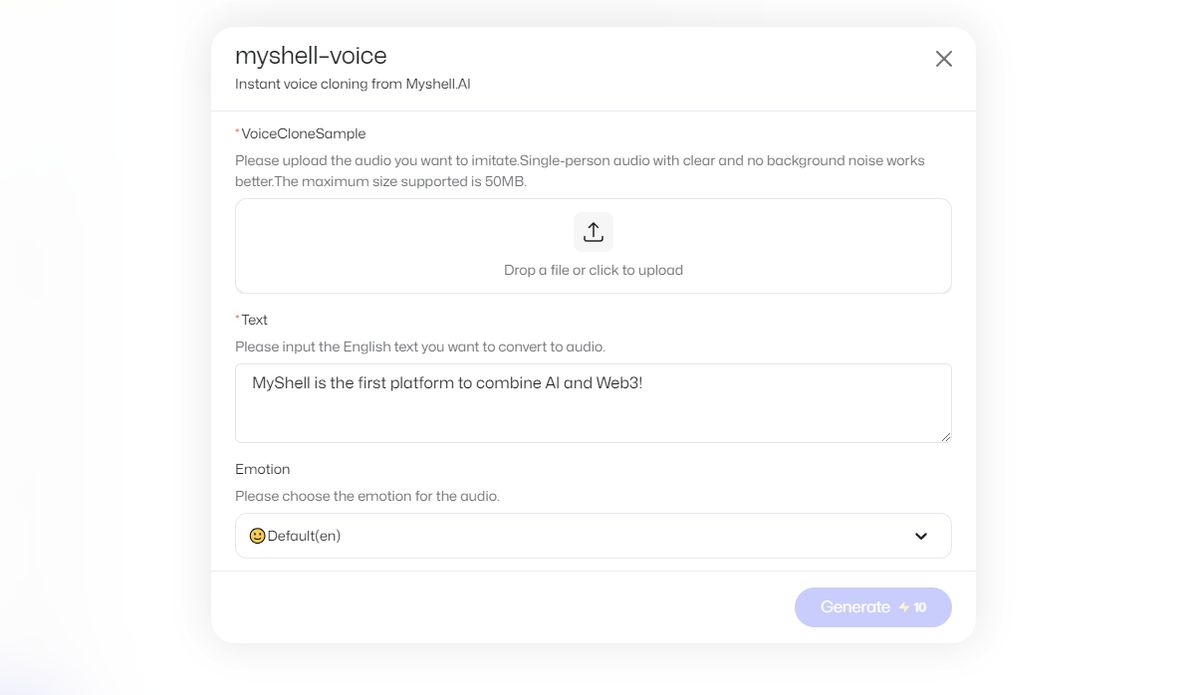

- Upload een spraakopname en voer de Engelse tekst in die u naar audio wilt converteren.

- Klik op ‘Genereren’. Dit kost 10 in-app-valuta.

- Uw output wordt via chat naar u verzonden.

Opmerking van de uitgever: Ter referentie heb ik een eigen stemopname geüpload, waarop staat: “De technologie voor het klonen van stemmen boekt vooruitgang en er is een opmerkelijke vooruitgang geboekt door startups zoals ElevenLabs.”

Vervolgens werd om een uitvoer gevraagd, die luidt: “Dit audiobestand is gemaakt met MyShell AI. Jij kunt beoordelen hoe succesvol het was!”

Invoer:

Uitgang:

Ik zou de output niet erg succesvol noemen, maar het is verbazingwekkend om te zien hoe snel het is. Voeg eraan toe dat ik geen moedertaalspreker ben.

Hoe werkt OpenVoice-technologie?

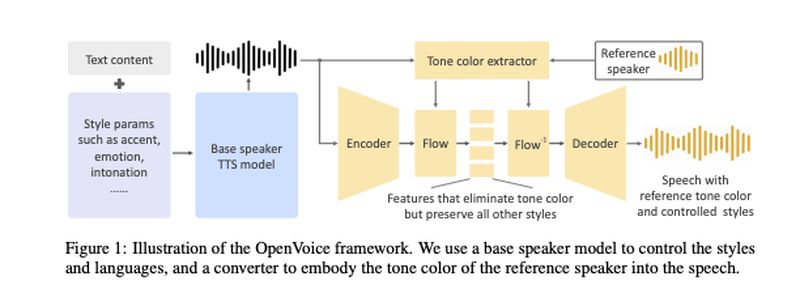

De OpenVoice-technologie, ontwikkeld door Qin, Wenliang Zhao en Xumin Yu van de Tsinghua Universiteit, samen met Xin Sun van MyShell, wordt verwoord in hun wetenschappelijke artikel. Deze AI voor het klonen van stemmen is gebaseerd op een architectuur met twee modellen: een Text-to-Speech (TTS)-model en een ‘toonomzetter’.

Het TTS-model is verantwoordelijk voor het beheer van stijlparameters en talen. Het onderging een training met behulp van 30.000 zinnen aan audiofragmenten, waaronder stemmen met Amerikaanse en Britse accenten in het Engels, evenals Chinese en Japanse sprekers. Deze monsters waren voorzien van een duidelijk label om de emoties weer te geven die erin tot uiting kwamen. Het model leerde nuances zoals intonatie, ritme en pauzes uit deze clips.

Aan de andere kant werd het toonconversiemodel getraind met een uitgebreide dataset van meer dan 300.000 audiosamples van meer dan 20.000 verschillende luidsprekers.

In beide modellen werd de audio van menselijke spraak omgezet in fonemen – de basisgeluidseenheden die woorden onderscheiden. Deze werden vervolgens weergegeven door vectorinbedding.

Het unieke proces omvat het gebruik van een “basisluidspreker” in het TTS-model, gecombineerd met een toon die is afgeleid van de opgenomen audio van een gebruiker. Door deze combinatie kunnen de modellen niet alleen de stem van de gebruiker reproduceren, maar ook de ’toonkleur’, dat wil zeggen de emotionele expressie van de gesproken tekst, wijzigen.

Het team heeft een diagram in hun paper opgenomen om te illustreren hoe deze twee modellen op elkaar inwerken:

Ze benadrukken dat hun methode conceptueel eenvoudig maar toch effectief is. Het vereist ook aanzienlijk minder computerbronnen vergeleken met andere methoden voor het klonen van stemmen, zoals Meta’s Voicebox.

“We wilden het meest flexibele model voor instant stemklonen tot nu toe ontwikkelen. Flexibiliteit betekent hier flexibele controle over stijlen/emoties/accenten enz., en kan zich aan elke taal aanpassen. Niemand kon dit eerder doen, omdat het te moeilijk is. Ik leid een groep ervaren AI-wetenschappers en heb enkele maanden besteed aan het bedenken van de oplossing. We ontdekten dat er een heel elegante manier is om de moeilijke taak op te splitsen in enkele uitvoerbare subtaken, om te bereiken wat in zijn geheel te moeilijk lijkt. De ontkoppelde pijplijn blijkt zeer effectief maar ook heel eenvoudig te zijn”, aldus Qin in een e-mail van VentureBeat.