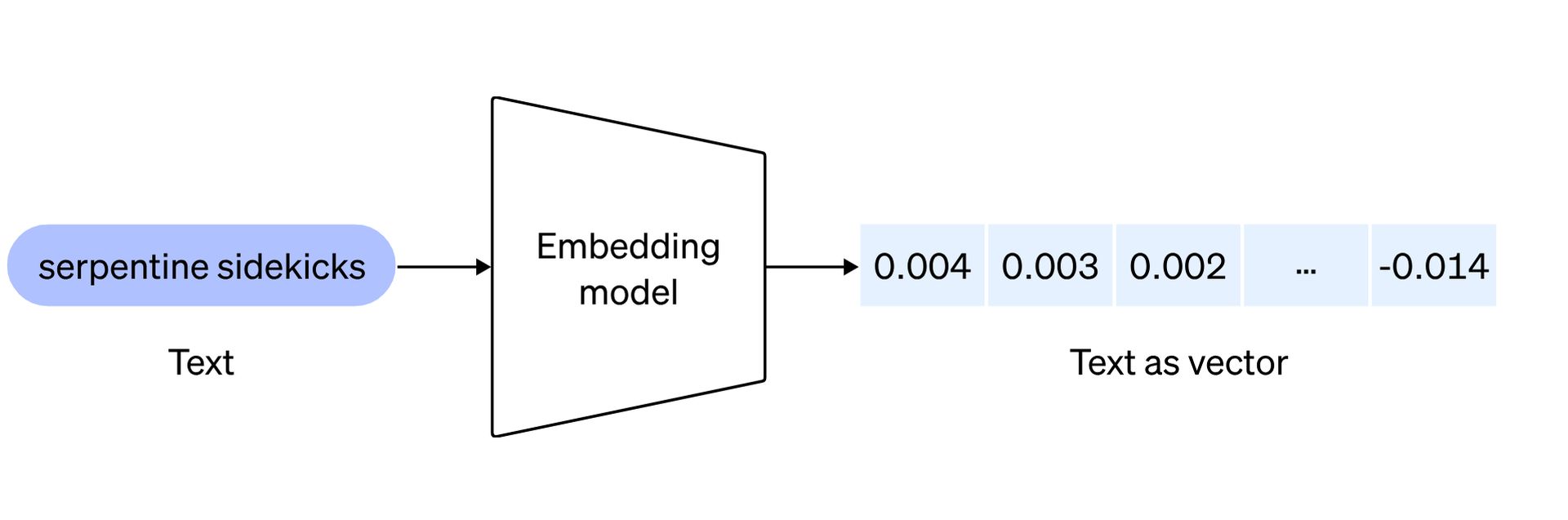

Het rijk van kunstmatige intelligentie blijft evolueren met nieuwe OpenAI-inbeddingsmodellen. Ze zijn klaar om de manier waarop ontwikkelaars natuurlijke taalverwerking benaderen opnieuw te definiëren. Voordat we de twee baanbrekende modellen verkennen, die elk zijn ontworpen om de mogelijkheden van AI-toepassingen te verbeteren, volgt hier wat inbedding gemeen:

De tekstinsluitingen van OpenAI dienen als maatstaf om de correlatie tussen tekstreeksen te meten en toepassingen in verschillende domeinen te vinden, waaronder:

- Zoekopdracht: wordt gebruikt om resultaten te rangschikken op basis van hun relevantie voor een bepaalde zoekopdrachtreeks, waardoor de nauwkeurigheid van de zoekresultaten wordt verbeterd.

- Clustering: Wordt gebruikt voor het groeperen van tekstreeksen op basis van hun overeenkomsten, waardoor de organisatie van gerelateerde informatie wordt vergemakkelijkt.

- Aanbevelingen: Toegepast in aanbevelingssystemen om items voor te stellen die gemeenschappelijke kenmerken hebben in hun tekstreeksen, waardoor de personalisatie van suggesties wordt verbeterd.

- Onregelmatigheidsdetectie: Wordt gebruikt om uitschieters met minimale verwantschap te identificeren, wat helpt bij het detecteren van onregelmatige patronen of datapunten.

- Meting van diversiteit: Wordt gebruikt voor het analyseren van gelijkenisverdelingen, waardoor de diversiteit binnen datasets of tekstcorpora kan worden beoordeeld.

- Classificatie: geïmplementeerd in classificatietaken waarbij tekstreeksen worden gecategoriseerd op basis van hun meest vergelijkbare label, waardoor het labelingproces in machine learning-toepassingen wordt gestroomlijnd.

Nu bent u klaar om de nieuwe OpenAI-inbeddingsmodellen te verkennen!

Er zijn nieuwe OpenAI-inbeddingsmodellen gearriveerd

De introductie van de nieuwe OpenAI-inbeddingsmodellen markeert een aanzienlijke sprong voorwaarts in de verwerking van natuurlijke taal, waardoor ontwikkelaars tekstuele inhoud beter kunnen weergeven en begrijpen. Laten we eens kijken naar de details van deze innovatieve modellen: tekst-embedding-3-klein En tekst-embedding-3-groot.

tekst-embedding-3-klein

Dit compacte maar krachtige model vertoont een opmerkelijke prestatieverbetering ten opzichte van zijn voorganger, text-embedding-ada-002. Op de meertalige retrieval benchmark (MIRACL) is de gemiddelde score gestegen van 31,4% naar een indrukwekkende 44,0%. Ook op de Engelse takenbenchmark (MTEB) is de gemiddelde score lovenswaardig gestegen van 61,0% naar 62,3%. Wat text-embedding-3-small echter onderscheidt, zijn niet alleen de verbeterde prestaties, maar ook de betaalbaarheid.

| Eval-benchmark | ada v2 | tekst-embedding-3-klein | tekst-embedding-3-groot |

| MIRACL-gemiddelde | 31.4 | 44,0 | 54,9 |

| MTEB-gemiddelde | 61,0 | 62,3 | 64,6 |

OpenAI heeft de prijzen aanzienlijk verlaagd, waardoor het vijf keer kosteneffectiever is vergeleken met text-embedding-ada-002, waarbij de prijs per 1k-tokens is verlaagd van $0,0001 naar $0,00002. Dit maakt text-embedding-3-small niet alleen een efficiëntere keuze, maar ook een meer toegankelijke keuze voor ontwikkelaars.

tekst-embedding-3-groot

text-embedding-3-large vertegenwoordigt de volgende generatie inbeddingsmodellen en introduceert een substantiële toename in dimensies, waarbij inbeddingsmogelijkheden tot 3072 dimensies worden ondersteund. Dit grotere model biedt een meer gedetailleerde en genuanceerde weergave van tekstuele inhoud. Qua prestaties overtreft text-embedding-3-large zijn voorganger in benchmarks. Op MIRACL is de gemiddelde score gestegen van 31,4% naar een indrukwekkende 54,9%, wat de bekwaamheid op het gebied van het ophalen van meerdere talen onderstreept.

| ada v2 | tekst-embedding-3-klein | tekst-embedding-3-groot | ||||

| Inbeddingsgrootte | 1536 | 512 | 1536 | 256 | 1024 | 3072 |

| Gemiddelde MTEB-score | 61,0 | 61,6 | 62,3 | 62,0 | 64.1 | 64,6 |

Op dezelfde manier is de gemiddelde score op MTEB gestegen van 61,0% naar 64,6%, wat de superioriteit van de Engelse taken aantoont. Text-embedding-3-large, geprijsd op $ 0,00013 per 1k tokens, biedt een balans tussen uitmuntende prestaties en kosteneffectiviteit, en biedt ontwikkelaars een robuuste oplossing voor toepassingen die hoogdimensionale insluitingen vereisen.

Ontmoeten Google Lumière AIBard’s neef van videomaker

Native ondersteuning voor het verkorten van insluitingen

OpenAI erkent de uiteenlopende behoeften van ontwikkelaars en introduceert native ondersteuning voor het verkorten van insluitingen. Met deze innovatieve techniek kunnen ontwikkelaars de insluitingsgrootte aanpassen door de API-parameter voor afmetingen aan te passen. Door dit te doen kunnen ontwikkelaars bepaalde prestaties inruilen voor een kleinere vectorgrootte, zonder de fundamentele eigenschappen van de inbedding in gevaar te brengen. Deze flexibiliteit is vooral waardevol in scenario’s waarin systemen alleen inbedding tot een bepaalde grootte ondersteunen, waardoor ontwikkelaars een veelzijdige tool krijgen voor verschillende gebruiksscenario’s.

Samenvattend vertegenwoordigen de nieuwe inbeddingsmodellen van OpenAI een aanzienlijke stap voorwaarts op het gebied van efficiëntie, betaalbaarheid en prestaties. Of ontwikkelaars nu kiezen voor de compacte maar efficiënte weergave van text-embedding-3-small of de meer uitgebreide en gedetailleerde insluitingen van text-embedding-3-large, deze modellen bieden ontwikkelaars veelzijdige tools om diepere inzichten uit tekstuele gegevens in hun AI te halen. toepassingen.

Voor meer gedetailleerde informatie over de nieuwe OpenAI-inbeddingsmodellen klikt u op hier en ontvang de officiële aankondiging.

Uitgelichte afbeeldingscredits: Levart_Photographer/Unsplash