Met zijn nieuwe 1-bit LLM-technologie heeft Microsoft misschien net de code gekraakt voor het creëren van krachtige AI achter chatbots en taaltools die in je zak passen, razendsnel werken en helpen de planeet te redden.

Oké, gooi het planeetgedeelte weg, maar het is echt een groot probleem!

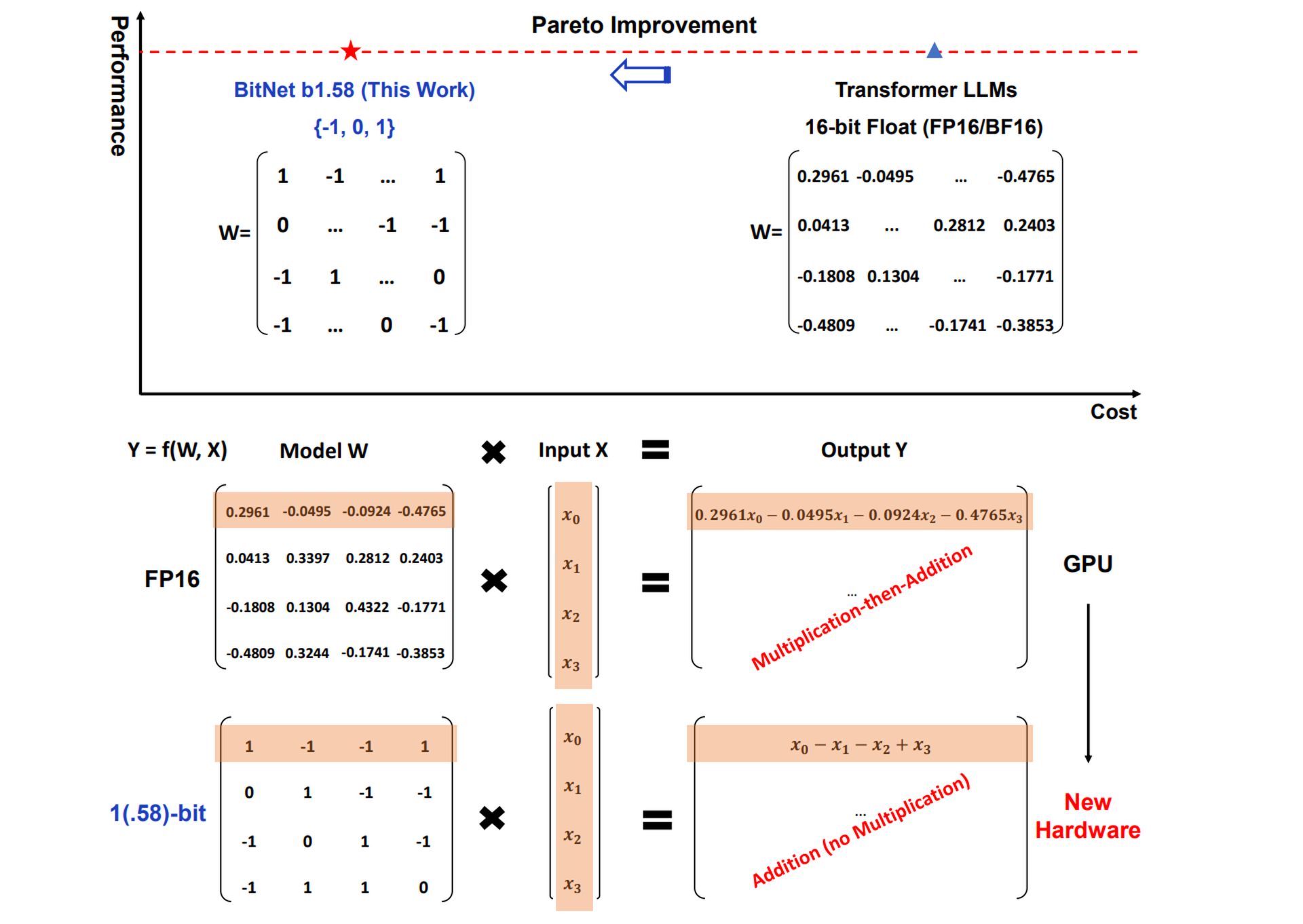

Traditionele LLM’s, de krachtige AI-modellen achter tools zoals ChatGPT En Tweelingdoorgaans gebruiken 16-bits of zelfs 32-bits drijvende-kommagetallen om de parameters of gewichten van het model weer te geven. Deze gewichten bepalen hoe het model informatie verwerkt. De 1-bit LLM van Microsoft hanteert een radicaal andere benadering door deze gewichten te kwantificeren (de nauwkeurigheid ervan te verminderen) tot slechts 1,58 bits.

Met een 1-bit LLM kan elk gewicht slechts één van de drie waarden aannemen: -1, 0 of 1.

Dit lijkt misschien drastisch beperkendmaar het leidt tot opmerkelijke voordelen.

Wat is er zo ophef over 1-Bit LLM’s?

De verminderde resourcevereisten van 1-bit LLM’s zouden AI-toepassingen op een breder scala aan apparaten mogelijk kunnen maken, zelfs apparaten met beperkt geheugen of beperkte rekenkracht. Dit zou kunnen leiden tot een bredere adoptie van AI in verschillende sectoren.

Kleinere hersenen gemeen AI kan op kleinere apparaten draaien: Je telefoon, smartwatch, noem maar op.

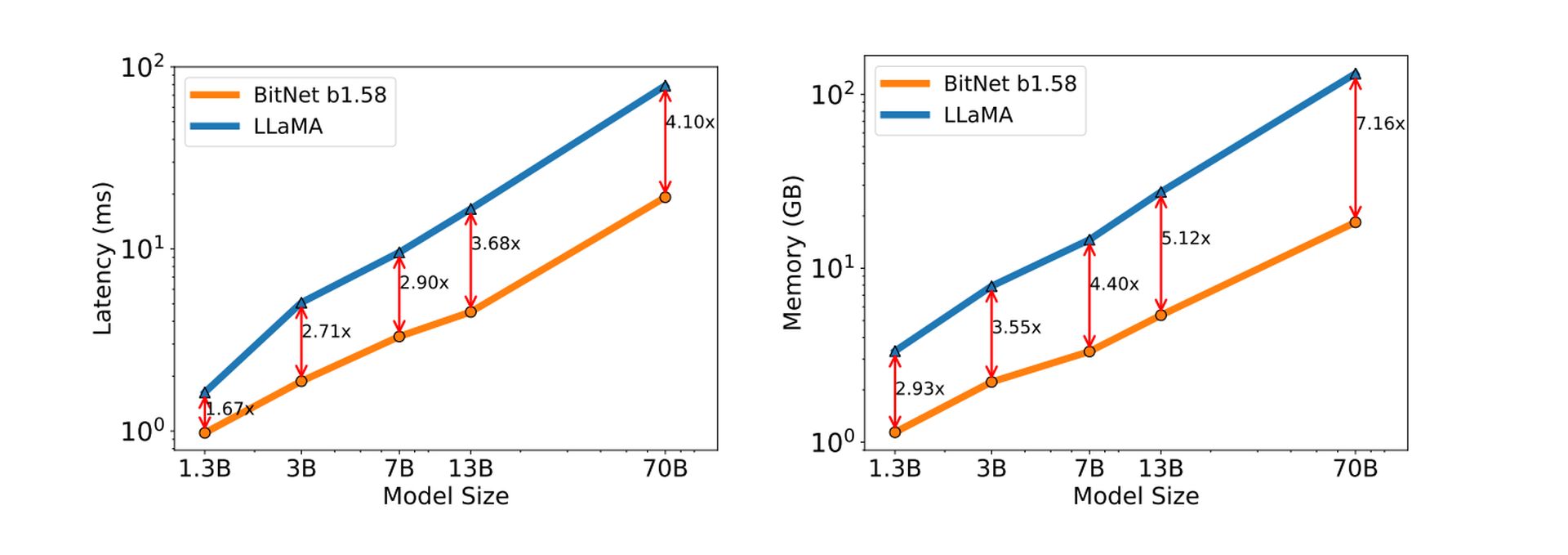

De vereenvoudigde weergave van gewichten in een 1-bit LLM vertaalt zich in snellere inferentiesnelheden – het proces van het genereren van tekst, het vertalen van talen of het uitvoeren van andere taalgerelateerde taken.

Eenvoudigere berekeningen betekenen de AI denkt en reageert veel sneller.

De rekenefficiëntie van 1-bit LLM’s leidt ook tot een lager energieverbruik, waardoor ze milieuvriendelijker en kosteneffectiever in gebruik worden.

Minder rekenkracht staat gelijk aan minder energieverbruik. Dit is een grote overwinning voor milieubewuste technologie, een ultieme stap naar maak AI groen.

Afgezien van dat alles openen de unieke rekenkarakteristieken van 1-bit LLM’s mogelijkheden voor het ontwerpen van gespecialiseerde hardware die is geoptimaliseerd voor hun activiteiten, wat mogelijk kan leiden tot nog verdere verbeteringen in prestaties en efficiëntie.

Maak kennis met BitNet LLM van Microsoft

Microsoft’s implementatie van deze technologie wordt genoemd BitNet b1.58. De extra 0-waarde (vergeleken met echte 1-bit-implementaties) is een cruciaal element dat de prestaties van het model verbetert.

BitNet b1.58 laat opmerkelijke resultaten zien en benadert in sommige gevallen de prestaties van traditionele LLM’s, zelfs met ernstige kwantisering.

Het doorbreken van de 16-bitsbarrière

Zoals eerder vermeld, gebruiken traditionele LLM’s 16-bit drijvende-kommawaarden (FP16) om gewichten binnen het model weer te geven. Deze aanpak biedt weliswaar een hoge nauwkeurigheid, maar kan geheugenintensief en rekentechnisch duur zijn. BitNet b1.58 gooit een sleutel in dit paradigma door een 1,58-bits ternaire representatie voor gewichten aan te nemen.

Dit betekent dat elk gewicht slechts drie verschillende waarden kan aannemen:

- -1: vertegenwoordigt een negatieve invloed op de output van het model

- 0: Geeft geen invloed op de output aan

- +1: vertegenwoordigt een positieve invloed op de output

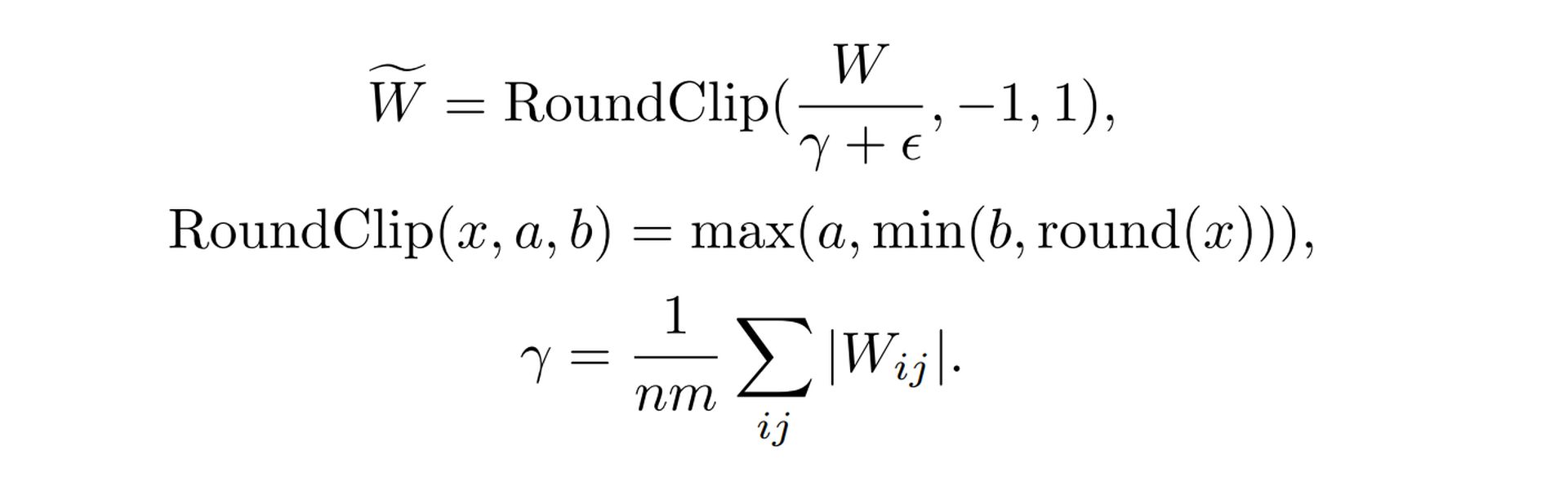

Gewichten efficiënt in kaart brengen

De overgang van een continue (FP16) naar een discrete (ternaire) gewichtsruimte vereist een zorgvuldige afweging. BitNet b1.58 maakt gebruik van een speciale kwantiseringsfunctie om deze mapping effectief te realiseren. Deze functie neemt de oorspronkelijke FP16-gewichtswaarden en past een specifiek algoritme toe om de dichtstbijzijnde corresponderende ternaire waarde (-1, 0 of +1) te bepalen. De sleutel hier is het minimaliseren van de prestatieverslechtering die door deze conversie wordt veroorzaakt.

Hier is een vereenvoudigde uitsplitsing van de functie

- Schalen: De functie schaalt eerst de gehele gewichtsmatrix op basis van de gemiddelde absolute waarde. Dit zorgt ervoor dat de gewichten rond nul zijn gecentreerd

- Afronding: Elke gewichtswaarde wordt vervolgens afgerond op de dichtstbijzijnde gehele waarde tussen -1, 0 en +1. Dit vertaalt de geschaalde gewichten naar het discrete ternaire systeem

Zie de gedetailleerde formule op Microsoft’s 1-Bit LLM-onderzoekspaper.

Schaal van activering

Activeringen, een ander cruciaal onderdeel van LLM’s, ondergaan ook een schaalproces in BitNet b1.58. Tijdens training en gevolgtrekking worden activeringen geschaald naar een specifiek bereik (bijvoorbeeld -0,5 tot +0,5).

Deze schaalvergroting dient twee doelen:

- Prestatie Optimalisatie: Schaalactivaties helpen optimale prestaties te behouden binnen de omgeving met verminderde precisie van BitNet b1.58

- Vereenvoudiging: Het gekozen schaalbereik vereenvoudigt de implementatie en optimalisatie op systeemniveau zonder noemenswaardige prestatienadelen te introduceren

Compatibiliteit met open source

De LLM-onderzoek gemeenschap gedijt op open-source samenwerking. Om de integratie met bestaande raamwerken te vergemakkelijken, gebruikt BitNet b1.58 componenten die vergelijkbaar zijn met die in de populaire LLaMA-modelarchitectuur. Dit omvat elementen zoals:

- RMSNorm: Een normalisatietechniek voor het stabiliseren van het trainingsproces

- SwiGLU: Een activeringsfunctie die efficiëntievoordelen biedt

- Roterende inbedden: Een methode voor het weergeven van woorden en posities binnen het model

- Verwijdering van vooroordelen: Vereenvoudiging van de modelarchitectuur

Door deze in te bouwen Lama-achtige componenten kan BitNet b1.58 gemakkelijk worden geïntegreerd met populaire open-source LLM-softwarebibliotheken, waardoor de inspanning die nodig is voor adoptie door de onderzoeksgemeenschap wordt geminimaliseerd.

Uitgelicht beeldtegoed: Freepik.