Kyutai, een non-profit laboratorium dat zich toelegt op het bevorderen van open onderzoek in kunstmatige intelligentie (AI), heeft grote stappen gezet met zijn nieuwste innovatie, Moshi Chat. Dit geavanceerde real-time native multimodale basismodel vertegenwoordigt een opmerkelijke prestatie in AI-technologie. Kyutai’s introductie van Moshi Chat heeft aandacht getrokken vanwege zijn indrukwekkende mogelijkheden, met name op het gebied van gelijktijdig luisteren en spreken. In tegenstelling tot traditionele AI-modellen is Moshi Chat ontworpen om emoties te begrijpen en uit te drukken, waardoor interacties ermee natuurlijker en boeiender worden.

Dankzij de unieke functies en open-sourcebeschikbaarheid onderscheidt Moshi Chat zich als pionier in de ontwikkeling van AI.

De ontwikkeling van Moshi Chat is een bewijs van Kyutai’s toewijding aan transparantie en collaboratieve innovatie. Het vermogen van het model om twee audiostreams tegelijkertijd verwerken—luisteren en spreken in realtime—onderscheidt het van andere AI-modellen.

Deze mogelijkheid wordt ondersteund door een robuust gezamenlijk pre-trainingsproces op een combinatie van tekst- en audiogegevens, waarbij gebruik wordt gemaakt van synthetische tekstgegevens van Helium, een Taalmodel met 7 miljard parameters ontwikkeld door KyutaiDergelijke ontwikkelingen in AI-technologie zijn het resultaat van grondig onderzoek en verfijning, gericht op het bereiken van naadloze en efficiënte prestaties.

Technologie van Kyutai Moshi Chat

De opvallende functie van Moshi Chat is de real-time interactiemogelijkheidwaarmee het tegelijkertijd kan luisteren en reageren. Dit wordt bereikt door gezamenlijke pre-training op een mix van tekst- en audiogegevens, waardoor het model een soepele stroom van tekstuele en auditieve informatie kan behouden. De basis van de spraakverwerkingsmogelijkheden van Moshi Chat is het Helium-model, een taalmodel met 7 miljard parameters dat als ruggengraat dient voor deze innovatieve technologie.

Volgens de Keynote van Kyutai Moshi Chat op YouTubehet fine-tuningproces voor Moshi Chat omvatte een uitgebreide dataset van 100.000 synthetische gesprekken in ‘mondelinge stijl’Deze conversaties werden omgezet met behulp van Text-to-Speech (TTS)-technologie, vergelijkbaar met Murf-AIwaardoor het model spraak met opmerkelijke nauwkeurigheid kan genereren en begrijpen. De TTS-engine, die 70 verschillende emoties en stijlen ondersteunt, werd verfijnd met behulp van 20 uur aan audio die is opgenomen door erkende stemacteurs. Deze nauwkeurige aanpak van training heeft geresulteerd in een model dat begrijpt niet alleen gesproken taal, maar brengt ook emoties en nuances overwaardoor interacties natuurlijker en boeiender worden.

Kyutai’s toewijding aan verantwoord AI-gebruik blijkt uit hun integratie van watermerken om door AI gegenereerde audio te detecteren. Deze functie, die nog in ontwikkeling is, onderstreept het belang van ethische overwegingen bij AI-ontwikkeling. Bovendien benadrukt het besluit om Moshi Chat als een open-sourceproject uit te brengen Kyutai’s toewijding aan het bevorderen van een samenwerkingsomgeving binnen de AI-gemeenschap.

Trainings- en fine-tuningproces van Moshi AI

De ontwikkeling van Moshi Chat omvatte een rigoureus training- en fine-tuningproces om het hoge prestatieniveau te garanderen. Het model werd vanaf nul getraind met behulp van het Helium 7B-basisteksttaalmodel, dat vervolgens gezamenlijk werd getraind met tekst- en audiocodecs.

De spraakcodec, gebaseerd op het interne Mimi-model van Kyutai, beschikt over een 300x compressiefactorwat essentieel is voor het behoud van de kwaliteit van de audio, terwijl de datagrootte wordt verkleind.

Het finetuningproces voor Moshi Chat omvatte het annoteren 100.000 zeer gedetailleerde transcripties met emotie en stijl. Deze annotaties stellen het model in staat om een breed scala aan emoties te begrijpen en over te brengen, waardoor interacties ermee levensechter en boeiender worden. De Text-to-Speech-engine, die 70 verschillende emoties en stijlen ondersteunt, was verfijnd met behulp van 20 uur aan audio opgenomen door een gelicentieerde stemacteur genaamd Alice.

Kyutai’s focus op aanpassingsvermogen is duidelijk zichtbaar in Moshi Chat’s mogelijkheid om te worden verfijnd met minder dan 30 minuten aan audio. Deze functie stelt gebruikers in staat het model aan te passen aan specifieke behoeften, of het nu gaat om onderzoek, taalonderwijs of andere toepassingen. De implementatie van het model toont de efficiëntie en veelzijdigheid ervan, twee batchgroottes verwerken op 24 GB VRAM en meerdere backends ondersteunenEr wordt verwacht dat optimalisaties in de inferentiecode, zoals verbeterde KV-caching en prompt-caching, de prestaties van Moshi Chat verder zullen verbeteren.

Technologie voor iedereen van Kyutai Labs

Moshi Chat is niet alleen een technologisch wonder, maar ook zeer toegankelijk. Kyutai heeft een kleinere variant van het model ontwikkeld die op een MacBook of een consumentenformaat GPU kan draaien, waardoor het beschikbaar is voor een breder scala aan gebruikers.

De efficiëntie van het model wordt verder aangetoond door de inzet ervan op platforms zoals Scaleway en Knuffelend gezichtwaar het twee batchgroottes verwerkt op 24 GB VRAM, en verschillende backends ondersteunt, waaronder CUDA, Metal en CPU.

De stem van het model, getraind op synthetische data gegenereerd door een apart TTS-model, bereikt een indrukwekkende end-to-end latency van 200 milliseconden. Deze lage latency is cruciaal voor realtime-interacties, waardoor Moshi Chat bijna onmiddellijk kan reageren op gebruikersinvoer. De combinatie van geavanceerde trainingstechnieken en geoptimaliseerde inferentiecode, ontwikkeld met Rust, draagt bij aan de superieure prestaties van het model. Verbeterde KV-caching en prompt-caching zullen naar verwachting ook de efficiëntie van het model verder verbeteren.

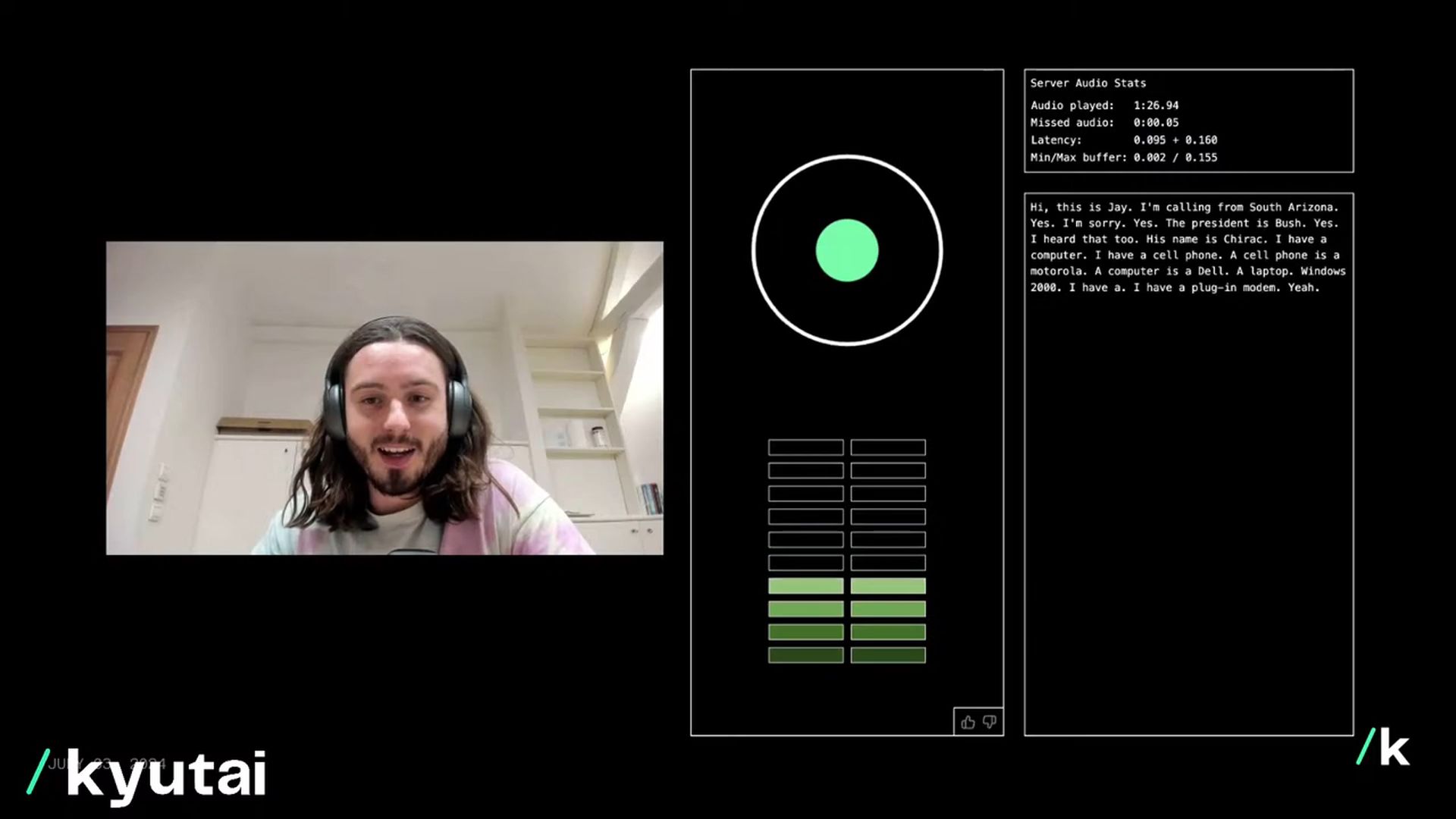

De demo geplaatst door Yann LeCun laat zien hoe goed dit nieuwe AI-model werkt.

Een live demo van Moshi van https://t.co/TngVXgSjzX https://t.co/qftjudOq1k

— Yann LeCun (@ylecun) 3 juli 2024

Vooruitkijkend heeft Kyutai ambitieuze plannen voor Moshi Chat. Het team is van plan een uitgebreid technisch rapport en open modelversies uit te brengen, inclusief de inferentiecodebase, het 7B-model, de audiocodec en de volledig geoptimaliseerde stack. Toekomstige iteraties van Moshi Chat, zoals versies 1.1, 1.2 en 2.0, zullen feedback van gebruikers opnemen om de mogelijkheden van het model te verfijnen en te verbeteren.

De permissieve licenties van Kyutai zijn erop gericht om brede acceptatie en innovatie te stimuleren en ervoor te zorgen dat de voordelen van Moshi Chat toegankelijk zijn voor een breed publiek.

Hoe Moshi Chat te gebruiken

Gebruikers kunnen en worden aangemoedigd om: probeer Moshi Chat online via de Kyutai-website. Eenmaal daar:

- Voer uw e-mailadres in

- Klik op “Wachtrij toevoegen”

- Begin met praten

Of het nu gaat om het bespreken van alledaagse onderwerpen of het verkennen van complexere onderwerpen, gebruikers kunnen op een natuurlijke manier met Moshi Chat communiceren en profiteren van de geavanceerde spraakherkennings- en synthesemogelijkheden.

Credits voor de hoofdafbeelding: Kyutai/YouTube