Microsoft heeft een manier gevonden om te concurreren met NVIDIAde Maia 100 AI-accelerator. Deze nieuwe chip vertegenwoordigt een strategische zet om De dominantie van NVIDIA in de AI-hardwaresector door geavanceerde mogelijkheden te bieden die zijn ontworpen voor high-performance cloud computing. Met de Maia 100 wil Microsoft een kosteneffectievere en efficiëntere oplossing bieden voor het beheren van grootschalige AI-workloads.

Alles wat we tot nu toe weten over Microsoft’s Maia 100

Microsoft’s Maia 100 is een krachtige nieuwe AI-accelerator die is ontworpen om grote AI-taken in de cloud af te handelen. Onthuld op Frietjes 2024, Deze chip is een grote stap voorwaarts om AI-infrastructuur kosteneffectiever te maken, en wel hier:

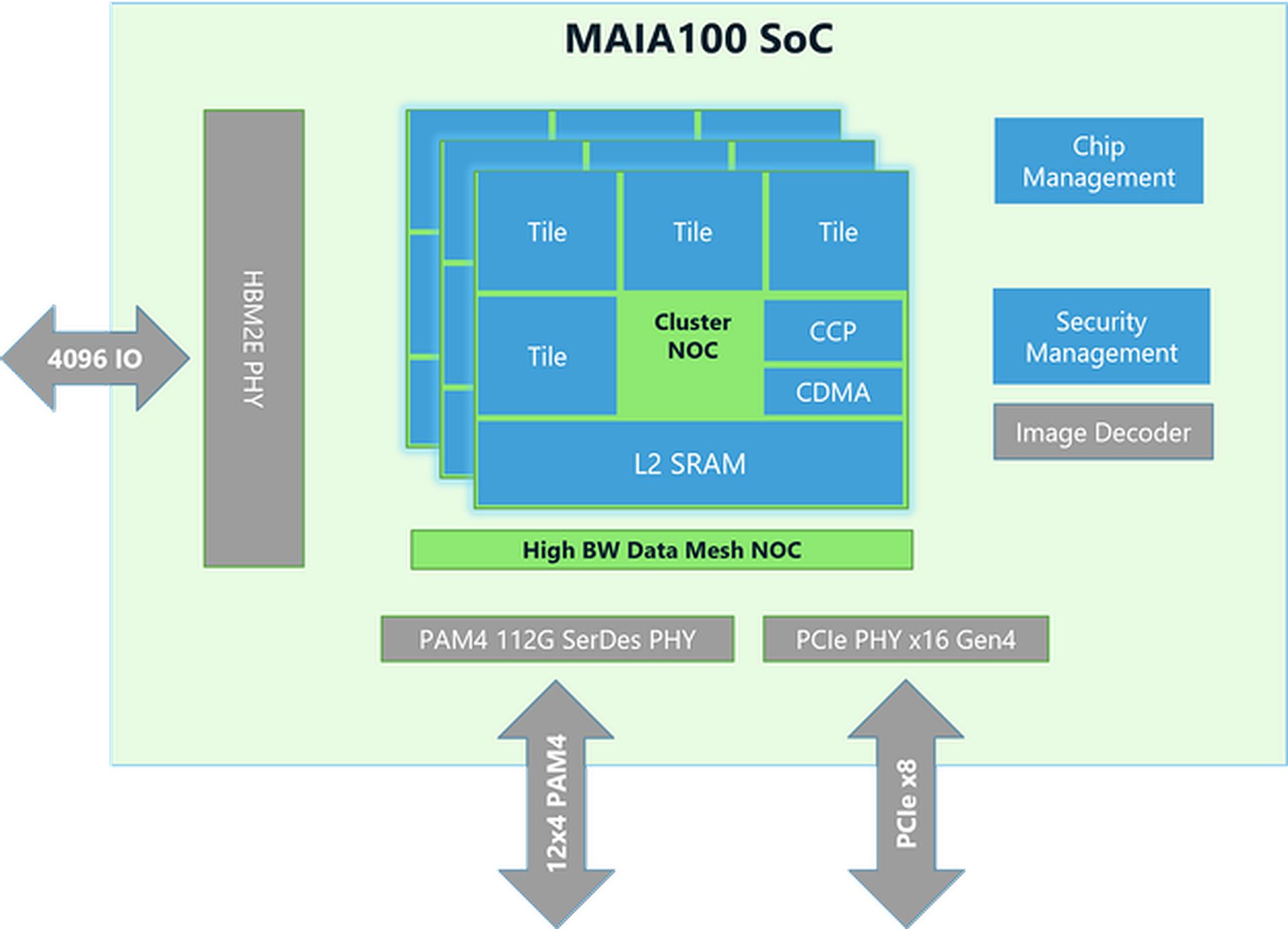

Chipontwerp en -technologie

- Grootte en productie: De Maia 100-chip is ongeveer 820 mm² groot en is gebouwd met behulp van de geavanceerde N5-technologie van TSMC. Het maakt gebruik van COWOS-S-technologie, die helpt de chip effectief te integreren met andere componenten.

- Geheugen en bandbreedte: De chip heeft veel geheugen en kan een enorme hoeveelheid data verwerken. Het heeft een grote on-die SRAM (een type snel geheugen) en vier HBM2E geheugenchips. Samen leveren ze 1,8 terabyte per seconde aan dataoverdrachtssnelheid en 64 gigabyte aan geheugencapaciteit. Deze opstelling is cruciaal voor het snel verwerken van grote AI-datasets.

Prestaties en energie-efficiëntie

- Stroomverbruik: Maia 100 kan tot 700 watt aan vermogen aan, maar is ingesteld op 500 watt voor een betere efficiëntie. Hierdoor presteert het goed en blijft het stroomverbruik onder controle.

- Tensor-eenheid: De chip bevat een supersnelle tensoreenheid voor het verwerken van complexe AI-taken zoals het trainen van modellen en het doen van voorspellingen. Het kan verschillende soorten gegevens verwerken, waaronder een nieuw formaat genaamd MX, dat Microsoft in 2023 introduceerde. Deze eenheid is ontworpen om veel berekeningen tegelijk efficiënt af te handelen.

- Vectorprocessor: Maia 100 heeft een vectorprocessor die verschillende gegevenstypen ondersteunt, zoals FP32 (32-bit floating point) en BF16 (16-bit floating point). Dit helpt bij het uitvoeren van een breed scala aan machine learning-taken.

- DMA-motor:De Direct Memory Access (DMA)-engine helpt bij het snel verplaatsen van gegevens en ondersteunt verschillende manieren om tensoren (datablokken) op te splitsen, wat de efficiëntie verbetert.

Gegevensverwerking en efficiëntie

- Gegevensopslag en compressie: Maia 100 gebruikt dataopslag met een lagere precisie en een compressie-engine om de hoeveelheid data die verplaatst moet worden te verminderen. Dit helpt om grote AI-taken efficiënter af te handelen.

- Kladblokken:Het beschikt over grote L1- en L2-kladblokken (tijdelijke opslagruimtes) die door software worden beheerd om ervoor te zorgen dat gegevens efficiënt worden gebruikt en energie wordt bespaard.

- Netwerken: De chip ondersteunt high-speed Ethernet-verbindingen, waardoor het op bepaalde manieren tot 4800 Gbps aan data kan verwerken en op andere manieren tot 1200 Gbps. Dit aangepaste netwerkprotocol zorgt voor betrouwbare en snelle dataoverdracht, die ook veilig is met AES-GCM-encryptie.

De Nvidia AI-chiporder van Elon Musk is te groot om te verwerken

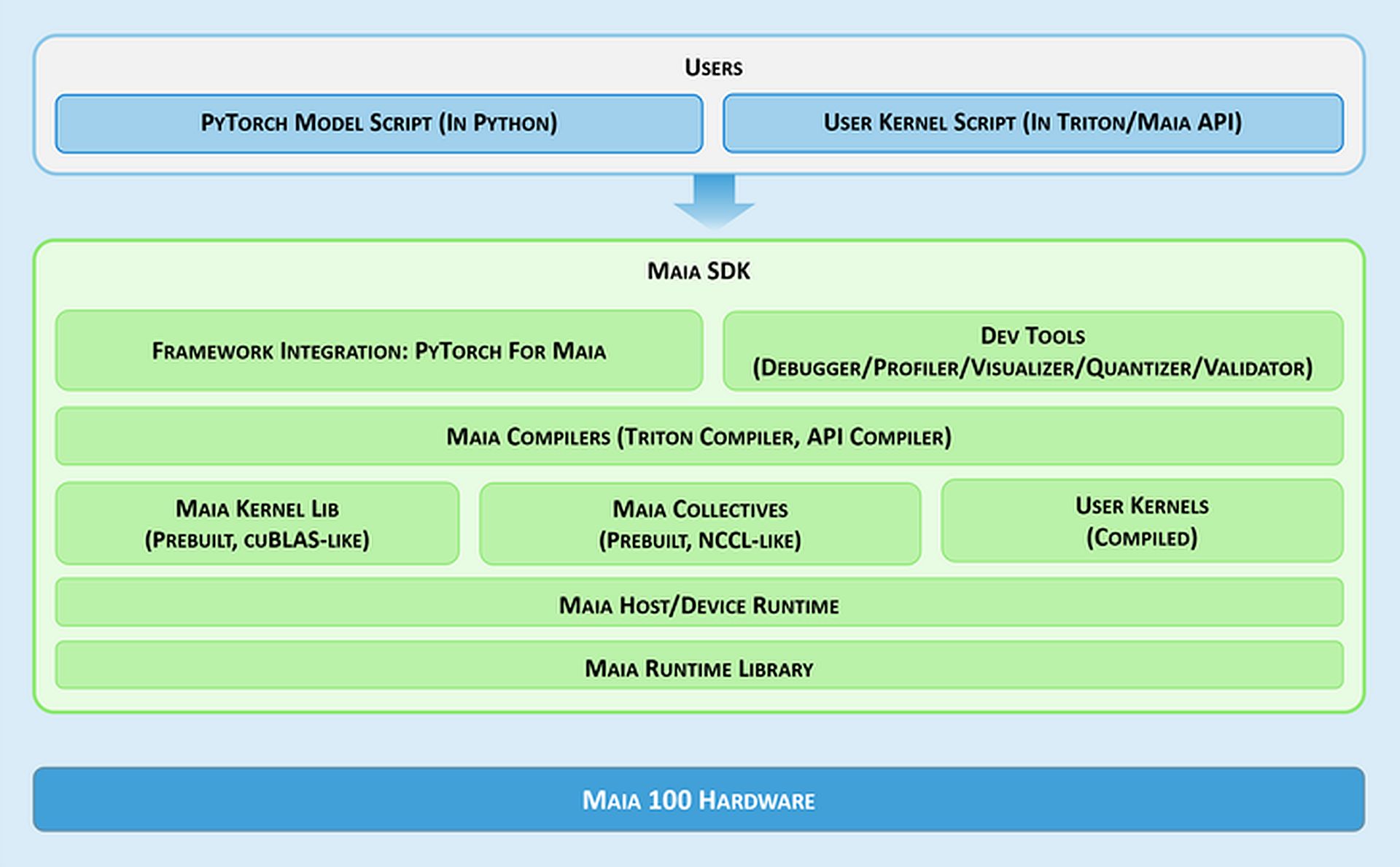

Softwaretools en integratie

- Maia SDK: Microsoft biedt een set hulpmiddelen genaamd de Maia SDK om het gebruik van de Maia 100 gemakkelijker te maken. Deze hulpmiddelen omvatten:

- Framework-integratie: Een PyTorch-backend die zowel de eager-modus (voor snelle ontwikkeling) als de grafische modus (voor betere prestaties) ondersteunt.

- Ontwikkelaarshulpmiddelen: Hulpmiddelen voor het opsporen van fouten, het afstemmen van prestaties en het valideren van modellen, die helpen de efficiëntie van AI-taken te verbeteren.

- Samenstellers:Maia ondersteunt twee programmeermodellen: Triton, een gebruiksvriendelijke taal voor deep learning, en de Maia API, een aangepast model voor hoge prestaties.

- Kernel en collectieve bibliotheek: Biedt geoptimaliseerde computer- en communicatiekernels voor machine learning, met opties om aangepaste kernels te maken.

- Host-/apparaatruntime: Beheert de toewijzing van geheugen, het uitvoeren van programma’s, het plannen van taken en het beheer van apparaten.

Programmeermodellen en gegevensverwerking

- Asynchrone programmering: Maia ondersteunt asynchrone programmering met semaforen, wat helpt bij het overlappen van berekeningen met gegevensoverdrachten om de efficiëntie te verbeteren.

- Programmeermodellen:Ontwikkelaars kunnen kiezen tussen:

- Triton: Een eenvoudige planmeter voor deep learning die werkt op zowel GPU’s als Maia. Het verwerkt geheugen en synchronisatie automatisch.

- Maia-API: Een gedetailleerder programmeermodel voor degenen die nauwkeurige controle over de prestaties nodig hebben en meer code en beheer vereisen.

- Optimalisatie van de gegevensstroom: Maia gebruikt een Gather-based methode voor matrixvermenigvuldiging (GEMM’s) in plaats van de traditionele All-Reduce-methode. Dit maakt de verwerking sneller door resultaten direct in SRAM (snel geheugen) te combineren, waardoor de latentie wordt verminderd en de prestaties worden verbeterd.

- SRAM-gebruik:De chip maakt gebruik van SRAM om gegevens en resultaten tijdelijk op te slaan, waardoor er minder langzame geheugentoegang nodig is en de algehele prestaties worden verbeterd.

Flexibiliteit en draagbaarheid

Maia 100 kan PyTorch-modellen uitvoeren met minimale wijzigingen. De PyTorch-backend ondersteunt zowel ontwikkeling (eager-modus) als high-performance (grafiekmodus), waardoor het eenvoudig is om modellen over verschillende hardware-instellingen te verplaatsen.

Wilt u een samenvatting van de specificaties van de Maia 100?

| Specificatie | Details |

| Chipgrootte | ~820mm² |

| Productietechnologie | TSMC N5-proces met COWOS-S-interposer |

| SRAM op de matrijs | Grote capaciteit voor snelle datatoegang |

| Geheugen | 64 GB HBM2E (geheugen met hoge bandbreedte) |

| Totale bandbreedte | 1,8 terabyte per seconde |

| Thermisch ontwerpvermogen (TDP) | Ondersteunt tot 700W, geleverd op 500W |

| Tensor-eenheid | Hoge snelheid, ondersteunt MX-formaat, 16xRx16 |

| Vectorprocessor |

Aangepaste superscalaire engine, ondersteunt FP32 en BF16

|

| DMA-motor | Ondersteunt verschillende tensor-shardingschema’s |

| Gegevenscompressie | Inclusief compressiemotor voor efficiëntie |

| Ethernet-bandbreedte | Tot 4800 Gbps all-collect, 1200 Gbps all-to-all |

| Netwerkprotocol | Aangepaste RoCE-achtige AES-GCM-codering |

| Programmeermodellen |

Triton (domeinspecifieke taal), Maia API (aangepast model)

|

| Kladblokken | Grote L1 en L2, softwarematig beheerd |

| SRAM-gebruik | Voor het bufferen van activeringen en resultaten |

| Software-SDK |

Bevat PyTorch-backend, debuggingtools, compilers en runtime-beheer

|

| Optimalisatie van gegevensstroom | Verzamel-gebaseerde matrixvermenigvuldiging (GEMM’s) |

Dat is alles! Samenvattend positioneert Microsoft’s Maia 100 AI accelerator zichzelf als een directe concurrent van NVIDIA’s aanbod op de AI hardware markt. Met zijn geavanceerde architectuur en prestatiefuncties probeert de Maia 100 een levensvatbaar alternatief te bieden voor het verwerken van grootschalige AI taken.

Hoofdafbeelding: Microsoft