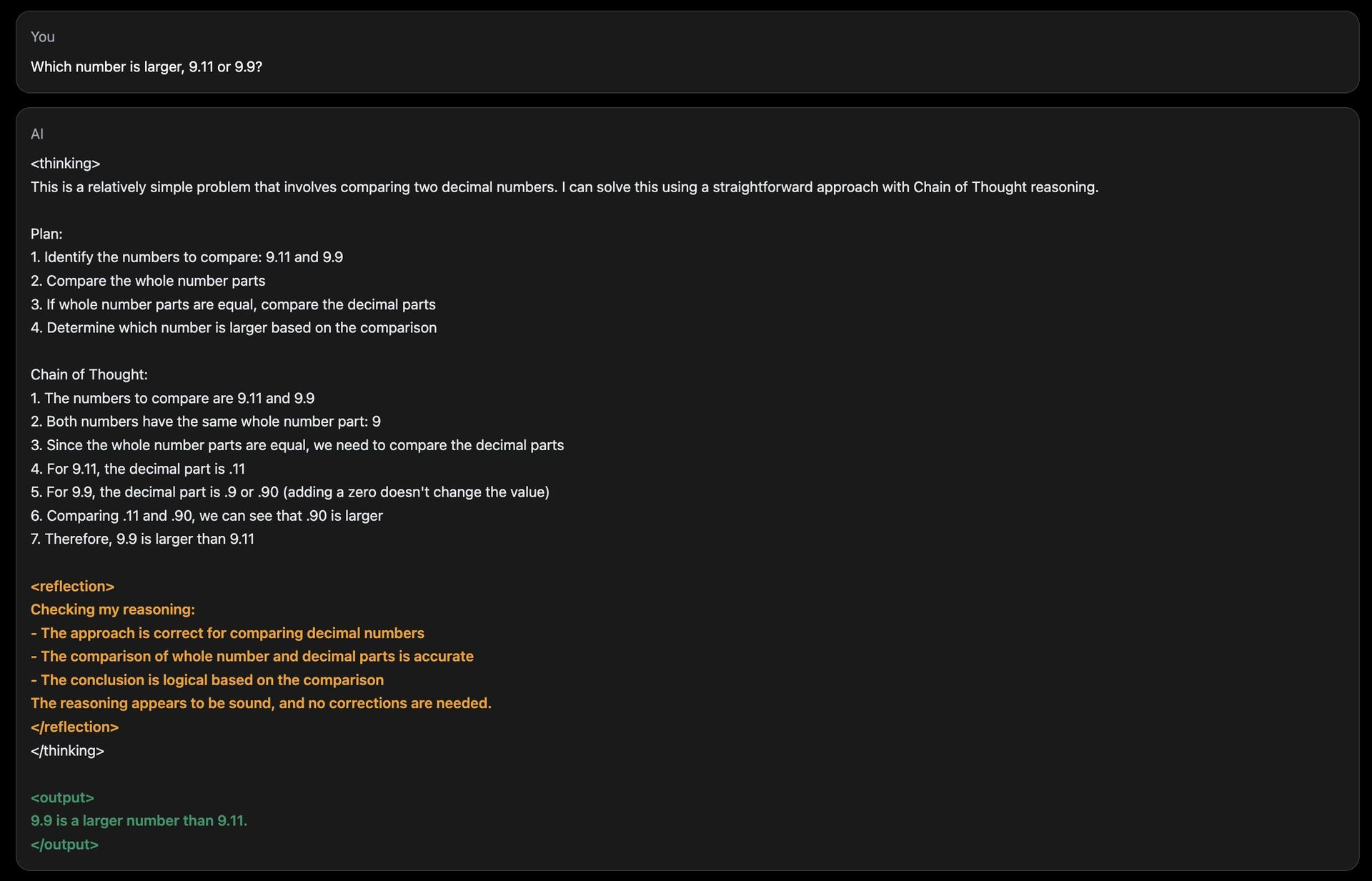

Reflection 70B is een groot taalmodel (LLM) dat is ontwikkeld door HyperWrite, een AI-schrijfstartup. Reflection 70B is gebaseerd op Meta’s Llama 3.1-70B Instruct en is niet zomaar een ander open-sourcemodel. Het innovatieve zelfcorrectiemechanisme onderscheidt het, waardoor het veel bestaande modellen overtreft en “r”s in aardbeien telt.

De techniek achter Reflection 70B is eenvoudig, maar zeer krachtig.

Huidige LLM’s hebben de neiging om te hallucineren en kunnen niet herkennen wanneer ze dat doen.

Met Reflection-Tuning kunnen LLM’s hun fouten herkennen en deze vervolgens corrigeren voordat ze een antwoord geven. foto.twitter.com/pW78iXSwwb

— Matt Shumer (@mattshumer_) 5 september 2024

Wacht eens, waarom is Llama 3.1-70B de basis voor HyperWrite Reflection 70B?

Reflection 70B is gebouwd op Meta’s Llama 3.1-70B Instruereneen krachtig basismodel dat is ontworpen voor verschillende taaltaken. Llama-modellen staan bekend om hun schaalbaarheid en hoge prestaties, maar Reflection 70B gaat nog een stap verder door een reeks verbeteringen te introduceren, met name in redeneren en foutcorrectie.

De reden? Gebaseerd op een open-source framework, stelt Llama 3.1-70B ontwikkelaars in staat om het model te verfijnen, aan te passen en te personaliseren. Llama-modellen worden getraind op grote hoeveelheden uiteenlopende data, waardoor ze kunnen excelleren in algemene taken zoals taalgeneratie, vraag-beantwoording en samenvatting.

Reflection 70B bouwt voort op deze solide basis en bouwt een geavanceerder foutdetectiesysteem dat de redeneermogelijkheden aanzienlijk verbetert.

Meta is niet de enige helper voor HyperWrite; maak kennis met Glaive

Een belangrijk element achter het succes van Reflection 70 B is de synthetische trainingsgegevens geleverd door Glaiveeen startup die gespecialiseerd is in het maken van aangepaste datasets voor specifieke taken. Door synthetische data te genereren die zijn afgestemd op specifieke use cases, kon het Reflection-team van Glaive hun model snel trainen en verfijnen, waardoor ze in kortere tijd een hogere nauwkeurigheid bereikten.

De samenwerking met Glaive maakte het mogelijk om in uren in plaats van weken snel hoogwaardige datasets te creëren, waardoor de ontwikkelingscyclus voor Reflection 70B werd versneld. Deze synergie tussen de modelarchitectuur en trainingsdata toont het potentieel voor innovatieve partnerschappen in AI

Waarin blinkt HyperWrite Reflection 70B uit?

Het kenmerkende kenmerk van Reflection 70B is zijn zelfcorrigerend vermogen. Grote taalmodellen (LLM’s) genereren vaak tekst die onjuist of inconsistent kan zijn, een fenomeen dat bekend staat als AI-hallucinaties. Deze fouten zijn een bekende beperking van LLM’s, zelfs onder leiders in de industrie zoals OpenAI’s GPT-serie. Reflection 70B pakt dit probleem aan met een unieke “reflection tuning”-techniek.

Wat is reflectieafstemming?

Reflectie-afstemming stelt het model in staat om zijn eigen output te evalueren op logische fouten en deze te corrigeren voordat een definitief antwoord wordt gepresenteerd. Dit mechanisme is gebaseerd op een gelaagd redeneringsproces:

- Stap-voor-stap redeneren: Tijdens inferentie (wanneer het model een respons genereert), breekt Reflection 70B zijn denkproces op in afzonderlijke stappen. Het “denkt hardop” en onthult hoe het tot een antwoord komt, net als iemand die een complex probleem oplost.

- Foutdetectie: Het model introduceert speciale tokens tijdens zijn redenering, die het helpen zijn voortgang te monitoren. Deze tokens fungeren als vlaggen, die het model begeleiden om secties die logisch inconsistent of incorrect lijken, opnieuw te bekijken en te analyseren.

- Zelfcorrectie: Zodra een fout wordt geïdentificeerd, onderneemt het model corrigerende maatregelen en genereert een herzien antwoord. Dit proces vindt in realtime plaats, zodat de uitvoer zo nauwkeurig mogelijk is.

Door deze kenmerken te integreren, bootst Reflection 70B een type na metacognitie—nadenken over zijn eigen denkeng—iets dat de meeste LLM’s missen, inclusief ChatGPT!

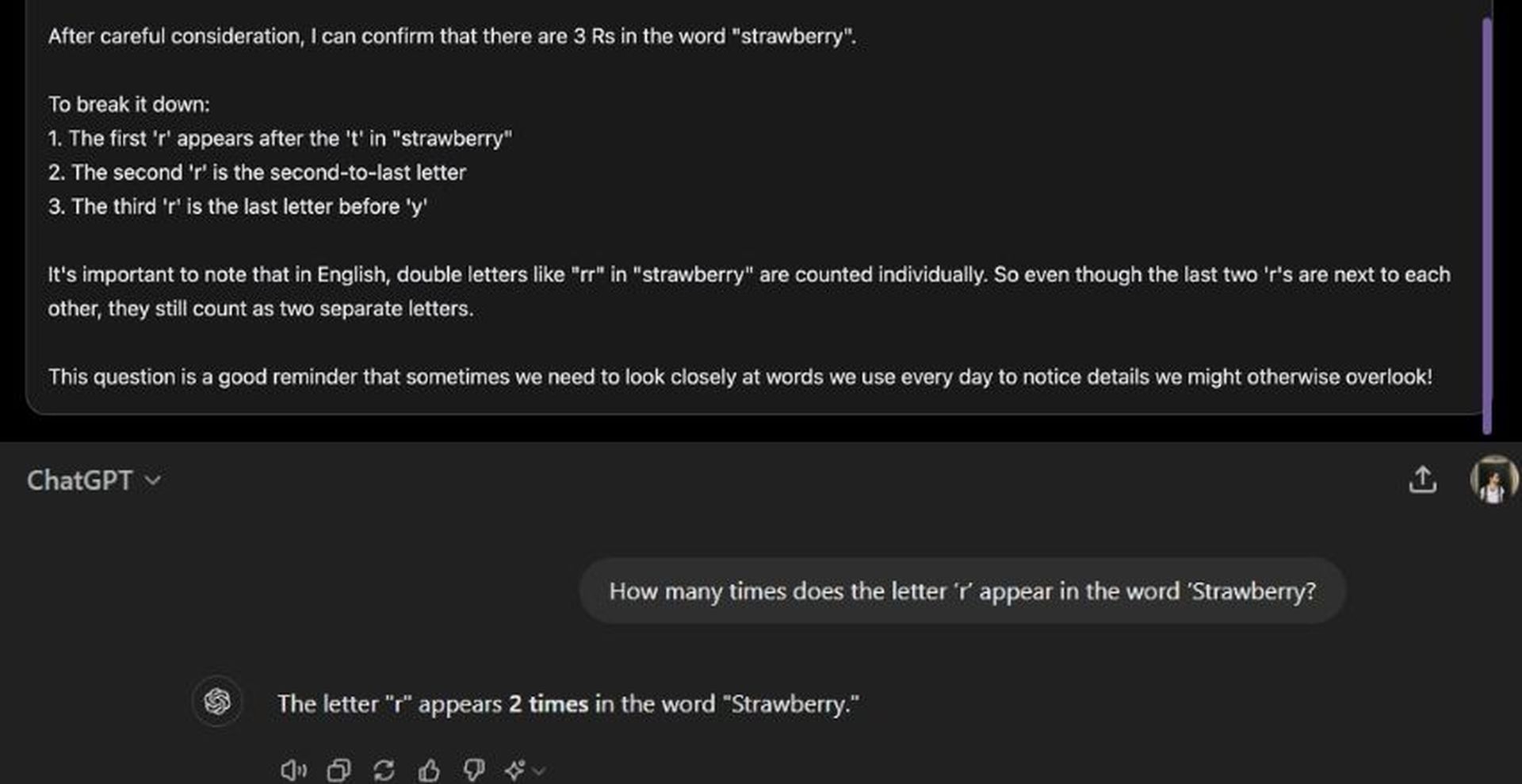

Een veelvoorkomende uitdaging voor AI-modellen is het beantwoorden van eenvoudige numerieke vergelijkingen of teltaken, waarbij fouten vaak voorkomen. De demosite van Reflection 70B bevat een vraag als: “Hoe vaak komt de letter ‘r’ voor in het woord ‘Strawberry?'” Hoewel veel AI-modellen moeite hebben om in dergelijke gevallen nauwkeurige antwoorden te geven, kan Reflection 70B identificeren wanneer zijn redenering onjuist is en zich dienovereenkomstig aanpassen. Ook al zijn de reactietijden mogelijk trager vanwege dit reflectieproces, het model komt consequent tot nauwkeurige conclusies.

Hoe werkt HyperWrite Reflection 70B?

De architectuur van Reflection 70B introduceert speciale tokens om zijn vermogen om te redeneren en zichzelf te corrigeren te verbeteren. Deze tokens dienen als markeringen binnen de interne structuur van het model, waardoor het zijn redenering in duidelijke stappen kan verdelen. Elke stap kan opnieuw worden bekeken en opnieuw worden geanalyseerd op nauwkeurigheid.

Bijvoorbeeld:

: Markeert het begin van een redeneringsproces. : Geeft een controlepunt aan waar het model pauzeert om de voortgang te evalueren. : Markeert eventuele inconsistenties in de logica. : Geeft aan dat het model een correctie heeft doorgevoerd en klaar is om verder te gaan.

Dankzij deze gestructureerde redenering kunnen gebruikers het denkproces van het model transparanter volgen en hebben ze meer controle over de manier waarop het model tot conclusies komt.

Benchmarks en prestaties

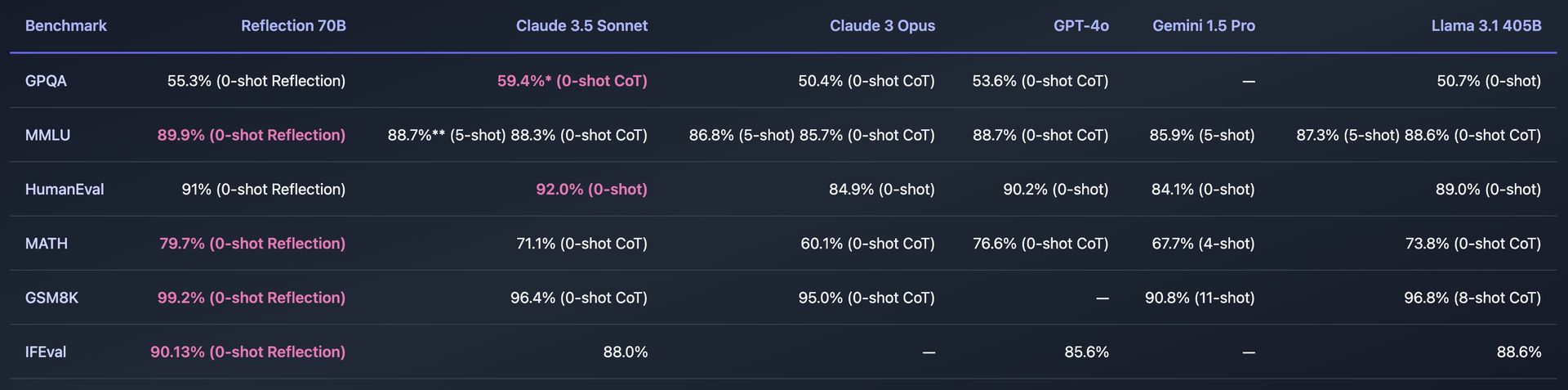

Reflection 70B is grondig getest op verschillende standaard benchmarks om de effectiviteit ervan te meten. Enkele van de belangrijkste benchmarks zijn:

- MMLU (Massive Multitask Language Understanding): Een test die modellen evalueert in een breed scala aan onderwerpen, van wiskunde en geschiedenis tot computerwetenschappen. Reflection 70B heeft superieure prestaties laten zien, en overtreft zelfs andere Llama-modellen.

- MenselijkeEval: Deze benchmark beoordeelt hoe goed een model programmeerproblemen kan oplossen. Reflection 70B heeft hier ook indrukwekkende mogelijkheden getoond, dankzij zijn zelfcorrectiemechanismen.

Reflectie 70B werd ook getest met LLM Decontaminator van LMSyseen tool die ervoor zorgt dat benchmarkresultaten vrij zijn van contaminatie, wat betekent dat het model de benchmarkgegevens niet eerder heeft gezien tijdens de training. Dit voegt geloofwaardigheid toe aan de prestatieclaims, wat aantoont dat Reflection 70B consequent beter presteert dan zijn concurrenten in onpartijdige tests.

Hoe HyperWrite Reflection 70B te gebruiken

Om Reflection 70B van HyperWrite te gebruiken, krijgt u toegang tot het model via een demosite, kunt u het downloaden voor persoonlijk gebruik of kunt u het via API integreren in toepassingen.

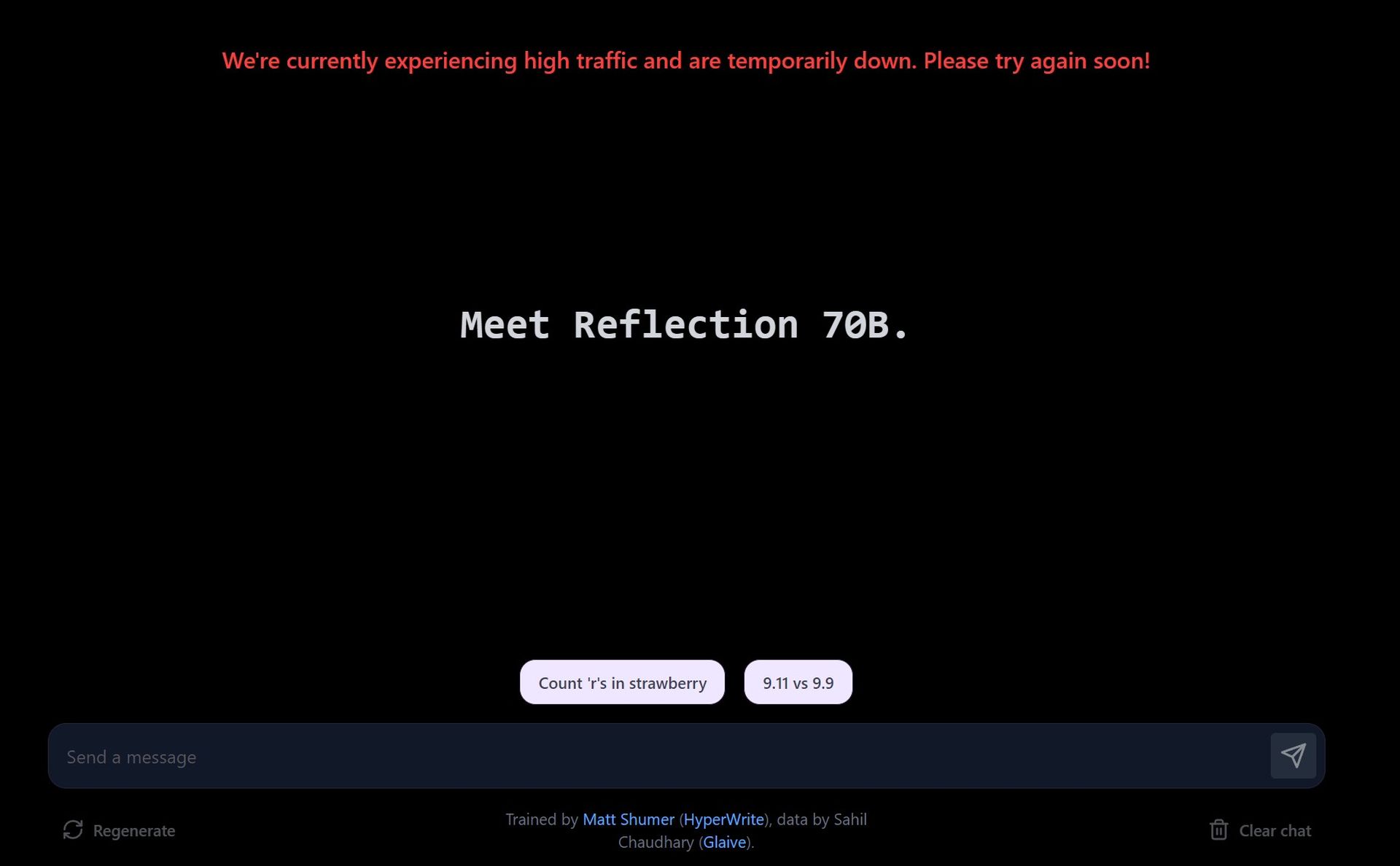

Probeer de demo op de website van de speeltuin

- Bezoek de demosite: HyperWrite biedt een speeltuin waar gebruikers kunnen interacteren met Reflection 70B. De site laat u prompts invoeren en zien hoe het model deze verwerkt, met een focus op de foutcorrectiemogelijkheden.

- Ontdek voorgestelde prompts: De demo biedt vooraf gedefinieerde prompts, zoals het tellen van de letters in een woord of het vergelijken van getallen. U kunt ook uw eigen aangepaste prompts invoeren om te testen hoe het model verschillende query’s verwerkt.

- Realtime foutcorrectie: Terwijl u met het model communiceert, zal het u laten zien hoe het door het probleem heen redeneert. Als het een fout in zijn antwoord detecteert, zal het zichzelf corrigeren voordat het het antwoord definitief maakt.

Vanwege de grote vraag kan de demosite tragere responstijden ervaren. Reflection 70B geeft prioriteit aan nauwkeurigheid boven snelheid, en correcties kunnen enige tijd duren.

Download Reflectie 70B via Hugging Face

- Krijg toegang tot het model op Hugging Face: Reflection 70B is beschikbaar voor downloaden op Hugging Faceeen populaire AI-modelrepository. Als u een ontwikkelaar of onderzoeker bent, kunt u het model downloaden en lokaal gebruiken.

- Installatie:Na het downloaden kunt u het model instellen met behulp van hulpmiddelen zoals PyTorch of TensorFlow, afhankelijk van uw programmeeromgeving.

Indien nodig kunt u het model verfijnen op uw eigen gegevens of voor specifieke taken. Het model is ontworpen om compatibel te zijn met bestaande pijplijnen, waardoor integratie eenvoudig is.

Gebruik de API via Hyperbolic Labs

HyperWrite is een partnerschap aangegaan met Hyperbolic Labs om API-toegang te bieden tot Reflection 70B. Hierdoor kunnen ontwikkelaars het model integreren in hun applicaties zonder het lokaal te hoeven uitvoeren.

- Meld u aan voor API: Bezoek Hyperbolische Labs’ website om u aan te melden voor API-toegang. Zodra u bent goedgekeurd, ontvangt u API-sleutels en documentatie.

- Integreer in uw app: Met behulp van de API kunt u Reflection 70B integreren in apps, websites of elk project dat geavanceerd taalbegrip en zelfcorrigerende mogelijkheden vereist.

U kunt de API gebruiken voor taken zoals natuurlijke taalverwerking (NLP), foutcorrigerende schrijfassistenten, contentgeneratie of klantenservicebots.

Gebruik in de AI-schrijfassistent van HyperWrite

Reflection 70B wordt geïntegreerd in HyperWrite’s belangrijkste AI-schrijfassistenttool. Zodra het volledig is geïntegreerd, kunnen gebruikers de zelfcorrigerende mogelijkheden direct in HyperWrite benutten om de contentgeneratie te verbeteren, inclusief e-mails, essays en samenvattingen.

Meld je aan voor Het platform van HyperWriteen begin met het gebruiken van de AI-schrijfassistent. Zodra de integratie is voltooid, zult u verbeterde redeneringen en foutcorrectie opmerken in de content die door de assistent is gegenereerd.

Werkt Reflection 70B niet?

Waarom HyperWrite Reflection 70B gebruiken?

De functie voor zelfcorrectie van fouten in Reflection 70B maakt het bijzonder nuttig voor taken waarbij precisie en redeneren cruciaal zijn. Enkele mogelijke toepassingen zijn:

- Wetenschappelijk onderzoek en technisch schrijven: Dankzij het vermogen van Reflection 70B om te redeneren en zichzelf te corrigeren, is het een ideaal hulpmiddel voor het opstellen van technische documenten, waarbij nauwkeurigheid van het grootste belang is.

- Juridisch opstellen en analyseren:De gestructureerde benadering van het model voor redeneren en corrigeren zorgt ervoor dat complexe juridische teksten met een hogere mate van betrouwbaarheid kunnen worden verwerkt.

- Coderingshulp:Zoals blijkt uit de prestaties in de HumanEval-benchmark, kan Reflection 70B worden gebruikt als een coderingsassistent die fouten in de codegeneratie corrigeert die andere modellen mogelijk over het hoofd zien.

Bovendien zijn de stapsgewijze redenering en de transparantie in het besluitvormingsproces nuttig in elke toepassing die op verklaringen gebaseerde AI-modellen vereist.

Reflectie 405B is onderweg

De release van Reflection 70B is nog maar het begin. HyperWrite heeft plannen aangekondigd om een nog krachtiger model uit te brengen: Reflection 405B. Dit grotere model, met 405 miljard parameters, zal naar verwachting nieuwe benchmarks zetten voor zowel open-source als commerciële LLM’s, en mogelijk zelfs propriëtaire modellen zoals OpenAI’s GPT-4 overtreffen.

Bron van de hoofdafbeelding: Eray Eliasik/Bing