In een wereld die wordt gedomineerd door opgeblazen AI-modellen die in de cloud leven, draait Mistral AI het script om. De Franse startup net losgelaten twee nieuwe modellen – Ministral 3B en 8B – die zijn ontworpen om op edge-apparaten te draaien.

Les Ministraux: Ministral 3B en 8B

Het nieuwe aanbod van Mistral, genaamd “Les Ministraux”, klinkt misschien als een Franse arthouse-film, maar deze modellen staan klaar om de AI-wereld op te schudden. Met respectievelijk slechts 3 miljard en 8 miljard parameters draait alles bij de Ministraux-familie om efficiëntie. Vergeet die AI-modellen die veel middelen vergen en waarvoor een datacenter nodig is om te kunnen functioneren.

“Onze meest innovatieve klanten en partners vragen steeds vaker om lokale, privacy-eerste inferentie voor kritieke toepassingen”, legt Mistral uit.

Contextlengte als nooit tevoren

Hier wordt het echt pittig: zowel de 3B- als de 8B-modellen kunnen een contextvenster van 128.000 tokens aan. Dat is het equivalent van een boek van 50 pagina’s. Ter vergelijking, zelfs OpenAI’s GPT-4-turbo komt neer op ongeveer hetzelfde aantal tokens, en dat is geen geringe prestatie.

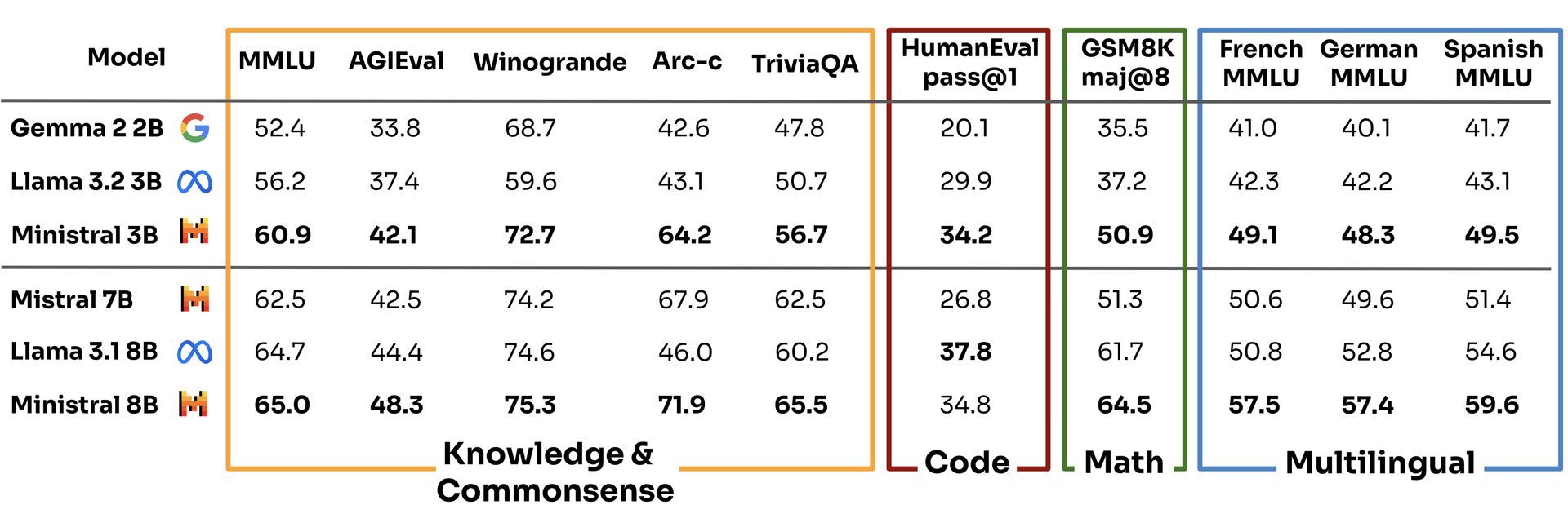

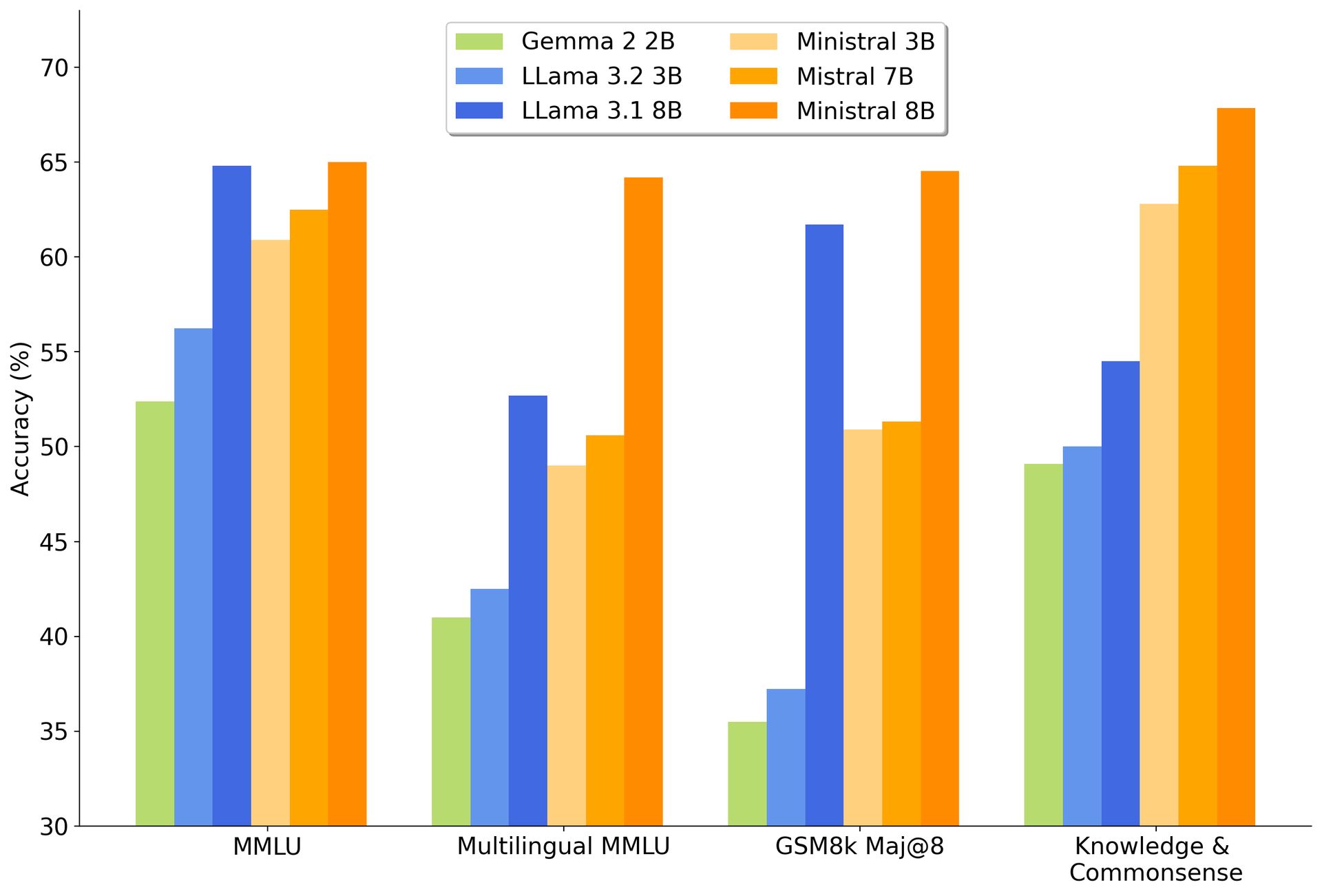

Met dit soort capaciteit presteren de Ministraux-modellen niet alleen beter dan hun voorganger, de Mistral 7B, ze eten ook die van Google op. Gemma 2 2B En Meta’s Llama-modellen voor ontbijt.

Volgens de eigen benchmarks van Mistral scoorde het 3B-model 60,9 in de Multi-task Language Understanding-evaluatie, waardoor concurrenten als Llama 3.2 3B en Gemma 2 2B achterbleven op respectievelijk 56,2 en 52,4.

Niet slecht voor een “kleiner” model, toch?

Terwijl alle anderen in de AI-wereld zich inspannen om grotere, slechtere modellen te maken die energie verslinden, speelt Mistral een ander spel. Door op lokale apparaten te draaien, heeft Les Ministraux de behoefte aan enorme cloudservers weggenomen en daarmee een veel milieuvriendelijkere optie geboden. Het is een stap die perfect aansluit bij de toenemende druk op technologiebedrijven om milieubewuster te zijn. AI is misschien wel de toekomst, maar niemand wil dat die toekomst ten koste gaat van de planeet.

Er is ook de privacyhoek. Omdat alles lokaal draait, blijven uw gegevens op uw apparaat staan, wat een enorme winst is voor sectoren als de gezondheidszorg en de financiële sector, die steeds meer onder de loep worden genomen als het gaat om de manier waarop zij met gevoelige informatie omgaan. Je kunt het zien als AI zonder rondsnuffelen: een verfrissende verandering in een wereld waarin elke app meer gegevens lijkt te verzamelen dan de NSA.

Het masterplan van Mistral: bouwen, ontwrichten, herhalen

Maar laten we onszelf niet voor de gek houden: Mistral doet dit niet alleen voor het algemeen belang. Het bedrijf, mede opgericht door alumni van Meta en Google’s DeepMind, wil furore maken. Ze hebben al 640 miljoen dollar aan durfkapitaal opgehaald en zijn zeer gefocust op het bouwen van AI-modellen die niet alleen kunnen wedijveren met die van OpenAI’s GPT-4 en Claude van Anthropic, maar daarbij ook winst kunnen maken.

En hoewel geld verdienen in de generatieve AI-ruimte ongeveer net zo eenvoudig is als het winnen van de loterij, geeft Mistral niet terug. Sterker nog, ze zijn afgelopen zomer begonnen met het genereren van inkomsten, wat meer is dan je van veel van hun concurrenten kunt zeggen.

Door Ministral 8B aan te bieden voor onderzoeksdoeleinden en beide modellen beschikbaar te stellen via hun cloudplatform La Platforme, positioneert Mistral zichzelf als de coole jongen op het AI-blok: open genoeg om ontwikkelaars aan te trekken, maar slim genoeg om geld te verdienen met zijn technologie via strategische partnerschappen. Het is een hybride aanpak die weerspiegelt wat open-sourcegiganten als Red Hat deden in de Linux-wereld: het bevorderen van de gemeenschap terwijl de kassa’s rinkelden.

Afbeeldingscredits: Mistral