Jarenlang voelde de belofte van echt intelligente, conversationele AI buiten bereik. We hebben ons verwonderd over de mogelijkheden van ChatGPT, Tweelingen andere grote taalmodellen (LLM’s) – gedichten schrijven, code schrijven, talen vertalen – maar deze prestaties zijn altijd afhankelijk geweest van de enorme verwerkingskracht van cloud-GPU’s. Nu is er een stille revolutie aan de gang, met als doel deze ongelooflijke mogelijkheden rechtstreeks naar het apparaat in uw zak te brengen: een LLM op uw smartphone.

Deze verschuiving gaat niet alleen over gemak; het gaat over privacy, efficiëntie en het ontsluiten van een nieuwe wereld van gepersonaliseerde AI-ervaringen.

Het verkleinen van deze enorme LLM’s zodat ze op een apparaat met een beperkt geheugen en een beperkte batterijduur passen, brengt echter een unieke reeks uitdagingen met zich mee. Om dit complexe landschap te begrijpen, sprak ik met Aleksej Naumovhoofd AI-onderzoeksingenieur bij Terra Quantumeen leidende figuur op het gebied van LLM-compressie.

Naumov heeft onlangs een artikel over dit onderwerp gepubliceerd dat wordt aangekondigd als een buitengewone en belangrijke innovatie op het gebied van compressie van neurale netwerken – ‘TQCompressor: Verbetering van tensor-decompositiemethoden in neurale netwerken via permutaties‘ – op de IEEE International Conference on Multimedia Information Processing and Retrieval (IEEE MIPR 2024), een conferentie waar onderzoekers, wetenschappers en professionals uit de industrie samenkomen om de nieuwste ontwikkelingen op het gebied van multimediatechnologie te presenteren en te bespreken.

“De grootste uitdaging is natuurlijk het beperkte hoofdgeheugen (DRAM) dat beschikbaar is op smartphones”, aldus Naumov. “De meeste modellen passen niet in het geheugen van een smartphone, waardoor het onmogelijk is om ze te gebruiken.”

Hij wijst op Meta’s Llama 3.2-8B-model als goed voorbeeld.

“Het vereist ongeveer 15 GB geheugen”, zei Naumov. “De iPhone 16 heeft echter slechts 8 GB DRAM en de Google Pixel 9 Pro biedt 16 GB. Om deze modellen efficiënt te laten werken, heb je bovendien zelfs nog meer geheugen nodig – ongeveer 24 GB, dat wordt aangeboden door apparaten als de NVIDIA RTX 4090 GPU, vanaf $ 1800.”

Deze geheugenbeperking gaat niet alleen over opslag; het heeft een directe invloed op de levensduur van de batterij van een telefoon.

“Hoe meer geheugen een model nodig heeft, hoe sneller de batterij leegraakt”, zegt Naumov. “Een LLM met een parameter van 8 miljard verbruikt ongeveer 0,8 joule per token. Een volledig opgeladen iPhone, met ongeveer 50 kJ aan energie, zou dit model slechts ongeveer twee uur kunnen volhouden met een snelheid van 10 tokens per seconde, waarbij elke 64 tokens ongeveer 0,2% van de batterij verbruiken.”

Hoe kunnen we deze hindernissen overwinnen? Naumov benadrukt het belang van modelcompressietechnieken.

“Om dit aan te pakken, moeten we de modelgroottes verkleinen”, zei Naumov. “Er zijn twee primaire benaderingen: het verminderen van het aantal parameters of het verminderen van het geheugen dat elke parameter nodig heeft.”

Hij schetst strategieën zoals destillatie, snoeien en matrixontleding om het aantal parameters te verminderen, en kwantisering om de geheugenvoetafdruk van elke parameter te verkleinen.

“Door modelparameters op te slaan in INT8 in plaats van FP16, kunnen we het geheugengebruik met ongeveer 50% verminderen”, aldus Naumov.

Hoewel de Pixel-apparaten van Google, met hun voor TensorFlow geoptimaliseerde TPU’s, een ideaal platform lijken voor het uitvoeren van LLM’s, waarschuwt Naumov dat ze het fundamentele probleem van geheugenbeperkingen niet oplossen.

“Hoewel de Tensor Processing Units (TPU’s) die in Google Pixel-apparaten worden gebruikt, betere prestaties bieden bij het uitvoeren van AI-modellen, wat kan leiden tot snellere verwerkingssnelheden of een lager batterijverbruik, lossen ze het fundamentele probleem van de enorme geheugenvereisten van moderne LLM’s niet op. , die doorgaans de geheugencapaciteit van smartphones overschrijden”, aldus Naumov.

De drang om LLM’s naar smartphones te brengen gaat verder dan louter technische ambitie. Het gaat over het opnieuw vormgeven van onze relatie met AI en het aanpakken van de beperkingen van cloudgebaseerde oplossingen.

“Toonaangevende modellen zoals ChatGPT-4 hebben meer dan een biljoen parameters”, zegt Naumov. “Als we ons een toekomst voorstellen waarin mensen sterk afhankelijk zijn van LLM’s voor taken als gespreksinterfaces of aanbevelingssystemen, zou dit kunnen betekenen dat ongeveer 5% van de dagelijkse tijd van gebruikers wordt besteed aan interactie met deze modellen. In dit scenario zou het gebruik van GPT-4 ongeveer 100 miljoen H100 GPU’s vereisen. Alleen al de rekenschaal, zonder rekening te houden met de overheadkosten voor communicatie en datatransmissie, zou gelijk staan aan het runnen van ongeveer 160 bedrijven ter grootte van Meta. Dit niveau van energieverbruik en de daarmee samenhangende CO2-uitstoot zouden aanzienlijke milieuproblemen met zich meebrengen.”

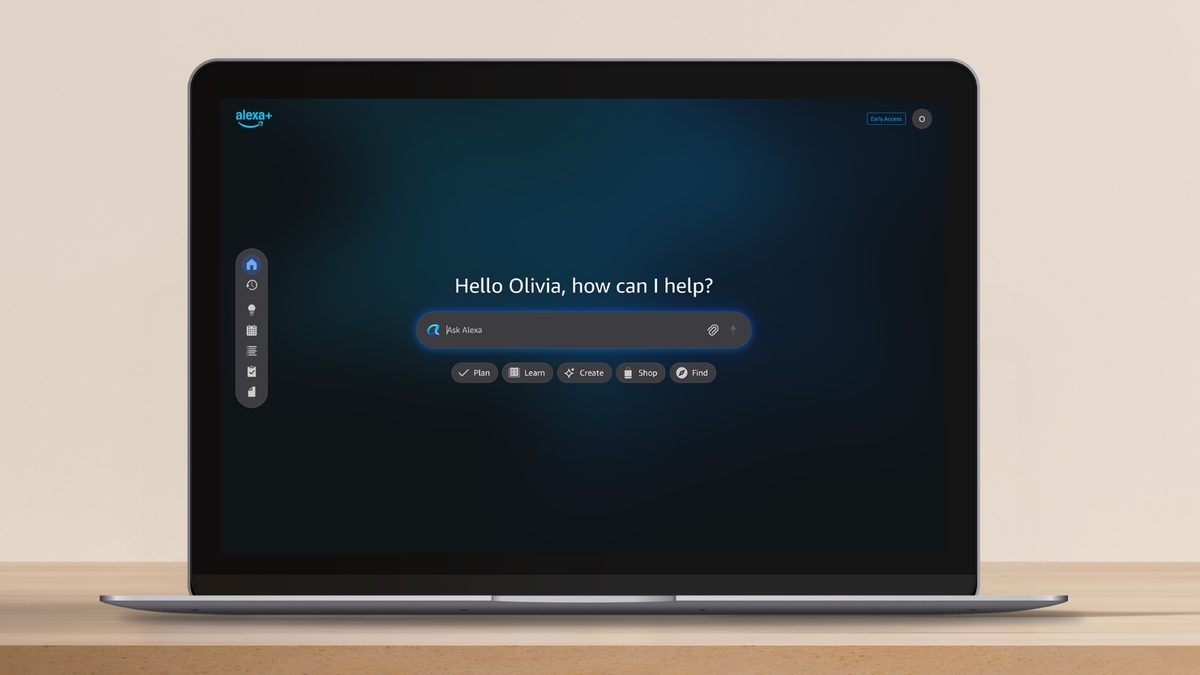

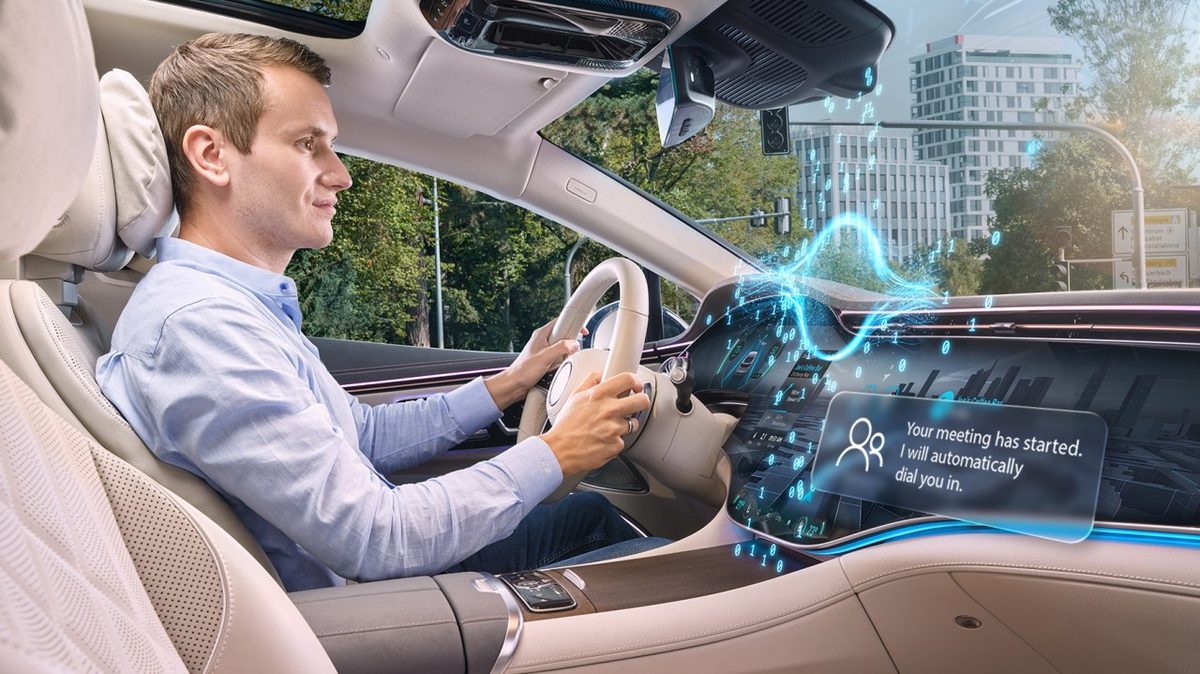

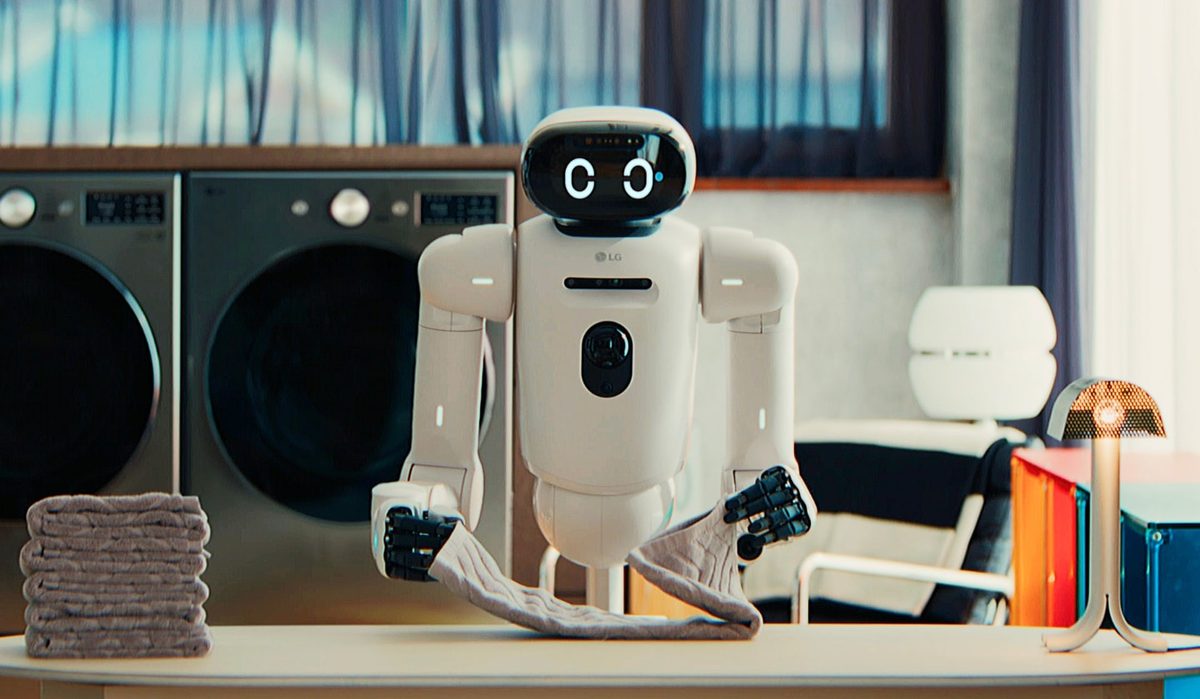

De visie is duidelijk: een toekomst waarin AI naadloos wordt geïntegreerd in ons dagelijks leven en gepersonaliseerde hulp biedt zonder de privacy in gevaar te brengen of de batterijen van onze telefoons leeg te trekken.

“Ik voorzie dat veel LLM-applicaties die momenteel afhankelijk zijn van cloud computing zullen overstappen naar lokale verwerking op de apparaten van gebruikers”, aldus Naumov. “Deze verschuiving zal worden aangedreven door verdere inkrimping van het model en verbeteringen in de computerbronnen en efficiëntie van smartphones.”

Hij schetst een beeld van een toekomst waarin de mogelijkheden van LLM’s net zo alledaags en intuïtief kunnen worden als autocorrectie vandaag de dag is. Deze transitie zou veel opwindende mogelijkheden kunnen ontsluiten. Dankzij lokale LLM’s kunt u zich een verbeterde privacy voorstellen waarbij uw gevoelige gegevens uw apparaat nooit verlaten.

Stel je de alomtegenwoordige AI voor met LLM-mogelijkheden geïntegreerd in vrijwel elke app, van berichten en e-mail tot productiviteitstools. Denk aan het gemak van offline functionaliteit, waardoor je ook zonder internetverbinding toegang hebt tot AI-hulp. Stel u gepersonaliseerde ervaringen voor waarin LLM’s uw voorkeuren en gewoonten leren kennen om echt op maat gemaakte ondersteuning te bieden.

Voor ontwikkelaars die graag deze grens willen verkennen, biedt Naumov praktisch advies.

“Ten eerste raad ik aan een model te selecteren dat het beste bij de beoogde toepassing past”, zei Naumov. “Hugging Face is hiervoor een uitstekend hulpmiddel. Zoek naar recente modellen met 1-3 miljard parameters, aangezien dit de enige zijn die momenteel haalbaar zijn voor smartphones. Probeer bovendien gekwantiseerde versies van deze modellen te vinden op Hugging Face. De AI-gemeenschap publiceert daar doorgaans gekwantiseerde versies van populaire modellen.”

Hij stelt ook voor om tools zoals lama.cpp En bitsandbytes voor modelkwantisering en gevolgtrekking.

De reis om LLM’s naar smartphones te brengen bevindt zich nog in de beginfase, maar het potentieel valt niet te ontkennen. Terwijl onderzoekers als Aleksei Naumov de grenzen blijven verleggen van wat mogelijk is, staan we aan de vooravond van een nieuw tijdperk in mobiele AI, een tijdperk waarin onze smartphones werkelijk intelligente metgezellen worden, die in staat zijn onze behoeften te begrijpen en erop te reageren op manieren die we tot nu toe hebben gedaan. begon het zich pas voor te stellen.