Op de laatste AI-conferentie hadden we de kans om met Roman Shaposhnik en Tanya Dadasheva, de medeoprichters van Ainekko/AIFoundry, om de tafel te zitten en met hen een dubbelzinnig onderwerp te bespreken: datawaarde voor ondernemingen in de tijd van AI. Een van de belangrijkste vragen van waaruit we vertrokken was: gebruiken de meeste bedrijven dezelfde grensverleggende AI-modellen, is het opnemen van hun data de enige manier waarop ze zich kunnen onderscheiden? Zijn data echt een slotgracht voor ondernemingen?

Roman herinnert zich: “In 2009, toen hij in de big data-gemeenschap begon, had iedereen het erover hoe bedrijven zouden transformeren door gebruik te maken van data. Destijds waren het nog niet eens digitale ondernemingen; de digitale transformatie had nog niet plaatsgevonden. Dit waren grotendeels analoge ondernemingen, maar ze benadrukten al de waarde van de gegevens die ze verzamelden: gegevens over hun klanten, transacties, toeleveringsketens en meer. Mensen vergeleken data met olie, iets met een inherente waarde dat eruit gehaald moest worden om het ware potentieel ervan te realiseren.”

Olie is echter een handelsartikel. Als we de gegevens vergelijken met olie, suggereert dit dat iedereen toegang heeft tot dezelfde gegevens, zij het in verschillende hoeveelheden en voor sommigen gemakkelijker te oogsten. Door deze vergelijking voelen gegevens aan als handelswaar, voor iedereen beschikbaar, maar op verschillende manieren verwerkt.

Wanneer gegevens zich in hun ruwe vorm in een datawarehouse van een onderneming bevinden, is het als een amorfe klodder: een goed dat iedereen heeft. Maar zodra je begint met het verfijnen, komt de echte waarde naar voren. Het gaat niet alleen om het verzamelen van gegevens, maar om het opbouwen van een proces van extractie tot het verfijnen van alle waarde via de pijplijn.

“Interessant genoeg doet dit mij denken aan iets dat een directeur van een oliemaatschappij mij ooit vertelde” – deelt Roman. “Die directeur beschreef het bedrijf niet als het winnen van olie, maar als het herconfigureren van koolstofmoleculen. Olie was voor hen slechts een bron van koolstof. Ze hadden toeleveringsketens gebouwd die deze koolstofmoleculen konden herconfigureren tot producten die waren afgestemd op de marktvraag op verschillende locaties: plastic, benzine, wat de behoefte ook was. Hij stelde zich softwaregedefinieerde raffinaderijen voor die de output konden aanpassen op basis van realtime marktbehoeften. Dit concept heeft mij versteld doen staan, en ik denk dat het parallel loopt met wat we nu in data zien: rekenkracht naar data brengen, deze verfijnen om te krijgen wat je nodig hebt, waar je het nodig hebt” – was het inzicht van Roman.

Als je in ondernemingen begint met het verzamelen van gegevens, realiseer je je dat deze gefragmenteerd zijn en op veel plaatsen vastzitten in mainframes of verspreid zijn over systemen als Salesforce. Zelfs als het je lukt om het te verzamelen, zijn er zoveel silo’s en hebben we een fracking-achtige aanpak nodig om de waardevolle delen eruit te halen. Net zoals bij fracking olie wordt gewonnen uit plaatsen die voorheen onbereikbaar waren, hebben we methoden nodig om bedrijfsgegevens te verkrijgen die anders verborgen zouden blijven.

Veel bedrijfsgegevens bevinden zich nog steeds in mainframes en het is een uitdaging om deze naar buiten te krijgen. Hier is een leuk feit: als je vandaag een vlucht boekt, is de kans groot dat de backend nog steeds een mainframe raakt. Het gaat niet alleen om het één keer extraheren van die gegevens; je hebt er continue toegang toe nodig. Veel bedrijven maken er hun werk van om bedrijven te helpen gegevens uit oude systemen te halen, en tools als Apache Airflow helpen deze processen te stroomlijnen.

Maar zelfs als data niet langer vastzitten in mainframes, zijn ze nog steeds gefragmenteerd over systemen zoals cloud-SaaS-services of datalakes. Dit betekent dat bedrijven niet al hun gegevens op één plek hebben, en dat deze zeker niet zo toegankelijk of actueel zijn als ze nodig hebben. Je zou kunnen denken dat het je een voordeel zou opleveren als je helemaal opnieuw zou beginnen, maar zelfs nieuwere systemen zijn afhankelijk van meerdere partners, en die partners beheren delen van de gegevens die je nodig hebt.

Het hele idee van data als een slotgracht blijkt dan misleidend. Conceptueel gezien zijn ondernemingen eigenaar van hun data, maar hebben ze vaak geen echte toegang. Een onderneming die Salesforce gebruikt, is bijvoorbeeld eigenaar van de gegevens, maar de daadwerkelijke controle over en toegang tot die gegevens wordt beperkt door Salesforce. Het onderscheid tussen het bezitten en hebben van gegevens is aanzienlijk.

“Het wordt nog ingewikkelder als AI erbij betrokken raakt” – zegt Tanya Dadasheva, een andere mede-oprichter van AInekko en AIFoundry.org. “Een onderneming kan data bezitten, maar dat betekent niet noodzakelijkerwijs dat een bedrijf als Salesforce deze kan gebruiken om modellen te trainen. Er is ook een discussie over de vraag of geanonimiseerde gegevens kunnen worden gebruikt voor training. Juridisch gezien is dit een grijs gebied. Over het algemeen geldt dat hoe meer gegevens worden geanonimiseerd, hoe minder waarde ze hebben. Op een gegeven moment wordt het verkrijgen van expliciete toestemming de enige weg vooruit”.

Deze eigendomskwestie reikt verder dan alleen ondernemingen; het heeft ook gevolgen voor eindgebruikers. Gebruikers gaan er vaak mee akkoord om gegevens te delen, maar het kan zijn dat ze er niet mee akkoord gaan dat deze worden gebruikt voor trainingsmodellen. Er zijn gevallen geweest van reverse-engineering van gegevens uit modellen, wat tot potentiële inbreuken op de privacy heeft geleid.

In een vroeg stadium van het balanceren van dataproducenten, dataconsumenten en de entiteiten die data verfijnen, is het juridisch en technologisch uiterst complex om uit te zoeken hoe deze relaties zullen werken. Europa kent bijvoorbeeld veel strengere privacyregels vergeleken met de Verenigde Staten (https://artificialintelligenceact.eu/). In de VS zoekt het rechtssysteem dingen vaak onderweg uit, terwijl Europa er de voorkeur aan geeft vooraf wetten vast te stellen.

Tanya gaat hier in op de beschikbaarheid van gegevens: “Dit hangt allemaal samen met de waarde van de beschikbare gegevens. De enorme taalmodellen die we hebben gebouwd zijn indrukwekkend geworden dankzij publieke en semi-publieke data. Veel van de nieuwere inhoud zit nu echter vast in “ommuurde tuinen” zoals WeChat, Telegram of Discord, waar deze niet toegankelijk is voor training – echt dark web! Dit betekent dat de modellen verouderd kunnen raken en niet meer kunnen leren van nieuwe gegevens of nieuwe trends kunnen begrijpen.

Uiteindelijk lopen we het risico modellen te creëren die vastzitten in het verleden, zonder de mogelijkheid om nieuwe informatie te absorberen of zich aan te passen aan nieuwe gespreksstijlen. Ze zullen nog steeds oudere gegevens bevatten en het gedrag en de cultuur van de nieuwere generatie zullen niet worden weergegeven. Het zal zijn alsof je met een grootouder praat: interessant, maar zeker uit een ander tijdperk.”

Maar wie zijn de interne gebruikers van de gegevens in een onderneming? Roman herinnert zich de drie tijdperken van het datagebruiksconcept binnen de ondernemingen: “Het is duidelijk dat het voor veel beslissingen wordt gebruikt, en daarom bestaat het hele business intelligence-gedeelte. Het begon eigenlijk allemaal met business intelligence. Bedrijven moesten voorspellingen doen en aan de aandelenmarkten doorgeven wat zij verwachten dat er in het volgende kwartaal of een paar kwartalen vooruit zal gebeuren. Veel van deze beslissingen zijn lange tijd datagedreven geweest. Dat is het eerste niveau van datagebruik: heel eenvoudig en bedrijfsgericht.

Het tweede niveau begon met het idee van digitaal gedefinieerde ondernemingen of digitale transformatie. Bedrijven realiseerden zich dat de manier waarop ze met hun klanten omgaan waardevol is, en niet noodzakelijkerwijs het daadwerkelijke product dat ze op dit moment verkopen. De relatie met de klant is de waarde op zichzelf. Ze wilden dat die relatie zo lang mogelijk zou duren, soms tot het uiterste dat je zo lang mogelijk aan het scherm gekluisterd bleef. Het gaat erom het gedrag van de consument vorm te geven en hem bepaalde dingen te laten doen. Dat kan alleen worden gedaan door veel verschillende dingen over u te analyseren: uw sociale en economische status, uw genderidentiteit en andere gegevenspunten waarmee ze die relatie zo lang mogelijk in stand kunnen houden.

Nu komen we bij het derde niveau of de derde fase van hoe ondernemingen kunnen profiteren van dataproducten. Iedereen heeft het over deze agentische systemen omdat bedrijven nu niet alleen geholpen willen worden door de menselijke beroepsbevolking. Hoewel het futuristisch klinkt, is het vaak net zo eenvoudig als uitzoeken wanneer een vergadering zou moeten plaatsvinden. We zijn altijd in situaties geweest waarin er vijf verschillende e-mails en drie telefoontjes nodig waren om erachter te komen hoe twee mensen elkaar kunnen ontmoeten voor de lunch. Het zou veel gemakkelijker zijn als een elektronische agent dat allemaal voor ons zou kunnen onderhandelen en daarbij zou kunnen helpen. Dat is een eenvoudig voorbeeld, maar bedrijven hebben er nog allerlei andere. Nu gaat het erom bepaalde kanten van de onderneming te externaliseren in deze agenten. Dat kan alleen als je een AI-agent kunt trainen in de vele soorten patronen waarmee de onderneming in het verleden te maken heeft gehad.”

Terugkomend op wie data verzamelt en wie eigenaar is van en uiteindelijk profiteert van data: de eerste glimp die Roman kreeg toen hij weer bij Pivotal werkte aan een paar projecten waarbij luchtvaartmaatschappijen en bedrijven betrokken waren die motoren produceren:

“Wat ik toen nog niet wist, is dat je de motor blijkbaar niet daadwerkelijk koopt; Je leaset de motor. Dat is het bedrijfsmodel. En de bedrijven die de motoren produceerden, beschikten over al deze gegevens: alle telemetrie die ze nodig hadden om de motor te optimaliseren. Maar toen zei de luchtvaartmaatschappij: ‘Wacht even. Dat zijn precies dezelfde gegevens die we nodig hebben om de vliegroutes te optimaliseren. En wij zijn degenen die die gegevens voor u verzamelen, omdat wij daadwerkelijk het vliegtuig besturen. Je motor blijft aan de grond totdat er een piloot in de cockpit zit die het vliegtuig daadwerkelijk bestuurt. Dus wie profiteert van de gegevens? We betalen al veel te veel aan motormensen om die motoren te onderhouden. Dus nu vertelt u ons dat wij u de gegevens gratis zullen geven? Nee, nee, nee.”

Dit hele argument is echt overtuigend, want dat is precies wat zich nu herhaalt tussen OpenAI en alle grote ondernemingen. Grote ondernemingen vinden OpenAI geweldig; ze kunnen deze chatbot in enkele minuten bouwen – dit is geweldig. Maar kunnen ze die data daadwerkelijk naar OpenAI sturen die nodig is voor finetuning en al die andere zaken? En ten tweede: stel dat die bedrijven dat zelfs kunnen. Stel dat het om het soort gegevens gaat dat prima is, maar dat het hun gegevens zijn, verzameld door die bedrijven. Het is zeker iets waard voor OpenAI, dus waarom laten ze de rekening voor de gevolgtrekkingen voor bedrijven die het hebben geïnd niet vallen?

En hier rijst de belangrijkste vraag van de hedendaagse datawereld: geldt dit ook voor AI?

In zekere zin is dat ook zo, maar met belangrijke nuances. Als we een toekomst kunnen hebben waarin de kernmotor van een vliegtuig, het model, wordt geproduceerd door deze grotere bedrijven, en bedrijven vervolgens hun gegevens gebruiken om deze modellen te verfijnen of uit te breiden, dan zal er een zeer harmonieus naast elkaar bestaan van iets heel complex en daarbovenop nog een meer gespecialiseerd, misschien minder complex iets. Als dat gebeurt en technologisch succesvol wordt, zal het op economisch en beleidsniveau een veel gemakkelijker gesprek worden over wat van wie is en hoe we de datasets splitsen.

Als voorbeeld haalt Roman zijn gesprek aan met een expert die auto’s ontwerpt voor de kost: “Hij zei dat er feitelijk twee soorten auto-ontwerpers zijn: de een die een auto ontwerpt met een motor, en de ander die een auto ontwerpt en vervolgens een motor koopt. Als je tegenwoordig een auto produceert, is het veel gemakkelijker om de motor te krijgen, omdat de motor het meest complexe onderdeel van de auto is. Het definieert echter absoluut niet het product. Maar toch, de manier waarop de industrie werkt: het is veel gemakkelijker om te zeggen: gegeven enkele beperkingen kies ik een motor, en dan ontwerp ik een hele reeks auto’s rond die motor of op zijn minst dat motortype.”

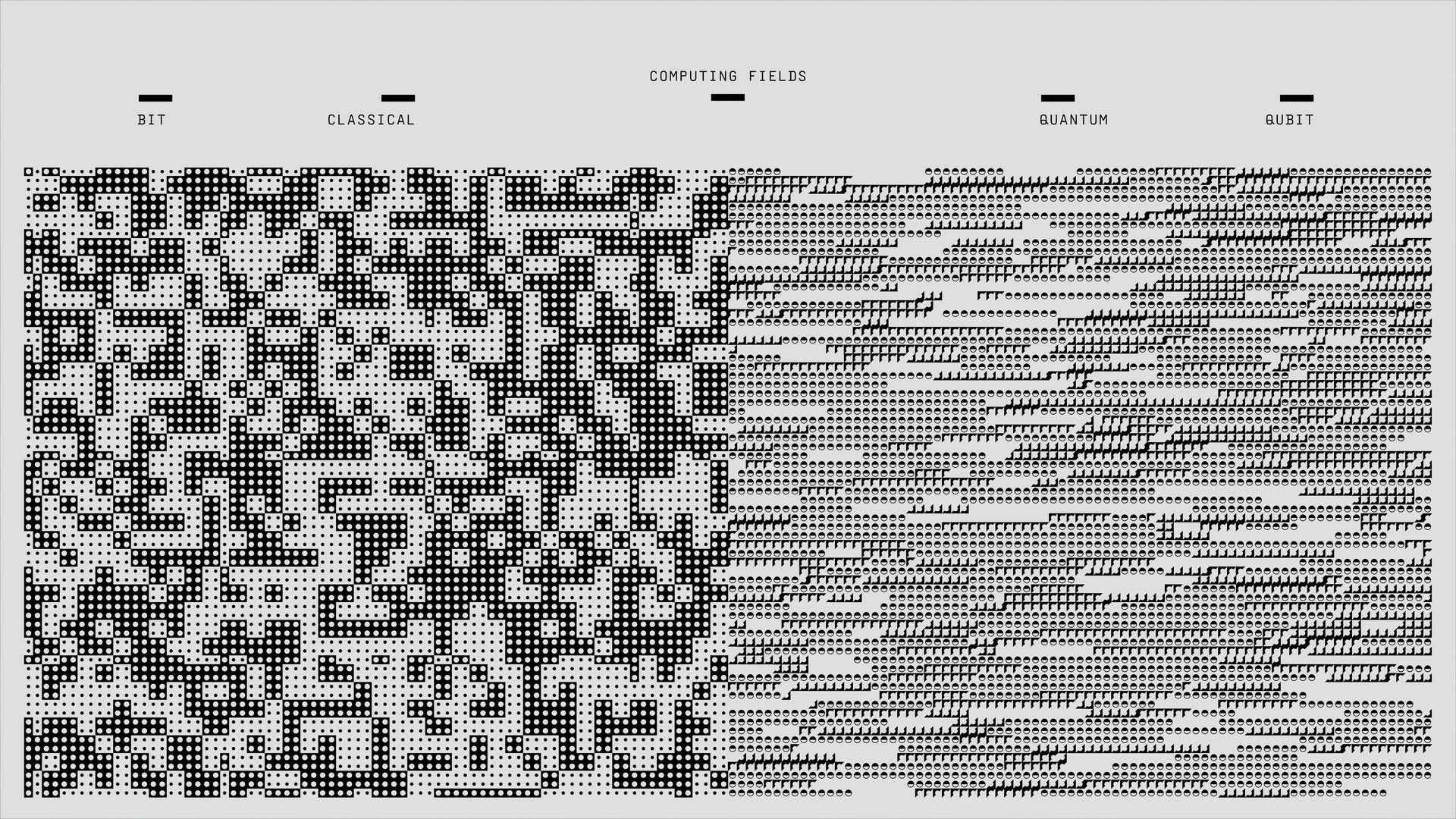

Dit brengt ons tot het volgende concept: wij geloven dat de AI-gedreven datawereld er zo uit zal zien. Er zal een ‘Google’-kamp en een ‘Meta-kamp’ zijn, en je kiest een van die open modellen – ze zullen allemaal goed genoeg zijn. En dan worden alle dingen waarin u als onderneming geïnteresseerd bent, daar bovenop gebouwd in termen van het toepassen van uw gegevens en uw kennis van hoe u ze kunt verfijnen en voortdurend die modellen uit verschillende ‘kampen’ kunt bijwerken. . Als dit technologisch en economisch lukt, zal er een dappere nieuwe wereld ontstaan.

Uitgelicht beeldtegoed: NASA/Ontsplashen