Microsoft heeft Phi-4 gelanceerd, een nieuw generatief AI-model met 14 miljard parameters, ontworpen om complexe wiskundige problemen efficiënt aan te pakken. Dit model, aangekondigd op 12 december 2024, markeert een aanzienlijke vooruitgang in de AI-technologie te midden van een groeiende vraag naar efficiënte computeroplossingen. Phi-4 is momenteel toegankelijk op Microsoft’s Azure AI Foundry voor onderzoeksdoeleinden onder een licentieovereenkomst.

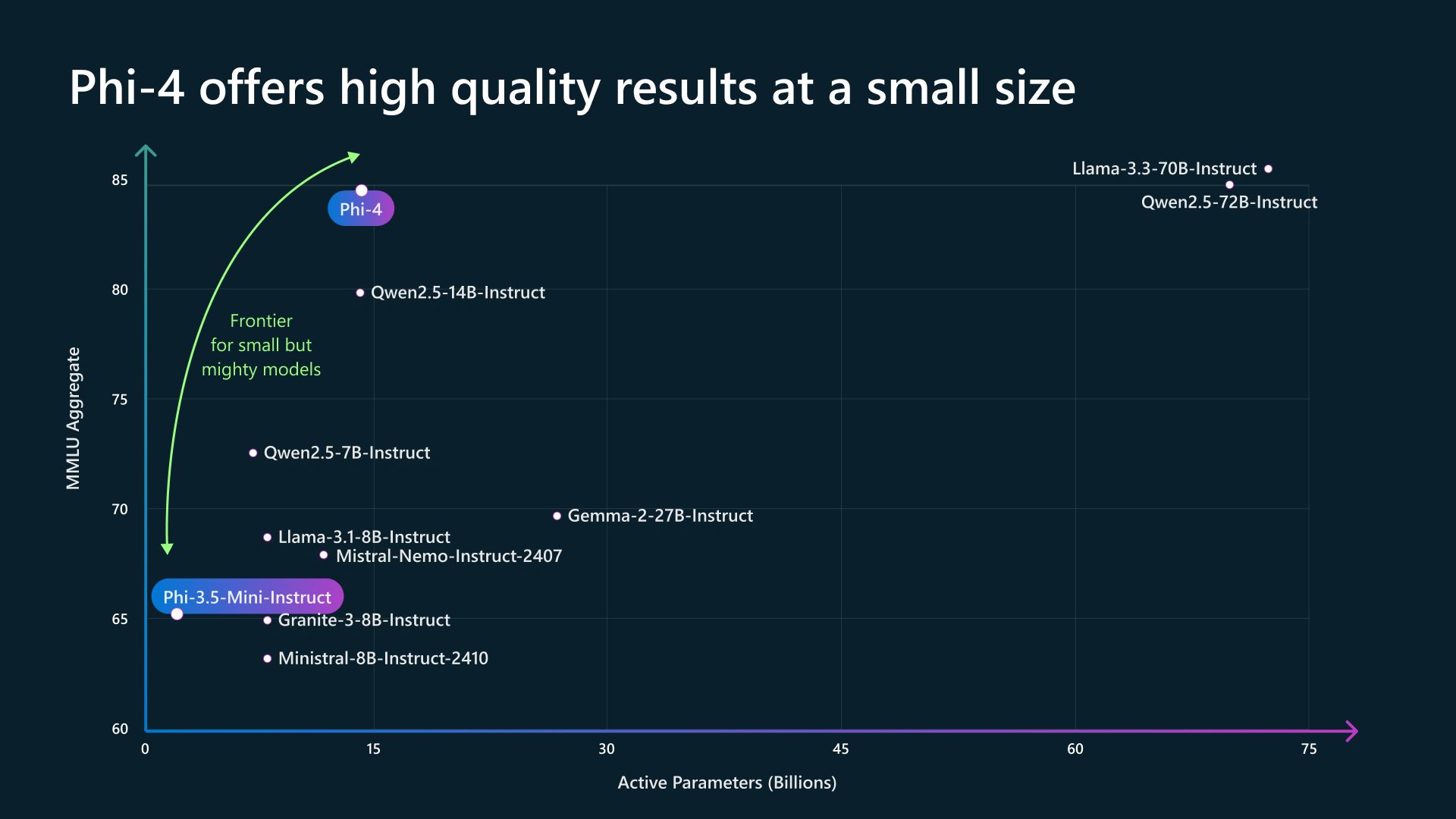

De Phi-familie van generatieve AI-modellen heeft tot doel de prestaties te optimaliseren en tegelijkertijd het verbruik van hulpbronnen te minimaliseren. Microsoft beweert dat Phi-4 verbeterde wiskundige redeneervaardigheden biedt in vergelijking met zijn voorgangers. De prestatieverbetering komt voort uit een combinatie van trainingsgegevens van hogere kwaliteit en niet-gespecificeerde verbeteringen na de training. Vergeleken met andere kleinere modellen zoals de GPT-4o mini en Google’s Gemini 2.0 Flash, concurreert Phi-4 agressief op het gebied van functionaliteit en snelheid, terwijl er minder computerbronnen nodig zijn.

De efficiëntie van Phi-4 daagt de industrienormen uit

De introductie van Phi-4 door Microsoft daagt het heersende idee van ‘groter is beter’ uit bij de ontwikkeling van AI-modellen. Terwijl andere modellen, zoals OpenAI’s GPT-4o en Google’s Gemini Ultra, met honderden miljarden parameters werken, combineert Phi-4 zijn gestroomlijnde architectuur met superieure prestaties op het gebied van wiskundig redeneren. Deze efficiëntie zou het landschap van AI-implementatie in ondernemingen kunnen veranderen, waardoor geavanceerde mogelijkheden toegankelijker zouden worden voor bedrijven met beperkte computerbudgetten.

Er is een groeiende belangstelling voor de ontwikkeling van kleinere, goed presterende modellen die concurrerende resultaten kunnen opleveren zonder dat hiervoor enorme rekenkracht nodig is. Deze aanpak zou ten goede kunnen komen aan middelgrote bedrijven die voorheen terugdeinsden voor de integratie van grote taalmodellen vanwege de kosten en complexiteit. De implicaties van de lancering van Phi-4 kunnen zich over verschillende sectoren heen uitstrekken, wat organisaties ertoe aanzet hun AI-strategieën te heroverwegen.

Microsoft rolt Copilot Vision uit, dat samen met u het internet leest

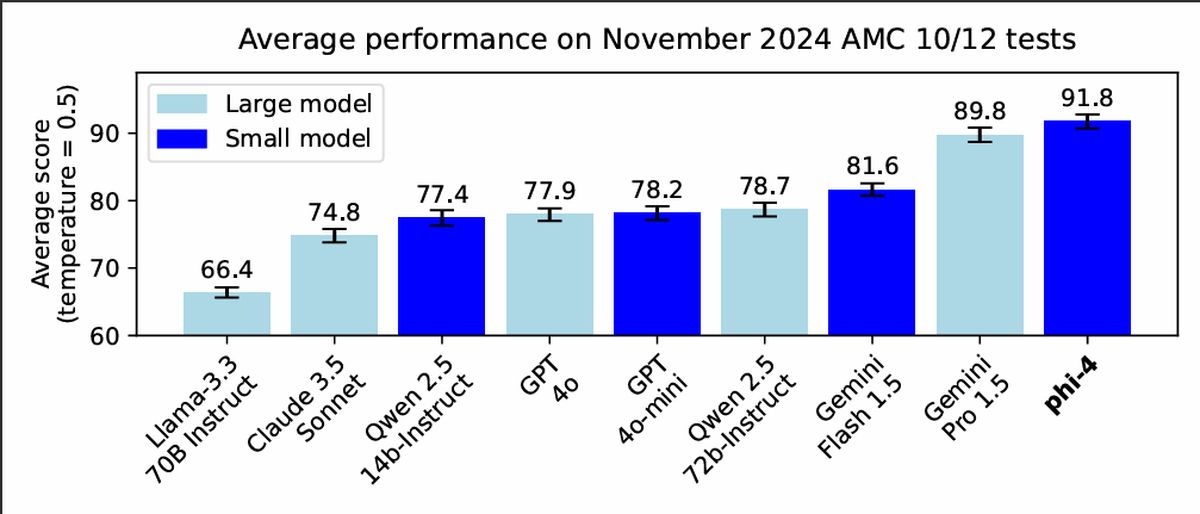

Phi-4 heeft uitzonderlijke bekwaamheid getoond in het oplossen van wiskundige problemen. Het model presteerde indrukwekkend op gestandaardiseerde tests zoals de Mathematical Association of America’s American Mathematics Competitions (AMC). De resultaten suggereren dat Phi-4 zowel grotere als kleinere concurrenten vaak kan overtreffen in gespecialiseerde taken, wat aangeeft dat gerichte ontwerpen aanzienlijke voordelen kunnen opleveren op specifieke gebieden, zoals wetenschappelijk onderzoek en engineering.

Deze gespecialiseerde prestaties kunnen bedrijven ertoe aanzetten de waarde van de bredere mogelijkheden van grotere modellen opnieuw te beoordelen, en in plaats daarvan de voorkeur te geven aan de precisie en efficiëntie van zoiets als Phi-4 in hun toepassingen. Het vermogen om rigoureuze wiskundige uitdagingen aan te gaan, benadrukt het potentieel ervan voor diverse implementaties in sectoren waar nauwkeurigheid van het grootste belang is.

Bij de uitrol legt Microsoft de nadruk op veiligheid en verantwoorde AI-ontwikkeling. Phi-4 is momenteel toegankelijk op het Azure AI Foundry-platform via een onderzoekslicentie, met plannen voor een bredere release in de toekomst. Deze afgemeten aanpak omvat veiligheidskenmerken en monitoringinstrumenten om de aanhoudende zorgen rond AI-risico’s aan te pakken.

Ontwikkelaars die de Azure AI Foundry gebruiken, hebben toegang tot evaluatietools voor het beoordelen van de kwaliteit en veiligheid van modellen, evenals mechanismen voor het filteren van inhoud om mogelijk misbruik te voorkomen. Dergelijke stappen duiden op een groeiende focus van de industrie op risicobeheer en ethische AI-inzet, omdat organisaties steeds meer geavanceerde technologieën in hun activiteiten willen integreren.

Uitgelichte afbeeldingscredits: Microsoft