Tekst-naar-video-generatie is niet meer wat het nog maar een paar jaar geleden was. We hebben het omgevormd tot een tool met werkelijk futuristische functionaliteit. Gebruikers creëren inhoud voor persoonlijke pagina’s, influencers gebruiken het voor zelfpromotie en bedrijven gebruiken het voor van alles, van reclame- en educatief materiaal tot virtuele training en filmproductie. De meeste tekst-naar-videosystemen zijn gebouwd op de architectuur van diffusietransformatoren, die toonaangevend zijn in de wereld van videogeneratie. Deze technologie dient als basis voor diensten als Luma en Kling. Deze status werd echter pas in 2024 versterkt, toen de eerste diffusietransformatoren voor video marktacceptatie kregen.

Het keerpunt kwam ermee OpenAI-release van SORAmet ongelooflijk realistische beelden die bijna niet van echt te onderscheiden waren. OpenAI liet zien dat hun diffusietransformator met succes video-inhoud kon genereren. Deze stap bevestigde het potentieel van de technologie en leidde tot een trend in de hele sector: nu is ongeveer 90% van de huidige modellen gebaseerd op diffusietransformatoren.

Verspreiding is een fascinerend proces dat een grondiger onderzoek verdient. Laten we begrijpen hoe diffusie werkt, welke uitdagingen de transformatortechnologie in dit proces aanpakt, en waarom deze zo’n belangrijke rol speelt bij het genereren van tekst naar video.

Waarin vindt het diffusieproces plaats? GenAI?

De kern van het genereren van tekst-naar-video en tekst-naar-afbeelding ligt in het verspreidingsproces. Geïnspireerd door het fysieke fenomeen waarbij stoffen zich geleidelijk vermengen – zoals inkt die in water diffundeert – omvatten diffusiemodellen in machinaal leren een proces in twee stappen: ruis toevoegen aan gegevens en vervolgens leren deze te verwijderen.

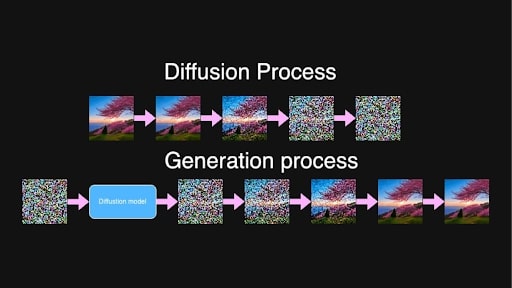

Tijdens de training maakt het model afbeeldingen of reeksen videoframes en voegt geleidelijk ruis toe over verschillende stappen totdat de originele inhoud niet meer te onderscheiden is. In wezen verandert het het in pure ruis.

Verspreidings- en generatieprocessen voor de prompt “Mooie blazende sakuraboom geplaatst op de heuvel tijdens zonsopgang”.

Verspreidings- en generatieprocessen voor de prompt “Mooie blazende sakuraboom geplaatst op de heuvel tijdens zonsopgang”.

Bij het genereren van nieuwe inhoud werkt het proces omgekeerd. Het model is getraind om ruis stapsgewijs te voorspellen en te verwijderen, waarbij de nadruk ligt op een willekeurige tussenliggende ruisstap tussen twee punten, t en t+1. Door het lange trainingsproces heeft het model alle stappen in de voortgang van pure ruis naar vrijwel zuivere beelden geobserveerd en beschikt het nu over het vermogen om ruis op vrijwel elk niveau te identificeren en te verminderen.

Uit willekeurige, pure ruis creëert het model, geleid door de invoertekst, iteratief videoframes die coherent zijn en overeenkomen met de tekstuele beschrijving. Hoogwaardige, gedetailleerde video-inhoud is het resultaat van dit zeer geleidelijke proces.

Latente diffusie maakt dit computationeel mogelijk. In plaats van rechtstreeks met afbeeldingen of video’s met hoge resolutie te werken, worden de gegevens door een encoder gecomprimeerd naar een latente ruimte.

Dit wordt gedaan om de hoeveelheid gegevens die het model moet verwerken (aanzienlijk) te verminderen, waardoor de generatie wordt versneld zonder dat dit ten koste gaat van de kwaliteit. Nadat het diffusieproces de latente representaties heeft verfijnd, zet een decoder ze weer om in afbeeldingen of video’s met volledige resolutie.

Het probleem met het genereren van video’s

In tegenstelling tot een enkel beeld vereist video dat objecten en karakters de hele tijd stabiel blijven, waardoor onverwachte verschuivingen of veranderingen in het uiterlijk worden voorkomen. We hebben allemaal gezien tot welke wonderen generatieve AI in staat is, maar af en toe een ontbrekende arm of een niet te onderscheiden gezichtsuitdrukking valt ruimschoots binnen de norm. In de video is de inzet echter hoger; consistentie is van cruciaal belang voor een vloeiend gevoel.

Dus als een personage in het eerste frame verschijnt met een specifieke outfit aan, moet die outfit er in elk volgend frame identiek uitzien. Elke verandering in het uiterlijk van het personage, of elke “vervorming” van objecten op de achtergrond, verbreekt de continuïteit en zorgt ervoor dat de video onnatuurlijk of zelfs griezelig aanvoelt.

Afbeelding verstrekt door de auteur

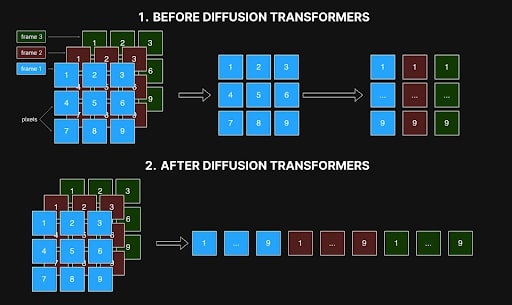

Vroege methoden benaderden videogeneratie door frames afzonderlijk te verwerken, waarbij elke pixel in één frame alleen verwijst naar de overeenkomstige pixel in andere. Deze frame-voor-frame benadering resulteerde echter vaak in inconsistenties, omdat de ruimtelijke en temporele relaties tussen frames, die essentieel zijn voor vloeiende overgangen en realistische bewegingen, niet konden worden vastgelegd. Artefacten zoals verschuivende kleuren, fluctuerende vormen of niet goed uitgelijnde kenmerken zijn het gevolg van dit gebrek aan samenhang en verminderen de algehele kwaliteit van de video.

Afbeelding verstrekt door de auteur

Afbeelding verstrekt door de auteur

De grootste belemmering bij het oplossen hiervan was de vraag naar computers – en de kosten. Voor een video van 10 seconden met 10 frames per seconde verhoogt het genereren van 100 frames de complexiteit exponentieel. Het creëren van deze 100 frames is ongeveer 10.000 keer complexer dan het genereren van één enkel frame vanwege de behoefte aan nauwkeurige coherentie van frame tot frame. Deze taak vereist 10.000 keer meer geheugen, verwerkingstijd en computerbronnen, en overschrijdt vaak de praktische limieten. Zoals u zich kunt voorstellen, was de luxe om met dit proces te experimenteren beschikbaar voor een select aantal mensen in de branche.

Dit is wat de release van SORA door OpenAI zo belangrijk maakte: ze toonden aan dat diffusietransformatoren inderdaad videogeneratie aankonden, ondanks de enorme complexiteit van de taak.

Hoe diffusietransformatoren het zelfconsistentieprobleem bij het genereren van video’s oplosten

De opkomst van diffusietransformatoren loste verschillende problemen op: ze maakten het mogelijk video’s van willekeurige resolutie en lengte te genereren en tegelijkertijd een hoge zelfconsistentie te bereiken. Dit komt grotendeels doordat ze met lange reeksen kunnen werken, zolang ze in het geheugen passen, en vanwege het zelfaandachtsmechanisme.

Bij kunstmatige intelligentie is zelfaandacht een mechanisme dat het aandachtsgewicht tussen elementen in een reeks berekent en bepaalt in hoeverre elk element door anderen moet worden beïnvloed. Het stelt elk element in een reeks in staat alle andere elementen tegelijkertijd in overweging te nemen en stelt modellen in staat zich te concentreren op relevante delen van de invoergegevens bij het genereren van uitvoer, waarbij afhankelijkheden in zowel ruimte als tijd worden vastgelegd.

Bij videogeneratie betekent dit dat elke pixel in elk frame betrekking kan hebben op elke andere pixel in alle frames. Deze onderlinge verbondenheid zorgt ervoor dat objecten en karakters consistent blijven gedurende de hele video, van begin tot eind. Als een personage in één frame verschijnt, helpt zelfaandacht veranderingen te voorkomen en de verschijning van dat personage in alle volgende frames te behouden.

Vroeger integreerden modellen een vorm van zelfaandacht binnen een convolutioneel netwerk, maar deze structuur beperkte hun vermogen om dezelfde consistentie en coherentie te bereiken die nu mogelijk is met diffusietransformatoren.

Met gelijktijdige ruimte-temporele aandacht in diffusietransformatoren kan de architectuur echter tegelijkertijd gegevens uit verschillende frames laden en deze als een uniforme reeks analyseren. Zoals te zien is in de onderstaande afbeelding, verwerkten eerdere methoden interacties binnen elk frame en koppelden ze alleen elke pixel aan de overeenkomstige positie in andere frames (zie figuur 1). Dit beperkte zicht belemmerde hun vermogen om de ruimtelijke en temporele relaties vast te leggen die essentieel zijn voor vloeiende en realistische bewegingen. Met diffusietransformatoren wordt nu alles gelijktijdig verwerkt (Figuur 2).

Spatio-temporele interactie in diffusienetwerken voor en na transformatoren. Afbeelding verstrekt door de auteur

Spatio-temporele interactie in diffusienetwerken voor en na transformatoren. Afbeelding verstrekt door de auteur

Deze holistische verwerking zorgt ervoor dat de details over de frames heen stabiel blijven, zodat scènes niet onverwacht veranderen en veranderen in een onsamenhangende puinhoop van een eindproduct. Diffusietransformatoren kunnen ook reeksen van willekeurige lengte en resolutie verwerken, op voorwaarde dat ze in het geheugen passen. Met deze vooruitgang is het genereren van langere video’s mogelijk zonder concessies te doen aan de consistentie of kwaliteit, waarbij uitdagingen worden aangepakt die eerdere op convolutie gebaseerde methoden niet konden overwinnen.

De komst van diffusietransformatoren heeft de generatie van tekst naar video opnieuw vorm gegeven. Het maakte de productie mogelijk van hoogwaardige, zelfconsistente video’s met willekeurige lengtes en resoluties. Zelfaandacht binnen transformatoren is een sleutelcomponent bij het aanpakken van uitdagingen zoals het handhaven van frameconsistentie en het omgaan met complexe ruimtelijke en temporele relaties. De release van SORA door OpenAI bewees deze mogelijkheid en zette een nieuwe standaard in de branche: nu is ongeveer 90% van de geavanceerde tekst-naar-videosystemen gebaseerd op diffusietransformatoren, waarbij grote spelers als Luma, Clink en Runway Gen-3 voorop lopen. markt.

Ondanks deze adembenemende vooruitgang zijn diffusietransformatoren nog steeds zeer arbeidsintensief en vereisen ze bijna 10.000 keer meer hulpbronnen dan het genereren van één enkel beeld, waardoor het trainen van modellen van hoge kwaliteit nog steeds een zeer kostbare onderneming is. Niettemin heeft de open-sourcegemeenschap belangrijke stappen gezet om deze technologie toegankelijker te maken. Projecten als Open-SORA en Open-SORA-Plan, evenals andere initiatieven zoals Mira Video Generation, Cog en Cog-2, hebben nieuwe mogelijkheden geopend voor ontwikkelaars en onderzoekers om te experimenteren en te innoveren. Gesteund door bedrijven en academische instellingen geven deze open-sourceprojecten hoop op voortdurende vooruitgang en een grotere toegankelijkheid bij het genereren van video’s, waar niet alleen grote bedrijven van profiteren, maar ook onafhankelijke makers en enthousiastelingen die graag willen experimenteren. Dit opent, net als bij elke andere door de gemeenschap aangestuurde inspanning, een toekomst waarin het genereren van video wordt gedemocratiseerd, waardoor deze krachtige technologie voor veel meer creatievelingen beschikbaar komt om te verkennen.