Knuffelende gezicht heeft uitgegeven Twee nieuwe AI-modellen, smolvlm-256m en smolvlm-500m, beweren dat ze de kleinste van hun soort zijn in staat om afbeeldingen, video’s en tekst op apparaten met beperkte RAM te analyseren, zoals laptops.

Knuffelen Face lanceert compacte AI -modellen voor beeld- en tekstanalyse

A Klein taalmodel (SLM) is een neuraal netwerk dat is ontworpen om tekst van natuurlijke taal te produceren. De descriptor “klein” is niet alleen van toepassing op de fysieke dimensies van het model, maar ook op het aantal parameters, neurale structuur en het gegevensvolume dat tijdens de training wordt gebruikt.

SMOLVLM-256M en SMOLVLM-500M bestaan uit respectievelijk 256 miljoen parameters en 500 miljoen parameters. Deze modellen kunnen verschillende taken uitvoeren, waaronder het beschrijven van afbeeldingen en videoclips, evenals het beantwoorden van vragen over PDF’s en hun inhoud, zoals gescande tekst en grafieken.

Sam Altman om ambtenaren op te vangen op ‘PhD-niveau’ Super AI

Om deze modellen te trainen, gebruikte Hugging Face de Cauldron, een samengestelde verzameling van 50 hoogwaardige beeld- en tekstgegevenssets, naast DocMatix, een dataset bestaande bestanden met gedetailleerde bijschriften. Beide datasets zijn gemaakt door het M4 -team van Face te knuffelen, gericht op multimodale AI -technologieën.

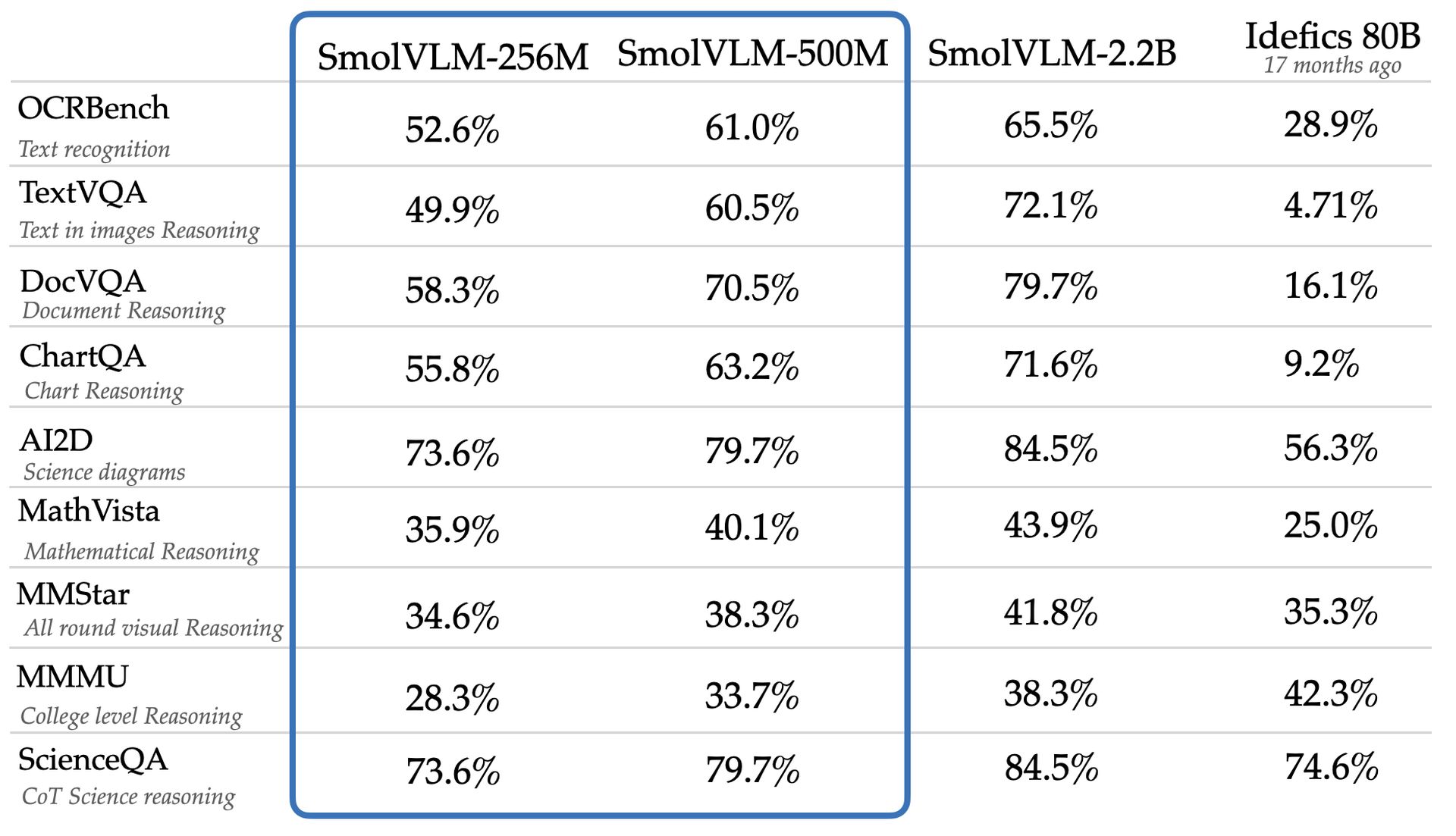

Het team beweert dat SMOLVLM-256M en SMOLVLM-500M beter presteren dan een aanzienlijk groter model, IDefics 80B, in benchmarks zoals AI2D, die de mogelijkheden van modellen beoordeelt om wetenschapsdiagrammen op grad-schoolniveau te analyseren. De nieuwe modellen zijn beschikbaar voor webtoegang en download onder een Apache 2.0 -licentie, waarmee onbeperkt gebruik mogelijk is.

Ondanks hun veelzijdigheid en kosteneffectiviteit, kunnen kleinere modellen zoals SMOLVLM-256M en SMOLVLM-500M beperkingen vertonen die niet in grotere modellen worden waargenomen. Een studie van Google DeepMind, Microsoft Research en het Mila Research Institute benadrukten dat kleinere modellen vaak suboptimaal uitvoeren bij complexe redeneringstaken, mogelijk vanwege hun neiging om patronen op oppervlakniveau te herkennen in plaats van kennis toe te passen in nieuwe contexten.

Het SMOLVLM-256M-model van Hugging Face werkt met minder dan één gigabyte GPU-geheugen en overtreft het IDEFICS 80B-model, een systeem 300 keer groter, het bereiken van deze reductie en verbetering binnen 17 maanden. Andrés Marafioti, een onderzoeksingenieur van machine learning bij Hugging Face, merkte op dat deze prestatie een aanzienlijke doorbraak weerspiegelt in modellen met visitietaal.

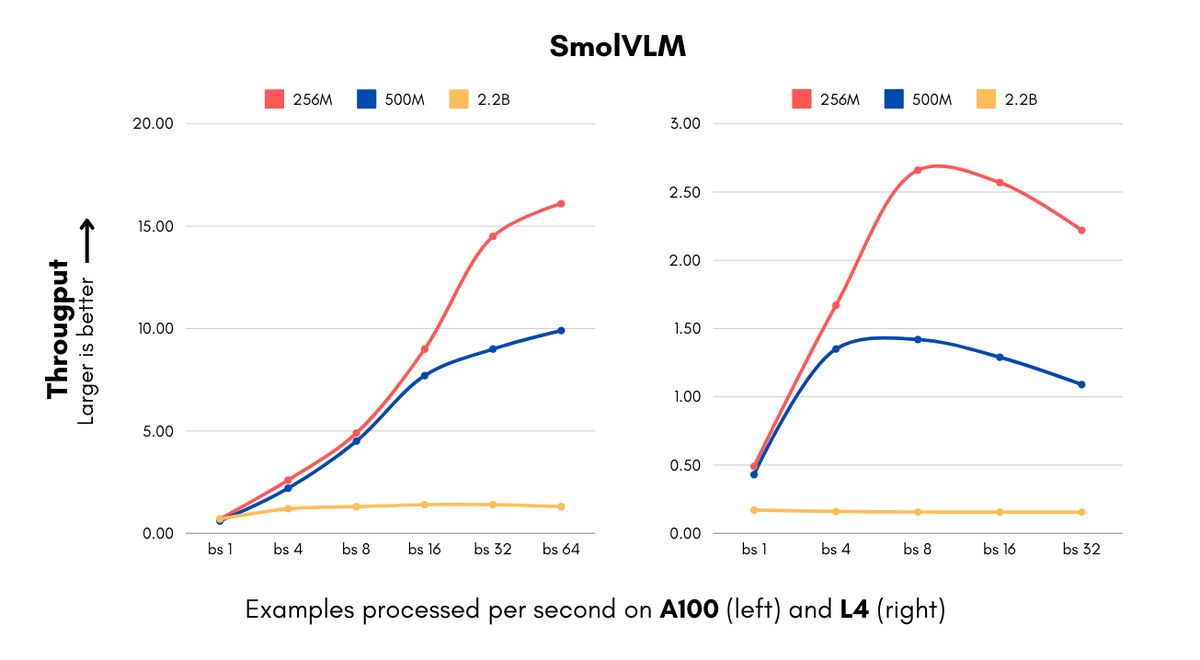

De introductie van deze modellen is tijdig voor ondernemingen die worden geconfronteerd met hoge rekenkosten in verband met AI -implementaties. De SMOLVLM -modellen zijn in staat om afbeeldingen te verwerken en visuele inhoud te begrijpen met ongekende snelheden voor modellen van hun grootte. De 256m -versie kan 16 voorbeelden per seconde verwerken, terwijl slechts 15 GB RAM wordt verbruikt met een batchgrootte van 64, wat leidt tot aanzienlijke kostenbesparingen voor bedrijven die grote hoeveelheden visuele gegevens behandelen.

IBM heeft een partnerschap gevormd met knuffelgezicht om het 256m -model op te nemen in zijn documentverwerkingssoftware, Docling. Zoals Marafioti uitlegde, kunnen zelfs organisaties met substantiële computerbronnen profiteren van het gebruik van kleinere modellen om miljoenen documenten efficiënt te verwerken tegen lagere kosten.

Knuffelen gezicht bereikte grootteverminderingen met behoud van prestaties door vooruitgang door zowel visieverwerking als taalcomponenten, waaronder een overstap van een 400m parameter vision -encoder naar een 93m parameterversie en het gebruik van agressieve tokencompressietechnieken. Deze efficiëntie opent nieuwe mogelijkheden voor startups en kleinere ondernemingen, waardoor ze geavanceerde computer vision -producten sneller kunnen ontwikkelen en hun infrastructuurkosten verlagen.

De SMOLVLM -modellen verbeteren mogelijkheden die verder gaan dan kostenbesparingen, waardoor nieuwe applicaties zoals geavanceerde document zoeken via een algoritme genaamd Colipali faciliteren, dat doorzoekbare databases uit documentarchieven maakt. Volgens Marafioti komen deze modellen bijna overeen met de prestaties van modellen 10 keer hun grootte, terwijl de snelheid van databasecreatie en zoeken aanzienlijk wordt verhoogd, waardoor enterprise-brede visuele zoekopdrachten mogelijk zijn voor verschillende bedrijven.

De SMOLVLM-modellen dagen de conventionele overtuiging uit dat grotere modellen nodig zijn voor geavanceerde visietaken, waarbij de 500m parameterversie 90% van de prestaties van een 2,2B parameter-tegenhanger op belangrijke benchmarks behaalt. Marafioti benadrukte dat deze ontwikkeling het nut van kleinere modellen aantoont, wat suggereert dat ze een cruciale rol voor bedrijven kunnen spelen.

Uitgelichte afbeeldingskrediet: Knuffelen