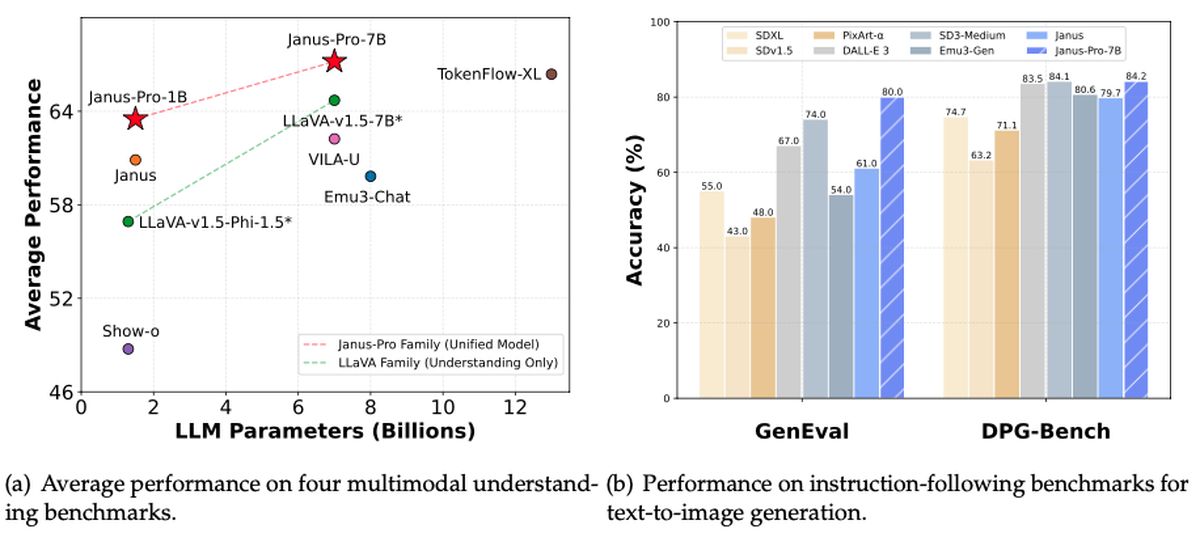

Deepseek heeft nog een andere belangrijke bijdrage aan het open-source AI-landschap onthuld. Deze keer is het Janus-Pro-7B: een multimodale krachtpatser die in staat is om zowel afbeeldingen te begrijpen als te genereren. Volgens Rowan Cheunghet nieuwe model overschaduwt niet alleen de Dall-E 3 van Openai en stabiele diffusie in benchmarks zoals Geneval en DPG-Bench, maar toont ook dezelfde “vrij beschikbare” geest die Deepseek’s eerdere R1-model een virale sensatie maakte. Beleggers ondertussen klauteren om de toename van de overspanning in AI -doorbraken te begrijpen, met NVIDIA’s aandelen dalen om 12.00 uur meer dan 17%.

Zou Janus-Pro-7B de volgende grote disruptor kunnen zijn in een al turbulente technische markt?

Wat is Deepseek Janus-Pro-7b?

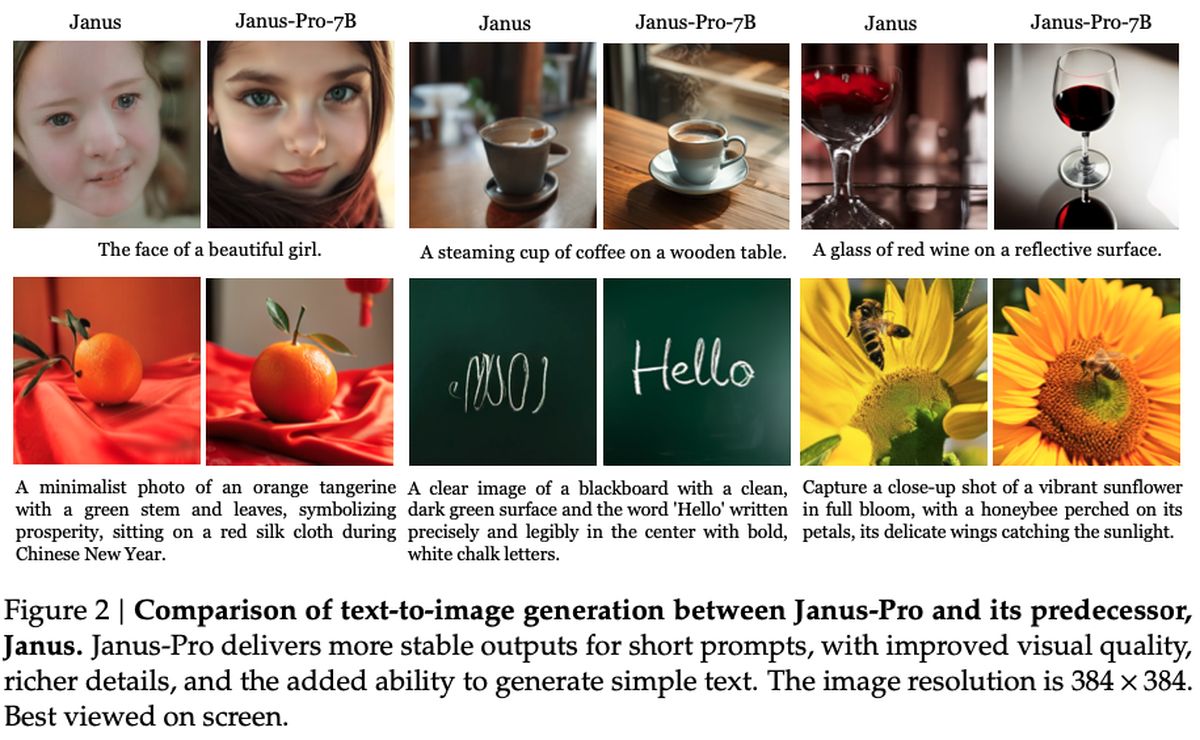

Onder de motorkap lijkt Janus-Pro-7B de kloof te overbruggen tussen krachtige gezichtsverwerking en snelle tekstgeneratie. Het systeem leent een nieuwe ontkoppelingsbenadering van zijn Siglip-L-encoder, het systeem kan snel een 384 x 384-afbeelding ontleden voordat het in de creatieve uitvoermodus springt. Het komt overeen met, of zelfs overtroffen, veel gespecialiseerde modellen in de ruimte – een prestatie vooral opvallend gezien het feit dat het ook opmerkelijk gemakkelijk aan te passen en uit te breiden.

Analisten wijzen op de consistente filosofie van Deepseek: houd het open-source, blijf privacy-eerste en ondersneden op abonnement gebaseerde rivalen. Janus-Pro-7B lijkt alle drie de fronten te leveren, en heeft hoge prestaties vastgesteld, met behoud van de toegankelijkheid die fans naar de offline mogelijkheden van Deepseek-R1 trok.

In puur feitelijke voorwaarden heeft Janus-Pro-7b een vergunning onder een tolerant MIT -frameworkmet toegevoegde gebruiksrichtlijnen van Deepseek. Het model integreert met downstream -projecten via een GitHub -repository, en het gebruikt naar verluidt slechts 16x downsampling in zijn pijplijn voor het genereren van beeldgeneratie. Huidige indicatoren suggereren dat de komst van Janus-Pro-7B een nieuwe concurrentie kan veroorzaken bij AI-ontwikkelaars, hoewel alleen de tijd zal vertellen hoe dit laatste gratis aanbod de AI-zone zal beïnvloeden.

Hoe stel je Deepseek-R1 gemakkelijk gratis (online en lokaal) in te stellen?

Hoe werkt het?

Zoals gedetailleerd in de onderzoekspaper Gepubliceerd door Deepseek, maakt het model gebruik van een Siglip-Large-Patch16-384-encoder, die elk beeld breekt in 16 × 16 patches met een resolutie van 384 × 384. Deze aanpak behoudt fijnkorrelige details, waardoor het systeem afbeeldingen nauwkeuriger interpreteert. Aan de generatiezijde gebruikt Janus-Pro een codeboek van 16.384 tokens om afbeeldingen weer te geven op een 16 × downsampled schaal, waardoor efficiënte reconstructies mogelijk zijn die concurreren-zo niet overtroffen-traditionele diffusiemodellen in kwaliteit.

Twee belangrijke MLP (multi-layer perceptron) adapters verbinden deze begrip en generatiecomponenten, waardoor gegevens soepel tussen de twee taken stromen. Tijdens de training ziet het model een mix van beeld- en tekstgegevens, waardoor het zowel kunt leren hoe visuele scènes kunnen worden geïnterpreteerd als zijn eigen afbeeldingen kunnen produceren. Sessies duren meestal 7 tot 14 dagen op grootschalige GPU-clusters (voor zowel 1,5B- als 7b-parameterversies), met prestaties getest op benchmarks zoals GQA (voor visueel begrip) en VisualGen (voor het maken van afbeeldingen). Het resultaat is een veelzijdig raamwerk dat uitblinkt bij multimodale taken, dankzij de gespecialiseerde maar samenhangende architectuur.

Hoe gebruik ik deepseek Janus-Pro-7b?

Aan de slag met Janus-Pro-7B is net zo eenvoudig als op weg naar zijn officiële Github-repository, het klonen of downloaden van de code en het installeren van de benodigde afhankelijkheden. De repository bevat een uitgebreide leesmes die u doorloopt door een python -omgeving op te zetten, de modelgewichten te trekken en voorbeeldscripts te gebruiken. Afhankelijk van uw hardware kunt u kiezen tussen CPU-alleen-modus of Harness GPU-versnelling voor snellere prestaties. Hoe dan ook, het installatieproces blijft eenvoudig, dankzij goed gedocumenteerde vereisten en stapsgewijze instructies.

Zodra alles actief is, kunt u aanwijzingen voor het genereren van tekst geven of beeldinvoer bieden voor de unieke multimodale mogelijkheden van het model. Voorbeeldnotitieboekjes in de repo laten zien hoe ze creatieve uitgangen kunnen genereren, geavanceerde beeldtransformaties toepassen of “visuele Q & A” -scenario’s kunnen verkennen. Voor meer geavanceerde gebruikers betekent het modulaire ontwerp van de repository dat u de onderliggende lagen kunt aanpassen, uw eigen datasets kunt aansluiten of het model kunt stapelen naast andere Deepseek -releases zoals R1.