Kunstmatige intelligentie wordt beter in het begrijpen van de wereld in drie dimensies, maar een nieuwe studie suggereert dat velen 3D Large Language Model (LLM) benchmarks testen mogelijk helemaal geen 3D -mogelijkheden. In plaats daarvan kunnen deze evaluaties het slachtoffer worden van wat onderzoekers het probleem “2d-cheating” noemen-waar AI-modellen voornamelijk op 2D-afbeeldingen worden getraind, kunnen deze beter presteren dan toegewijde 3D-modellen door point-wolken in afbeeldingen weer te geven.

Een team van de Shanghai Jiao Tong University, waaronder Jiahe Jin, Yanheng He en Mingyan Yang, heeft in hun onderzoek gevonden: “Revisering van 3D LLM -benchmarks: testen we echt 3D -mogelijkheden? ”, Dat veel taken die worden gebruikt om 3D AI te evalueren, net zo gemakkelijk kunnen worden opgelost door visietaalmodellen (VLM’s)-AI-systemen die voornamelijk worden getraind op 2D-afbeeldingen en tekst. Dit roept een cruciale vraag op: meten de huidige benchmarks echt 3D -begrip, of testen ze gewoon hoe goed AI 2D -renderingen van 3D -gegevens kan verwerken?

2d-cheating: de snelkoppeling die zwakke benchmarks blootlegt

Het probleem komt voort uit hoe 3D LLMS wordt geëvalueerd. Veel bestaande benchmarks zijn afhankelijk van Q&A en bijschrifttakenwaar een AI wordt gevraagd om een 3D -object te beschrijven of er vragen over te beantwoorden. De veronderstelling is dat a 3D-getrainde AI Moet beter presteren dan een die alleen 2D -afbeeldingen begrijpt.

De onderzoekers ontdekten dat echter VLM’s zoals GPT-4O en QWEN2-VLdie niet specifiek zijn ontworpen voor 3D -taken, dat zou kunnen Vaak beter dan geavanceerde 3D-modellen– simpel door te kijken naar 2D -afbeeldingen van puntwolken. Dit suggereert dat deze benchmarks niet echt testen of AI 3D -structuren begrijpt, maar eerder Hoe goed het kan 3D -informatie afleiden uit platte afbeeldingen.

Om dit aan te tonen, ontwikkelde het team VLM3Deen methode die 3D -puntwolken omzet in weergave beelden voordat ze in een VLM worden gevoed. Wanneer getest op grote 3D AI -benchmarks – inclusief 3d MM-Vet, Objaversexl-Lvis, Scanqa en SQA3D—VLM3D overtrof consequent beter dan vooraanstaande 3D -modellen in veel taken.

Waarom sommige 3D -taken kwetsbaarder zijn dan andere

Terwijl VLMS uitblonk in taken zoals objectherkenning en basisscènebeschrijving, worstelden ze op taken die een dieper inzicht vereisten Ruimtelijke relaties, occlusies en consistentie met meerdere views.

- Eenvoudige 3D -objectbenchmarks: Veel objectherkenningstaken in 3D -benchmarks zouden kunnen zijn Gemakkelijk opgelost met 2D -afbeeldingen. Uit de studie bleek dat VLM’s in deze gevallen 3D -modellen konden matchen of overschrijden, waaruit blijkt dat de benchmarks geen 3D -inzicht testen.

- Complexe scène -benchmarks: Taken die AI vereisen om volledige 3D -omgevingen te begrijpen, zoals Q&A op scènesniveau,, navigatieEn situationele redeneringwaren veel moeilijker voor VLM’s om te bedriegen. Hier presteerden 3D LLMS consequent beter, waaruit blijkt dat deze taken vertrouwen op echte 3D -ruimtelijke redenering.

Dit betekent dat Niet alle 3D -benchmarks zijn gebrekkig– Maar velen van hen kunnen er geen onderscheid in maken Echte 3D -capaciteiten en 2D -inferentietrucs.

Wanneer 2D -modellen vast komen te zitten

Een van de grootste zwakke punten van VLM’s in 3D -taken komt uit Selectie van het gezichtspunt– Het feit dat een enkele 2D -afbeelding slechts een deel van een 3D -scène vastlegt.

De onderzoekers hebben getest Drie verschillende weergave -benaderingen Om te evalueren hoeveel dit de prestaties beïnvloedt:

- Enkele weergave: De eenvoudigste aanpak, waarbij een object of scène vanuit een vast perspectief wordt weergegeven. VLMS heeft hier het beste uitgevoerdomdat ze voldoende informatie uit slechts één afbeelding kunnen halen.

- Multi-view: Beelden werden vastgelegd van vier verschillende invalshoekengeven AI -modellen meer context. Verrassend genoeg, VLM’s verbeterde niet significant In vergelijking met modellen met één uitzicht, wat suggereert dat ze moeite hebben om meerdere perspectieven te combineren in een uniform 3D-begrip.

- Oracle View: De AI werd gegeven het best mogelijke gezichtspunt voor het beantwoorden van elke vraag. Hier presteerde VLMS veel betermaar bleef nog steeds tekort aan speciale 3D LLMS, waaruit blijkt dat zelfs wanneer ze perfecte beelden krijgen, ze echte 3D -redeneervaardigheden missen.

Dit versterkt het idee dat VLMS ‘begrijpt’ 3D niet– Ze doen het gewoon goed als ze de juiste 2D -weergaven krijgen.

Wat moet veranderen

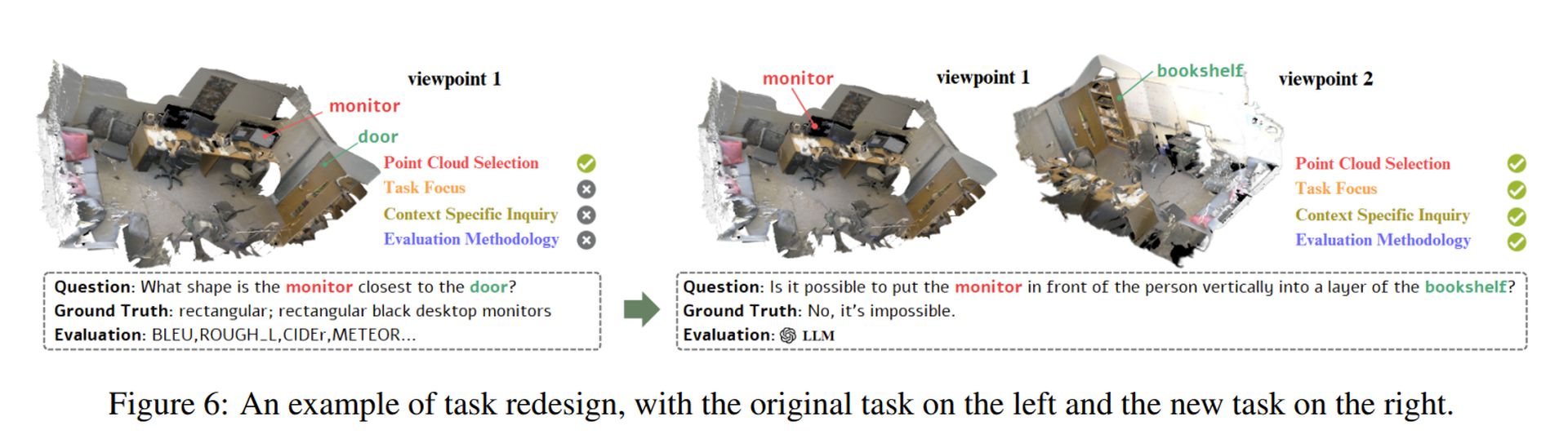

Om 3D AI -modellen echt te evalueren, stelt de studie voor Vier belangrijke principes Voor het ontwerpen van betere benchmarks:

- Meer complexe 3D -gegevens: In plaats van eenvoudige objectpuntwolken te gebruiken, moeten benchmarks bevatten Gedetailleerde en realistische 3D -scènes met structurele complexiteit.

- Taken die echte 3D -redenering vereisen: In plaats van alleen objecten te herkennen, moet AI worden getest op taken die vereist zijn ruimtelijk begripzoals het voorspellen van verborgen oppervlakken of redeneren over objectinteracties.

- Context-bewuste uitdagingen: Vragen moeten worden ontworpen om zich op te concentreren Unieke 3D -eigenschappenervoor zorgen dat ze niet kunnen worden beantwoord met slechts een enkele 2D -afbeelding.

- Betere evaluatiemetrieken: Huidige benchmarks zijn vaak afhankelijk van Tekstovereenkomstscoresdie niet vangen WAAR 3D -begrip. In plaats daarvan moeten AI -modellen worden beoordeeld op basis van hun vermogen om Infereer diepte, structuur en objectrelaties in driedimensionale ruimte.

De onderzoekers demonstreerden hoe deze principes konden worden toegepast door Een gebrekkige taak opnieuw ontwerpen (Zie hierboven afbeelding). Hun aanpak zorgt ervoor dat AI -modellen eigenlijk moeten Proces 3D -structuren in plaats van te vertrouwen op 2D -snelkoppelingen.

Uitgelichte afbeeldingskrediet: Sebastian Svenson/Unsplash