Grote taalmodellen (LLM’s) worden slimmer, maar ze raken ook een muur: het hanteren van lange stukken tekst is traag en computationeel duur. Traditionele aandachtsmechanismen – de kern van hoe AI informatie verwerkt en zich herinnert – rukt zich efficiënt uit, waardoor modellen duur zijn om te trainen en te rennen.

Nu, onderzoekers van Deepseek-Ai en Peking University hebben ingevoerd Een spelveranderende aanpak genaamd Native schaarse aandacht (NSA). Deze nieuwe methode belooft AI -modellen aanzienlijk te maken sneller, goedkoper en efficiënterallemaal met behoud van hetzelfde redeneerniveau als traditionele benaderingen.

Waarom het aandachtsprobleem van AI een oplossing nodig heeft

Stel je voor dat je een boek leest waar je elke zin te allen tijde in gedachten moet houden – zo is Volledige aandacht Mechanismen werken in AI. Ze scannen en slaan informatie op in lange sequenties, maar naarmate de contextlengte groeit (denk aan duizenden woorden), wordt deze aanpak ongelooflijk traag en computationeel zwaar.

Om dit aan te pakken, hebben onderzoekers onderzocht Schaarse aandacht– die selectief alleen de belangrijkste informatie verwerkt in plaats van alles. Bestaande schaarse methoden hebben echter Grote zwakke punten:

- Ze zijn moeilijk om helemaal opnieuw te trainenvaak vereisen dat modellen eerst met volledige aandacht moeten leren voordat ze overstappen op een schaarse aanpak.

- Ze optimaliseren niet volledig voor moderne hardwarewat betekent dat theoretische snelheidsverbeteringen zich niet altijd vertalen in de efficiëntie van de echte wereld.

Hoe NSA het spel verandert

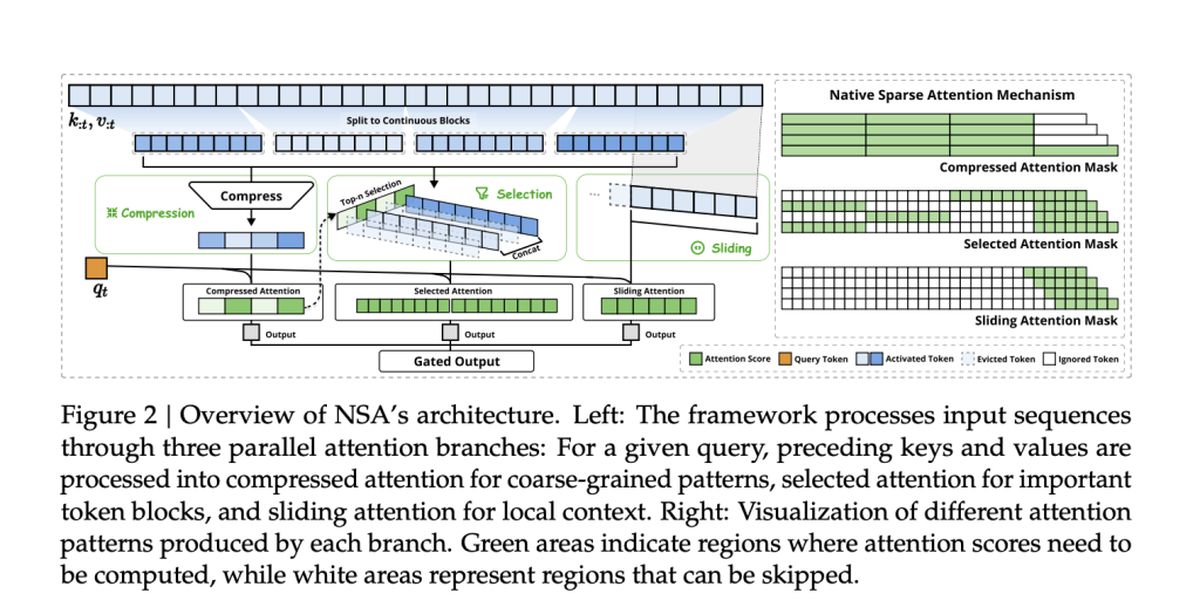

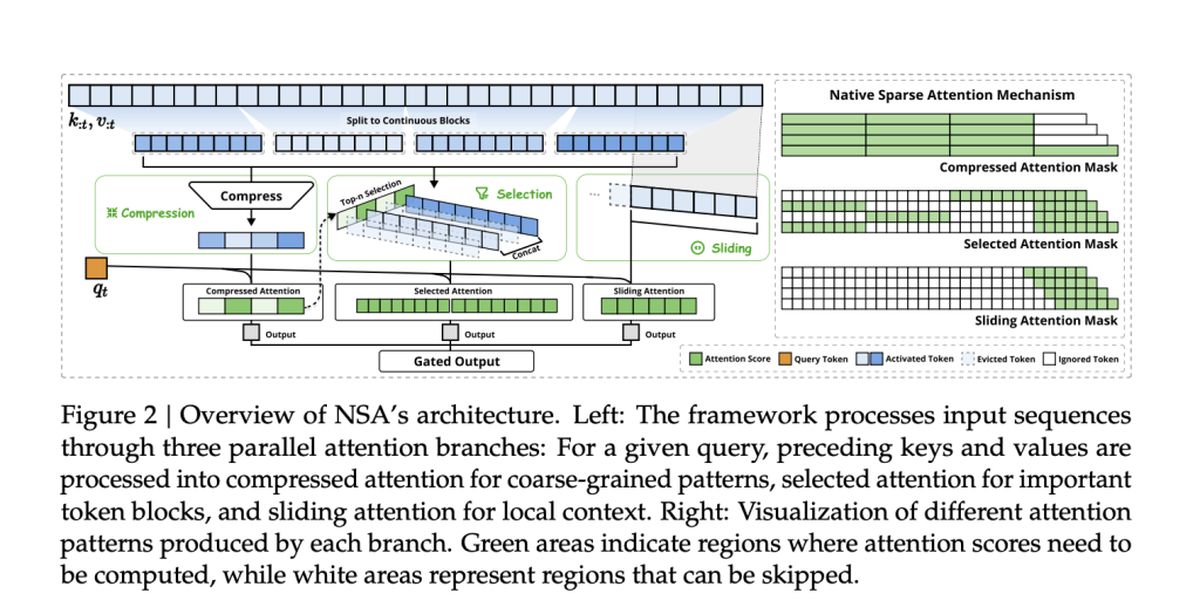

Het team achter NSA, waaronder Jingyang Yuan, Huazuo Gao, Damai Dai en hun collega’s, heeft een nieuwe aanpak gekregen. Hun methode Natuurlijk integreert de sparsity vanaf het beginin plaats van het toe te passen als een bijzaak.

NSA bereikt dit met Twee belangrijke innovaties:

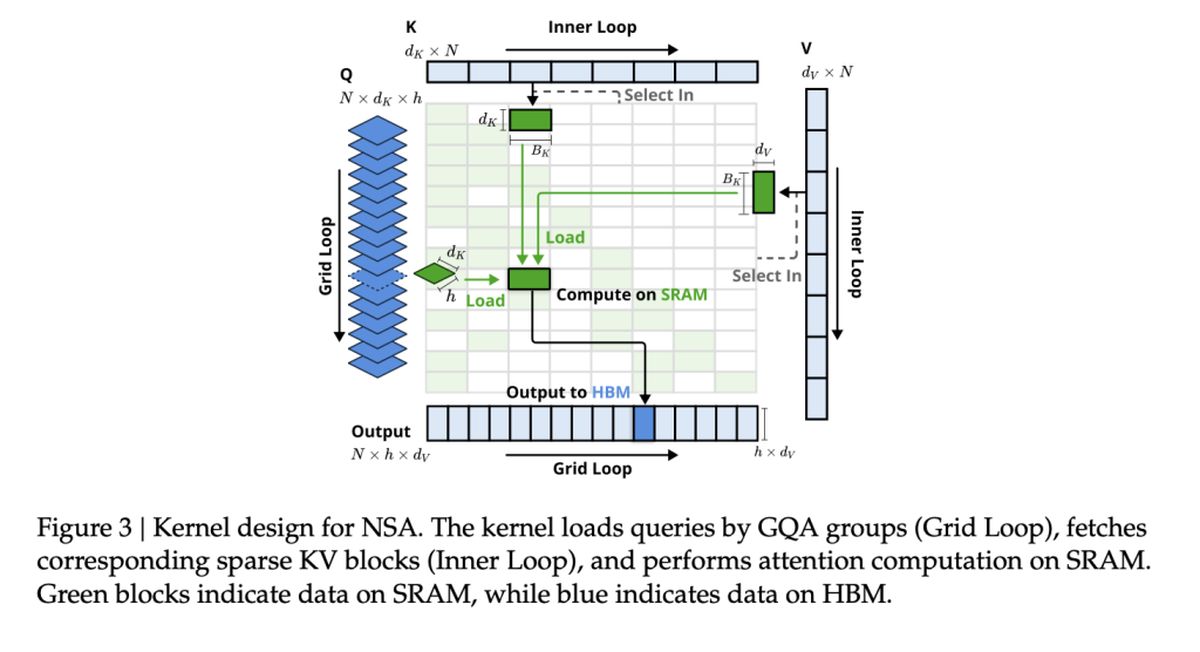

- Hardware-uitgelijnde efficiëntie: NSA is gebouwd om de GPU-prestaties te maximaliseren, knelpunten te vermijden en zorgt voor real-world versnellings.

- End-to-end trainabiliteit: In tegenstelling tot eerdere schaarse methoden, is NSA helemaal opnieuw te trainen, waardoor de trainingskosten worden verlaagd zonder de nauwkeurigheid te verliezen.

Snelheid en nauwkeurigheid: het NSA -voordeel

Dus, hoe stapt NSA op tegen traditionele volledige aandachtsmodellen? Volgens de studie, NSA bereikt tot 11 × snelheidsverbeteringen terwijl het nog steeds overeenkomt met – of zelfs beter dan het presteren – volle aandacht op belangrijke benchmarks.

Enkele van de grootste overwinningen zijn:

- Snellere verwerking: NSA versnelt het vermogen van AI om lange documenten, codebases en multi-turn gesprekken af te handelen.

- Beter redeneren: Ondanks dat hij ‘schaars’ is, modellen NSA matchen of overtreffen Volledige aandachtsmodellen in redeneringstaken in de kettingstoffen.

- Lagere kosten: Door de berekening te verminderen zonder prestaties op te offeren, zou NSA geavanceerde AI betaalbaarder kunnen maken om te trainen en te implementeren.

Bestaande schaarse aandachtsmethoden

Veel bestaande schaarse aandachtsmechanismen proberen de rekenover zich te verminderen door Selectief snoeien tokens of Geheugentoegang optimaliseren. Ze schieten echter vaak tekort in de praktische implementatie, hetzij omdat ze niet-verhaalbare componenten introduceren of niet in overeenstemming zijn met moderne GPU-architecturen.

Bijvoorbeeld:

- ClusterKV en Magicpig Vertrouw op discrete clustering of hashingtechnieken, die de gradiëntstroom verstoren en modeltraining belemmeren.

- H2O en minferentie Breng alleen spaarzaamheid toe tijdens specifieke fasen van gevolgtrekkingen, waardoor snelheidsverbeteringen in de volledige pijplijn worden beperkt.

- Quest en Infllm Gebruik BlockWise-selectiemethoden, maar hun op heuristische gebaseerde scoren resulteert vaak in lagere terugroepsnelheden.

NSA pakt deze beperkingen aan door native sparsity te integreren– Efficiëntie van zowel training als gevolgtrekkingen met behoud van de nauwkeurigheid van het model. Dit betekent Geen post-hoc benaderingen of afwegingen tussen snelheid en redeneermogelijkheden.

NSA’s prestaties bij taken uit de echte wereld

Om de effectiviteit van NSA te valideren, testten onderzoekers deze op een reeks AI-taken, waarbij de prestaties werden vergeleken met traditionele volledige aandachtsmodellen en ultramoderne schaarse aandachtsmethoden. De resultaten benadrukken het vermogen van NSA om Match of overtreffen volledige aandachtsmodellen, terwijl de rekenkosten aanzienlijk worden verlaagd.

Algemene benchmarkprestaties

NSA demonstreerde Sterke nauwkeurigheid over kennis, redeneren en coderende benchmarksinbegrepen:

- MMLU & CMMLU: Volledige aandacht matchen in op kennis gebaseerde taken

- GSM8K & Math: Outprestatie van volledige aandacht in complexe redenering

- Humaneval & MBPP: Leveren van solide coderingsprestaties

Lange-context begrip

NSA blinkt uit in het omgaan met lange-contextreeksen in benchmarks zoals Lange bank. In taken die een diep contextueel geheugen vereisen, handhaafde NSA:

- Hoge terugroepactie bij het ophalen van taken (Naald-in-a-haystack, document QA)

- Stabiele nauwkeurigheid bij multi-hop redenering (HPQ, 2Wiki, Govrpt)

Real-world snelheidswinst

De hardware-uitgelijnde optimalisaties in NSA leiden naar:

- 9 × snellere rendementsnelheden voor sequenties van 64k lengte

- 6 × snellere trainingsefficiëntie Vergeleken met modellen met volledige aandacht

- Verminderde verbruik van geheugenbandbreedtehet maken van grootschalige AI-toepassingen haalbaarder maken