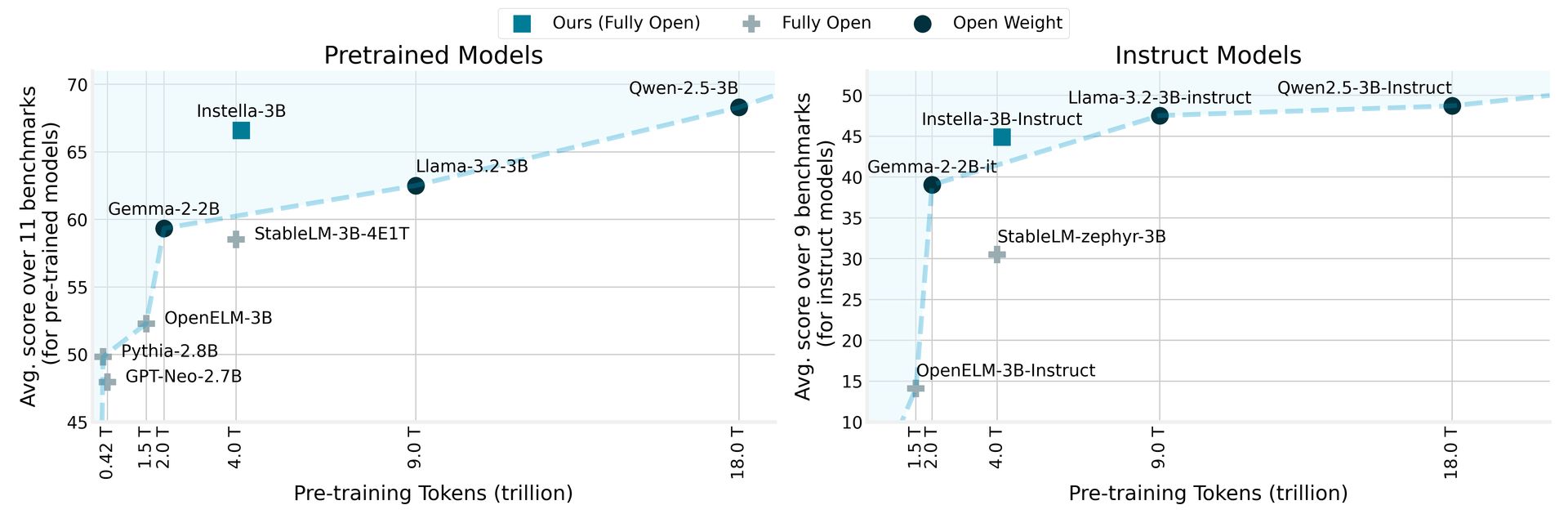

AMD heeft onthuld Instella, een familie van volledig open-source taalmodellen met 3 miljard parameters, vanaf nul getraind op AMD Instinct ™ MI300X GPU’s. Instella-modellen presteren beter dan bestaande open modellen van vergelijkbare maten en concurreren effectief met toonaangevende open-gewicht modellen, waaronder LLAMA-3.2-3B, Gemma-2-2B en Qwen-2.5-3B, inclusief hun instructie-afgestemde versies.

AMD onthult Instella: Open-source taalmodellen die beter presteren dan rivalen

Instella maakt gebruik van een autoregressieve transformatorarchitectuur bestaande uit 36 decoderlagen en 32 aandachtshoofden, waardoor het langdurige reeksen tot 4.096 tokens kan verwerken. Het model maakt gebruik van een vocabulaire van ongeveer 50.000 tokens, beheerd door de OLMO -tokenizer, waardoor het bedreven is in het genereren en interpreteren van tekst in verschillende domeinen.

De trainingsprocedure voor Instella benadrukt samenwerking tussen AMD’s hardware en software -innovaties. Dit nieuwe model bouwt voort op de basis die is vastgesteld door AMD’s eerdere modellen met 1 miljard parameters, die overstapt van training op 64 AMD instinct MI250 GPU’s met 1,3 biljoen tokens naar het gebruik van 128 instinct Mi300X GPU’s met 4,15 biljoen tokens voor het huidige 3-miljard-parametermodel.

Door Instella te vergelijken met eerdere modellen, meldt AMD dat het niet alleen bestaande volledig open modellen overtreft, maar ook concurrerende prestaties behaalt tegen ultramoderne open-gewicht modellen, waardoor een belangrijke mijlpaal op het gebied van natuurlijke taalverwerking wordt gemarkeerd. Dit initiatief sluit aan bij de toewijding van AMD om geavanceerde technologie toegankelijker te maken en samenwerking en innovatie binnen de AI -gemeenschap te bevorderen.

AMD RX 9000 -prijzen kunnen ervoor zorgen dat u die RTX 5090 -aankoop heroverweegt

Instella -modelfasen en trainingsgegevens

Deze release bevat verschillende versies van de Instella -modellen, die elk verschillende trainingsfasen vertegenwoordigen:

| Model | Fase | Trainingsgegevens (tokens) | Beschrijving |

|---|---|---|---|

| Instella-3B-Stage1 | Pre-training (fase 1) | 4.065 biljoen | Eerste fase pre-training om vaardigheid in natuurlijke taal te ontwikkelen. |

| Instella-3B | Pre-training (fase 2) | 57.575 miljard | Tweede fase pre-training om probleemoplossende mogelijkheden te verbeteren. |

| Instella-3B-SFT | SFT | 8.902 miljard (x3 tijdvakken) | Supervised verfijning (SFT) om instructievolle mogelijkheden mogelijk te maken. |

| Instella-Ilstruct | DPO | 760 miljoen | Afstemming op menselijke voorkeuren en verbetering van chatmogelijkheden met directe voorkeuroptimalisatie (DPO). |

In de multi-fase trainingspijplijn gebruikte de eerste pre-trainingsfase 4.065 biljoen tokens uit verschillende datasets, waardoor het begrip van het fundamentele taal werd vastgesteld. De daaropvolgende training op nog eens 57,575 miljard tokens verbeterde de prestaties van het model verder tussen gevarieerde taken en domeinen.

Tijdens het beëindigen van de beëindiging werd Instella-3B-SFT getraind met 8,9 miljard tokens, waardoor interactieve responsmogelijkheden werden verbeterd. De laatste fase, Instella-3B-instructie, onderging een uitlijningstraining met directe voorkeuroptimalisatie met behulp van 0,76 miljard tokens, zodat de output van het model is afgestemd op menselijke waarden en voorkeuren.

AMD heeft alle artefacten gemaakt die zijn geassocieerd met Instella-modellen volledig open-source, inclusief modelgewichten, trainingsconfiguraties, datasets en code, het bevorderen van samenwerking en innovatie in de AI-gemeenschap. Deze bronnen zijn toegankelijk via Knuffelen modelkaarten en Gitub repositories.

Uitgelichte afbeeldingskrediet: AMD