Wanneer een hond blaft naar een piepend speelgoed of een monteur stopt plotseling met praten in de zin, heb je geen doctoraat in de cognitieve wetenschap nodig om erachter te komen wat er gebeurt-je kijkt gewoon, luister en begrijp je. Maar voor multimodale AI -modellen blijft deze eenvoudige menselijke reflex verrassend moeilijk te repliceren. Ondanks alle recente hype rond “Frontier” -modellen zoals GPT-4O en Gemini 1.5 Pro, rommelen de meeste van hen nog steeds wanneer ze worden gedwongen om echt te synthetiseren wat ze zien En horen. Dat is precies het probleem dat Maverix probeert op te lossen.

Waar benchmarks tekortschieten – en Maverix stapt in

De toonaangevende multimodale benchmarks van vandaag kunnen beweren dat ze de real-world redenering testen, maar velen van hen vals spelen. Ze belonen modellen die rond kunnen komen met alleen visie of alleen teksttranscripties, in plaats van ze te dwingen meerdere zintuigen te integreren zoals mensen doen. Maverix (Kort voor multimodale audiovisuele evaluatie-redeneringsindex) is een nieuwe benchmark die uiteindelijk de lat ophief door strak gekoppelde audiovisueel redeneren over 700 video’s en meer dan 2500 vragen te vereisen.

Zie het als een spoedcursus in gezond verstand voor AI: als je een zoemen hoort en een bij in de buurt van de camera ziet, moet je waarschijnlijk “mechanisch apparaat off-screen” uitsluiten. Maar Maverix modelleert niet alleen een paar eenvoudige puzzels. Het wordt geleverd met acht-opties meerkeuzevragen (om het giswerk te doden) en open-end prompts (om echt begrip te testen), waardoor modellen verder gaan dan patroonherkenning in volledige cognitieve coördinatie.

Echte vragen, echte menselijke complexiteit

De vragen van Maverix zijn ontworpen als psychologische Rorschach -tests voor machines – het bekleden van causaal redeneren, emotionele inferentie, ruimtelijk bewustzijn en dynamische context. Stel je een video voor van twee mensen die ruzie maken. Vechten ze echt, handelen in een film, of nabootsen van WWE worstelen om lachen? Dat antwoord zou kunnen afhangen van de klap En het lachtrack. Je moet het zien En hoor het begrijpen.

Om dit allemaal te laten werken, bouwde het Maverix -team een zorgvuldige pijplijn die menselijke expertise combineert met AI -validatie. Elke video wordt geleverd met ondertitels, gecategoriseerde geluiden (spraak, muziek, natuurlijke ruis) en geannoteerde keyframes. Elke vraag wordt doorgelicht om ervoor te zorgen dat unimodale snelkoppelingen – zoals alleen het lezen van de ondertitels – het niet snijden. Als een model zou kunnen antwoorden zonder beide modaliteiten te gebruiken, wordt de vraag herschreven of gegooid.

Dus, hoe goed presteert de AIS van vandaag daadwerkelijk?

Niet geweldig. Zelfs met directe toegang tot audio en video scoorde de toppresteerder – Gemini 1.5 Pro – ongeveer 71,9% nauwkeurigheid. Dat is dicht bij mensen, maar nog steeds achter. Mensen, met volledige audiovisuele input, klokken op meer dan 80%. Maar hier is de kicker: sommige open-source modellen kraken nauwelijks 30%. En wanneer u audio of video wegneemt, daalt de prestaties als een microfoon.

In open taken waar modellen hun eigen uitleg moeten genereren, worden de dingen rommeliger. Het gemiddelde model scoorde slechts 1,9 van de 5 in GPT-4O-beoordeelde samenhang en redenering. Mensen scoorden 2,79. Die kloof verbreedt nog meer wanneer taken complexe emotionele signalen of evenementen buiten het scherm omvatten-zoals raden waarom een menigte tafels verschuift bij een pokerspel of dat twee dansers vechten of gewoon repeteren.

Niet alle modellen worstelen op dezelfde manier

Een van de meest onthullende bijdragen van Maverix is hoe het onthult welke verschillende modellen eigenlijk vertrouwen op. Gemini presteert het beste wanneer ze RAW -audio krijgen, terwijl de meeste andere modellen het beter doen met ondertitels. Dat zegt veel over wat er onder de motorkap gebeurt – sommige modellen ‘luisteren’, anderen ‘lezen’. Maar geen van beide komt overeen met de perceptie op menselijke niveau over de hele linie.

Interessant is dat taken zoals winkelen – waar gestructureerde, feitelijke gegevens van belang zijn – zijn waar machines schijnen. Maar voor sportcommentaar, gamingstrategie of het interpreteren van menselijke emoties? Mensen verpletteren ze. Deze hiaten laten zien dat de huidige AI veel beter is in scancatalogi dan het parseren van sociale nuance of context die zich in de loop van de tijd ontwikkelt.

Moeilijkheidsniveaus zijn belangrijk, en modaliteit ook

Eenvoudige taken gaven de grootste boost van multimodale ingangen – wat mengponte dat sommige modellen audio en video gebruiken om voor de hand liggende antwoorden te verfijnen. Maar toen vragen moeilijker werden, leunden veel modellen zwaar op visie en negeerden audio. Claude 3.5 Sonnet verbeterde bijvoorbeeld 41,5% op eenvoudige video’s met multimodale invoer, maar slechts 17% op harde.

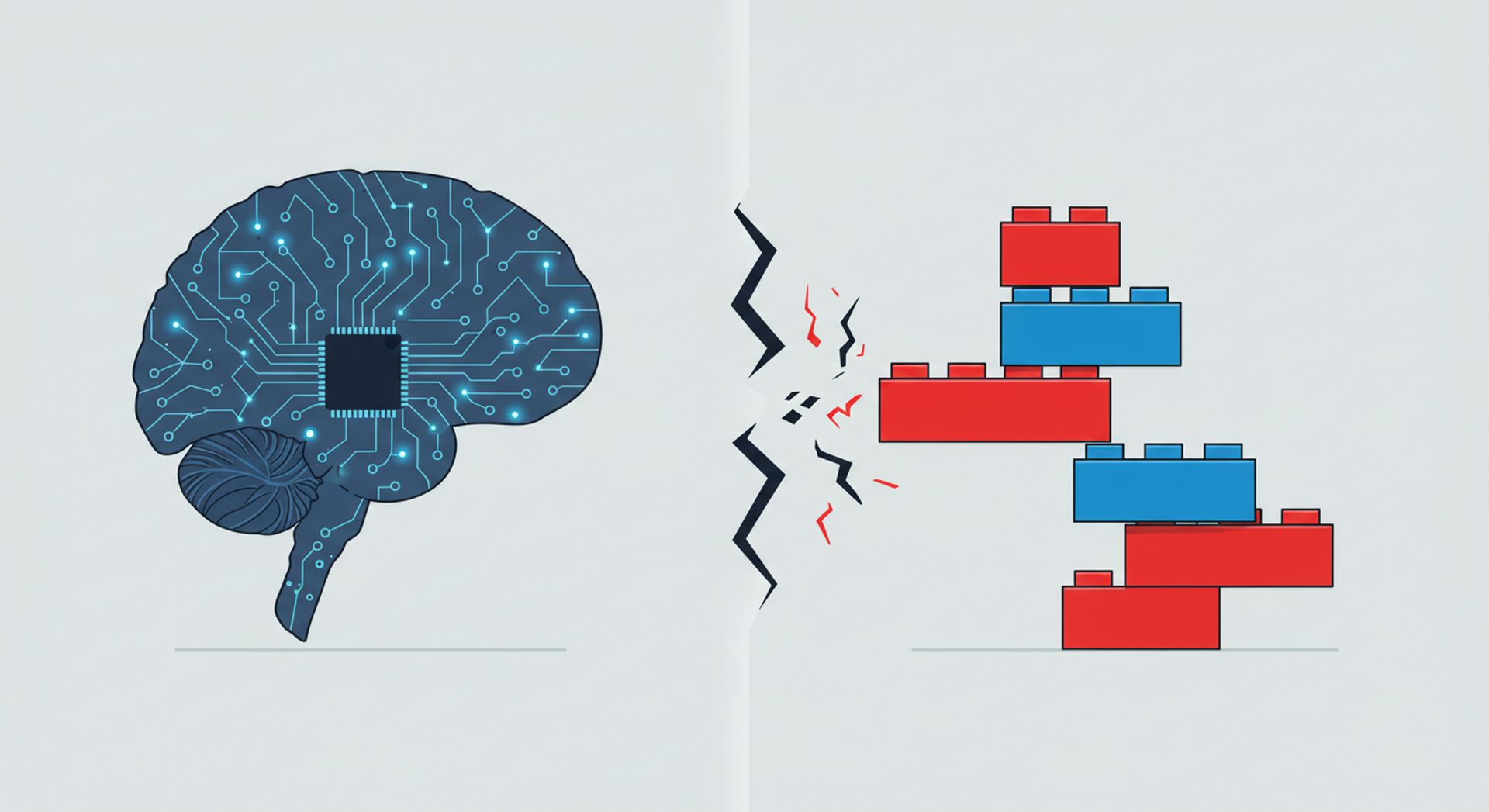

Dit benadrukt een dieper probleem: de meeste modellen combineren niet echt modaliteiten. Ze stapelen ze op. Je kunt ze zowel audio als video geven, maar tenzij het model behoeften Zowel om de taak op te lossen, zal het een favoriet kiezen. Maverix wil dat veranderen door vragen te ontwerpen die echte fusie vereisen – waar het antwoord afloopt over het samenspel tussen geluid en zicht.

Om de prestatiekloof te overbruggen, hebben we betere architecturen nodig die audio als meer dan een bijzaak behandelen. We hebben nieuwe trainingsstrategieën nodig die gesynchroniseerd begrip belonen in plaats van geïsoleerde voorspellingen. En bovenal hebben we benchmarks zoals Maverix nodig die niet genoegen nemen met wat gemakkelijk te meten is, maar stel de moeilijke vragen over hoe machines echt begrijpen.

Dus de volgende keer dat uw AI -assistent een eenvoudige opdracht verprutst of een toon verkeerd leest, onthoud dan: het is misschien niet doof – het heeft de Maverix -test nog niet geslaagd.