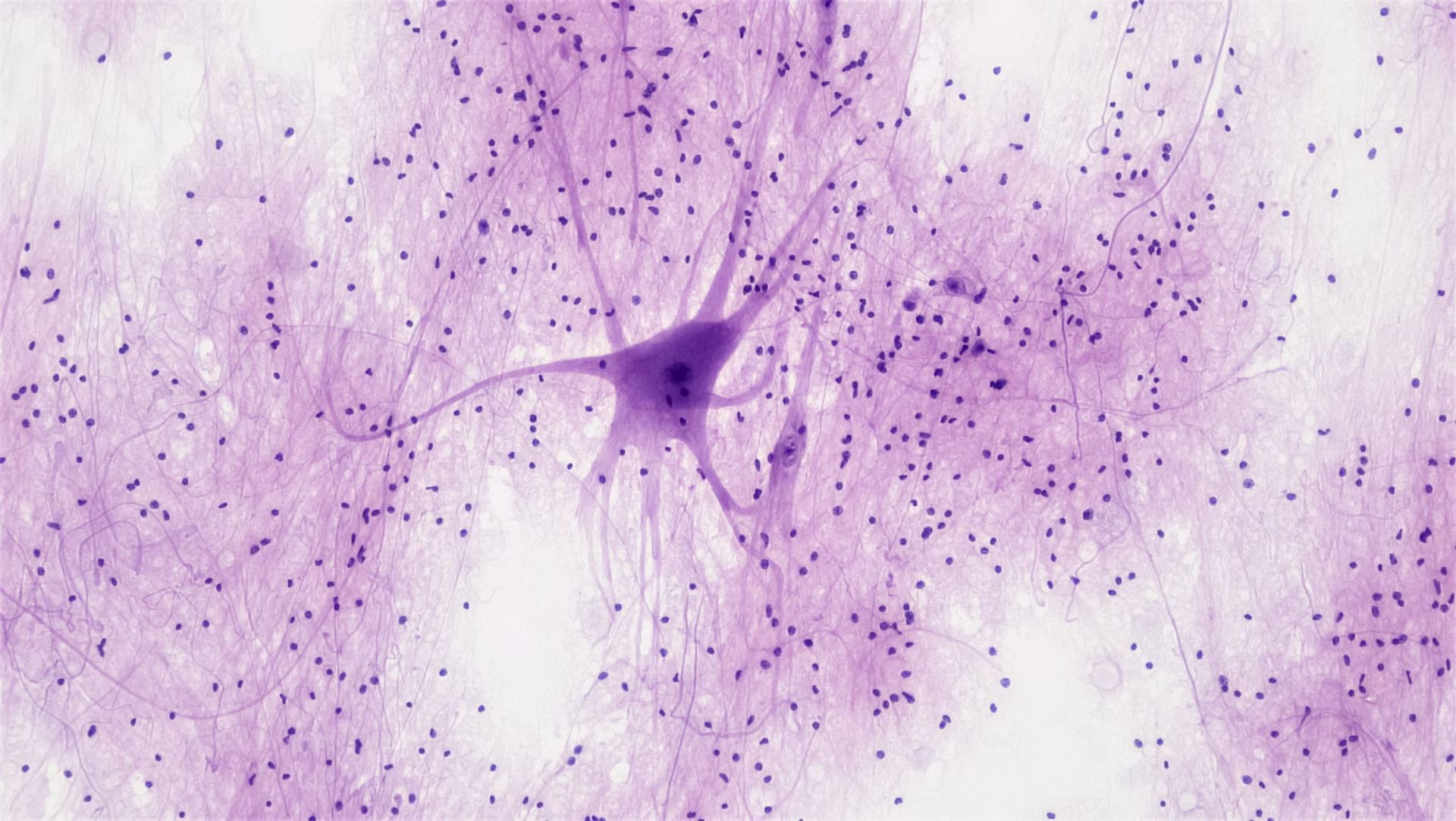

De non -profit sector omarmt kunstmatige intelligentie sneller dan hij klaar is. Meer dan de helft van de non -profitorganisaties gebruikt nu AI -tools in een of andere vorm – Chatgpt, automatiseringssystemen, voorspellende analyses – maar minder dan 10 procent heeft het beleid geschreven over hoe dat AI moet worden gebruikt. Dat is niet alleen een procedureel toezicht.

Het is een structurele kwetsbaarheid. Deze organisaties, waarvan vele historisch gemarginaliseerde gemeenschappen dienen, stappen in een technologisch landschap met hoge inzet met weinig ethische vangrails en nog minder interne kaders om hen te begeleiden. Deze kloof tussen adoptie en governance vormt reële risico’s-algoritmische vooringenomenheid, inbreuken op privacy en onbedoelde schade-met name wanneer kant-en-klare tools worden ingezet zonder diep begrip of toezicht. De haast tot efficiëntie kan onbedoeld vertrouwen uithollen, waarden in gevaar brengen en non -profitorganisaties blootstellen aan reputatie en juridische fall -out.

Efficiëntie nu, spijt later spijt

De cijfers vertellen een opvallend verhaal. Volgens BDO’s 2024 Non -profit benchmarking -enquête82 procent van de Amerikaanse non -profitorganisaties rapporteert nu met behulp van AI. Daarvan is de meerderheid het toepassen op interne activiteiten: 44 procent gebruikt AI voor financiële taken zoals budgettering en betalingsautomatisering, en 36 procent past het toe op programma -optimalisatie en impactbeoordeling. Met andere woorden, de focus is administratieve efficiëntie – geen missielevering.

Dat is consistent met het Centre for Effective Philanthropy’s 2024 Staat van non -profitorganisaties Onderzoek, waarvan ook bleek dat productiviteitswinst de meest voorkomende reden was voor het gebruik van AI. Maar datzelfde onderzoek onthult de ethische vertraging: minder dan een op de tien organisaties heeft een formeel beleid. En de organisaties die AI gebruiken, werken vaak met beperkte infrastructuur, weinig interne expertise en beperkte budgetten die voorkomen dat ze op maat gemaakte, domeinbewuste systemen bouwen. In plaats daarvan neigen ze op commerciële tools die niet zijn ontworpen voor hun unieke contexten, waardoor de kans op bias, misbruik of missie -uitlijning vergroot.

In een tijd waarin vertrouwen centraal staat in de geloofwaardigheid zonder winstoogmerk, is dit governance -vacuüm alarmerend. AI is niet neutraal. Het weerspiegelt, vergroot en operationaliseert de gegevens waarop deze zijn getraind – en die gegevens worden vaak bezaaid met historische ongelijkheden. Zonder beleid om het gebruik te begeleiden, riskeren non -profitorganisaties de zeer structurele ongelijkheden die zij willen ontmantelen. Ze lopen ook het risico niet aan hun eigen waarden te vallen. Als Addie Achan, directeur van AI -programma’s bij Fast Forward, Zet het: “Het is beter voor een organisatie om de regels en verwachtingen rond die gebruik te definiëren in plaats van mensen het te laten gebruiken en onbedoeld meer schade aanrichten.” In deze context kan ‘schade’ alles betekenen van discriminerende besluitvorming in dienstverlening tot onbedoelde lekken van gevoelige begunstigde gegevens. De behoefte aan ethisch AI -beleid is geen theoretische zorg – het is praktisch.

De kosten van voorzichtigheid en de prijs van actie

Volgens het onderzoek van BDO wijst op een trifecta van weerstand: gebrek aan kennis, onvoldoende infrastructuur en financieringsbeperkingen. Maar ongeveer een derde van de respondenten noemde ook weerstand van medewerkers en ethische zorgen. Hoewel managers bang zijn voor risico’s, kunnen werknemers vrezen voor vervanging. Het scepsis is dus zowel praktisch als existentieel. En het speelt ongelijk af. De meeste AI-implementaties zijn beperkt tot back-office-functies, waarbij de technologie de nauwkeurigheid en efficiëntie stilletjes kan verbeteren. Maar de meer transformatieve toepassingen-AI-aangedreven energietracking, realtime data-synthese voor wereldwijde onderwijsprogramma’s-komen grotendeels ambitieus. Deze missie-uitgelijnde gebruik vereist zowel financiële spieren als ethische duidelijkheid. Op dit moment hebben de meeste non -profitorganisaties het ene of de ander. Weinigen hebben beide.

De Financial Balancing Act

Ironisch genoeg is de financiële positie van de sector stabieler dan in jaren. Volgens BDO zag 52 procent van de non -profitorganisaties de omzetgroei in het afgelopen fiscale jaar, een stijging van 44 procent in 2023. Ondertussen heeft 62 procent nu zeven of meer maanden operationele reserves – het sterkste kussen sinds 2018. Dat is een belangrijke verschuiving van de magere jaren van de pandemie. En het geeft leiders het vertrouwen om meer ambitieuze operationele verschuivingen te overwegen.

Bijna driekwart van de non-profitorganisaties zeggen dat ze van plan zijn om de reikwijdte van hun missies in de komende 12 maanden uit te breiden of te verleggen. Maar voorzichtigheid blijft de dominante financiële houding. De meeste organisaties geven over de hele linie minder uit in 2024 vergeleken met 2023, vooral in belangenbehartiging, fondsenwerving en donorrelaties. De uitzonderingen zijn nieuwe programma -ontwikkeling en talentverwerving – gebieden die bescheiden uitgaven zagen toenemen. Met andere woorden, non -profitorganisaties besparen, huren en testen nieuwe richtingen, maar ze doen dit met het ene oog op de politieke kalender en de andere op macro -economische instabiliteit.

Een beleidsvacuüm met echte gevolgen

Dus waar verlaat dit de sector? Het is in een moment van rustige tegenspraak. Aan de ene kant bouwen non -profitorganisaties reserves, huren talent in en breiden missies uit – duidelijke tekenen van institutioneel vertrouwen. Aan de andere kant nemen ze snel een krachtige, onvoorspelbare technologie aan zonder de bestuursstructuren om het te beheren. De sector gaat het AI -tijdperk in op dezelfde manier als het in het digitale tijdperk is ingegaan – door improvisatie en aanpassing in plaats van strategisch ontwerp. Dat kan een tijdje goed zijn. Maar zonder beleid om transparantie, verantwoordingsplicht en afstemming op de missie te waarborgen, zullen de risico’s alleen maar groeien. De tools kunnen nieuw zijn, maar de ethische dilemma’s – die profiteren, die weggelaten is en wie besluit – zijn oud en onopgelost.

Geverifieerd marktonderzoek: AI -agenten die tegen 2032 $ 51,58 miljard bereiken

Wat moet er daarna gebeuren

Het creëren van ethisch AI -beleid voor non -profitorganisaties gaat niet over het vertragen van innovatie; Het gaat erom het te regisseren. Dat betekent richtlijnen vaststellen die de missie en waarden van elke organisatie weerspiegelen, investeren in intern onderwijs in hoe AI -systemen werken en het implementeren van toezichtsprocessen voor het evalueren van zowel voordelen als schade. Beleid moet niet alleen verduidelijken waarvoor AI kan worden gebruikt, maar ook waarvoor het niet moet worden gebruikt. Ze moeten beslissingspunten identificeren waarbij de herziening van de mens verplicht is, de verwachtingen van gegevens privacy schetsen en procedures voor herstel verstrekken als er schade plaatsvindt.

Non -profitorganisaties hebben een smal venster om het goede voorbeeld te geven. Ze kunnen laten zien dat het mogelijk is om AI niet alleen efficiënt, maar ethisch te gebruiken.