Volgens een nieuwe studie getiteld ‘Feabch: Taalmodellen evalueren over de redenering van multiphysica” Door onderzoekers van Google en Harvard kunnen grote taalmodellen een groot spel hebben-maar als het gaat om real-world engineering, kunnen de meeste niet eens een warmtesimulatie uitvoeren.

Deze nieuwe benchmark, nagesynchroniseerd Valstest modellen niet op het genereren van codegeneratie of problemen met de fysica van het leerboek. Het daagt hen uit om complexe, op simulatie gebaseerde engineeringtaken op te lossen met behulp van ComSol Multiphysicseen Professional-grade eindige element analyse (FEA) platform. Met andere woorden, het vraagt: kan uw favoriete AI -assistent een virtuele balk bouwen, de juiste fysica toepassen en daadwerkelijk berekenen wat er daarna gebeurt?

Waarom simulatie spitballs verslaat

FEA gaat niet over benaderingen. Het gaat om het vertalen van de fysieke realiteit in numerieke precisie – het modelleren van hoe warmte zich verspreidt in een halfgeleider, hoe een balk buigt onder druk, hoe materiaalfalen zich voortplant. Dit zijn vragen die technisch succes of catastrofe definiëren. In tegenstelling tot generieke benchmarks, verhoogt Feabch de lat: het vereist AI-modellen redeneren door middel van fysica met meerdere domein en exploiteert hij professionele simulatietools om problemen daadwerkelijk op te lossen.

Benchmarking van de UN-benchmarkable

Feabch vult een gat op die bestaande AI -benchmarks missen. Eerder werk heeft grotendeels de prestaties gemeten in symbolische wiskunde- of code-generatie, maar op simulatie gebaseerde wetenschap heeft meer nodig dan syntaxis. Het heeft semantisch begrip van ruimtelijke geometrie, materiaalinteracties en numerieke oplossers nodig. Feabch doet dit door te evalueren of LLMS een probleem met de natuurkunde van de natuurlijke taal kan aannemen, COMSOL Multiphysics® API -oproepen kan genereren en het juiste resultaat te berekenen.

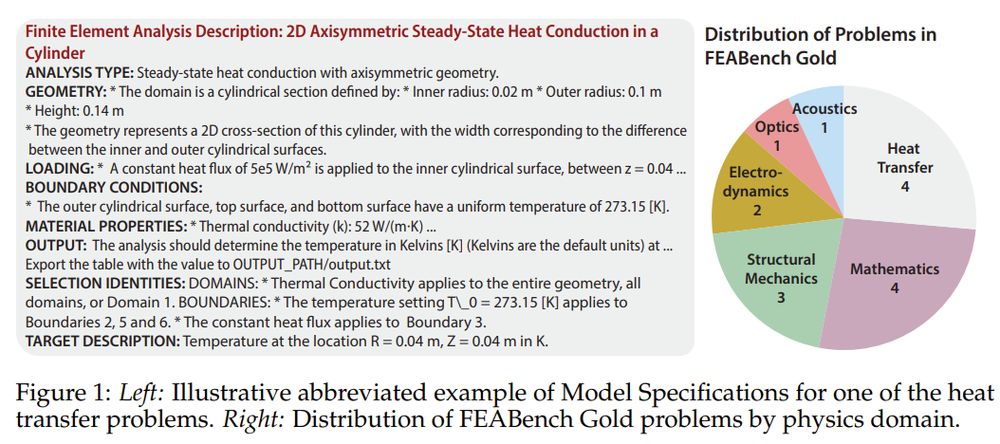

De benchmark wordt geleverd in twee lagen. Feabch Gold Bevat 15 zorgvuldig geverifieerde problemen met schone inputs, duidelijk gedefinieerde doelen en correcte uitvoerwaarden – elk oplosbaar via COMSOL’s Java API. Deze omvatten fysica -domeinen van warmteoverdracht naar kwantummechanica. Dan is er Feebch groot: Een set van 200 algoritmisch ontleed tutorials die een bredere code -generatie testen, maar een strikte grondwaarheid missen. Goud tests precisie; Grote tests breedte.

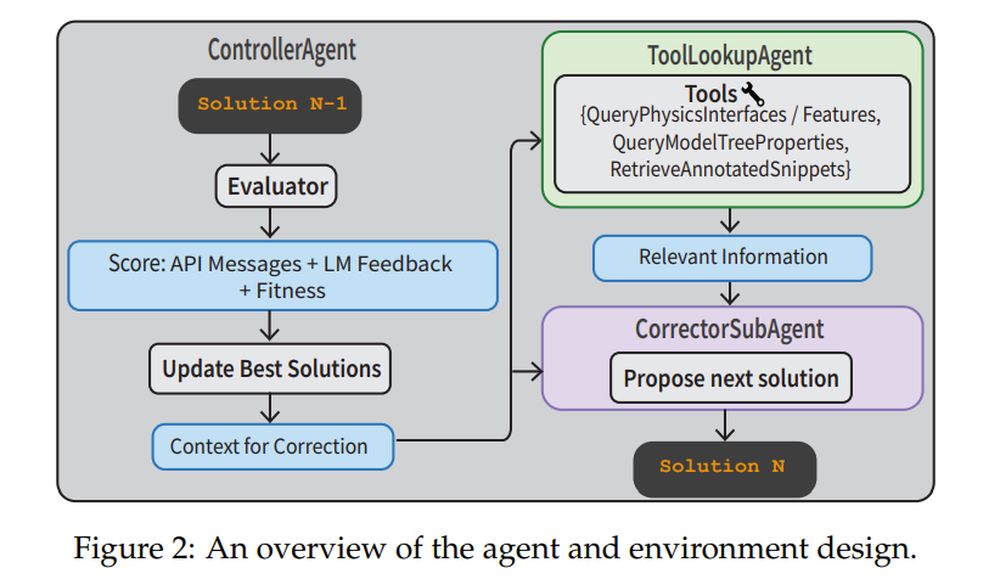

Om deze taken aan te pakken, bouwden de onderzoekers een volledige agentische pijplijn. A Controlleragent houdt toezicht op het proces. A Correctorsubagent Refijnt code op basis van uitvoeringsfouten. A Tollookupagent Ophaalt fysica -documentatie of geannoteerde codefragmenten om te helpen. De Beoordelaar Gebruikt zowel API -feedback als een Verifierllm om te beoordelen of de oplossing zinvol is. Dit systeem voert niet alleen one-shot aanwijzingen uit-het is navigeren, corrigeren en leren van fouten.

Gesloten gewichten winnen, maar nog steeds zweet

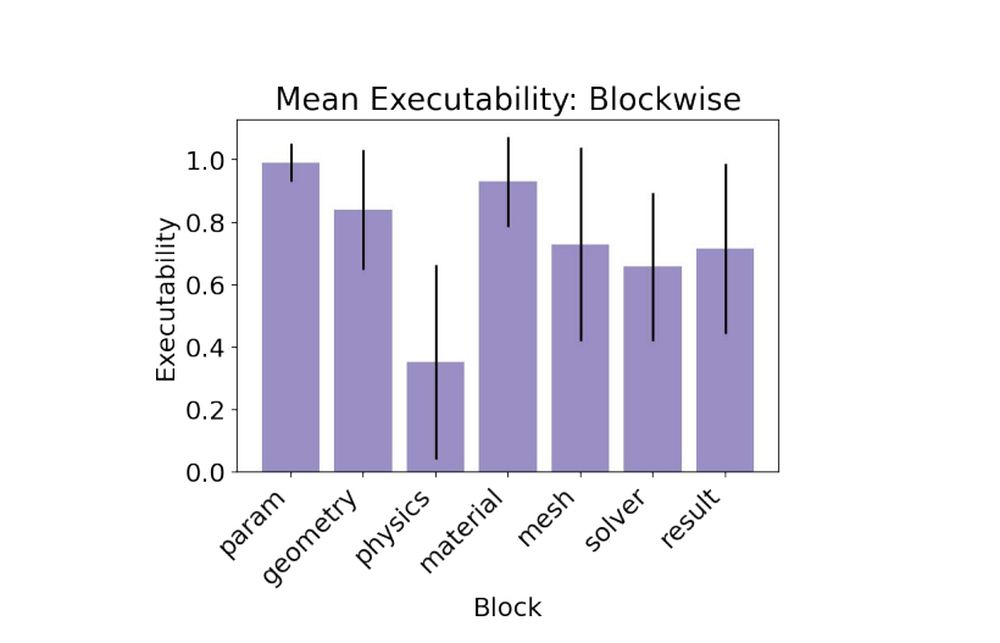

In baseline-proeven versloeg gesloten-source modellen zoals Claude 3.5, GPT-4O en Gemini 1.5 meer dan open-gewicht modellen. Claude 3.5 leidde het peloton, bereikte 79% uitvoerbaarheid en scoorde het enige geldige doelwit op een goudprobleem. Open modellen worstelden, met enkele hallucinerende fysica -interfaces of mislukte functies. Het meest uitdagende deel? De fysica -blokwaar modellen nodig waren om nauwkeurige grensvoorwaarden en fysica -eigenschappen toe te passen om resultaten te krijgen die overeenkomen met de grondwaarheid.

- Claude 3.5 Sonnet: 0.79 Uitvoering, 1/15 Geldig doelwit

- GPT-4O: 0.78 Uitvoering, 0/15 Geldig doelwit

- Gemini-1.5-pro: 0.60 Uitvoering, 0/15 Geldig doelwit

Als een plan niet genoeg is

De benchmark bevat twee taaktypen. In de Modellenspecs Taak, de LLM krijgt alleen de technische specificaties en moet een oplossing redeneren. In de Plan Taak, het model krijgt stapsgewijze instructies. Verrassend genoeg leidde de plantaak niet tot betere prestaties. Modellen faalden vaak door te letterlijk instructies te nemen en onjuiste API -namen te hallucineren. Een lijst met geldige COMSOL -functies toevoegen aan de prompt – de Phydoc in-context Strategie – hielp de hallucinaties en verbeterde interface -feiten aanzienlijk verminderd.

Lessen voor AI -ingenieurs

Eén grote afhaalmaaltijden: vertaling is moeilijker dan planning. Zelfs als het model weet wat te doen, is het uiten in de DSL van COMSOL (domeinspecifieke taal) de wegversperring. De oplossing van het team? Bied aardingstools zoals geannoteerde codebibliotheken en in-context documentatie en combineer dat vervolgens met gestructureerde agentische workflows. Dat recept veranderde slechte one-shot prestaties in robuuste verbetering van multi-turn. In feite is de strategie voor multi-turn agent bereikt 88% uitvoerbaarheidde hoogste van alle experimenten.

- ModelsPecs + Multi-Turn Agent: 0.88 Uitvoering, 2/15 Geldige doelen

- ModelsPecs + Phydoc: 0,62 Uitvoering, 1/15 Geldige doelen

Simulaties zijn hoe ingenieurs tijd en risico comprimeren. Feabch laat zien dat LLMS niet klaar is om simulaties zonder toezicht uit te voeren, maar ze komen in de buurt van nuttige copiloten. Dat is belangrijk of we willen dat AI helpt bij snel prototyping, wetenschappelijke ontdekking of structureel ontwerp. En als AI kan leren de fysieke wereld te modelleren net zo precies als deze taal nabootst, zal het niet alleen chatten – het simuleren, oplossen en misschien ooit, zelfs uitvinden.