Bytedance-zaadonderzoekers uitgerold waarde Augmented Proximal Policy Optimization (VAPO), een versterkingsleertrainingskader dat is ontworpen om de redenering van grote, lange taken van grote taalmodellen te verscherpen, het behalen van nieuwe state-of-the-art resultaten op de Aime24-benchmark.

Training LLMS voor ingewikkelde redenering met behulp van op waarde gebaseerde versterking leren die eerder te maken hadden met belangrijke hindernissen. Methoden worstelden met waardemodelvooroordeel, zich effectief aanpassen aan responssequenties van sterk variërende lengtes en het beheren van schaarse beloningssignalen, vooral in op verificaties gebaseerde taken die alleen binaire feedback bieden.

Vapo gaat deze uitdagingen aan via drie kerninnovaties: een gedetailleerd op waarde gebaseerd trainingsframework, een lengte-adaptief gegeneraliseerd voordeelschatting (GAE) -mechanisme dat parameters aanpassen op basis van de responslengte en de systematische integratie van technieken van eerder onderzoek.

Deze combinatie creëert een systeem waar verbeteringen synergetisch werken. Met behulp van het QWEN2.5-32B-model Zonder specifieke SFT-gegevens verbeterde VAPO Benchmark-scores van 5 tot 60 en overtreft vorige ultramoderne methoden met 10 punten.

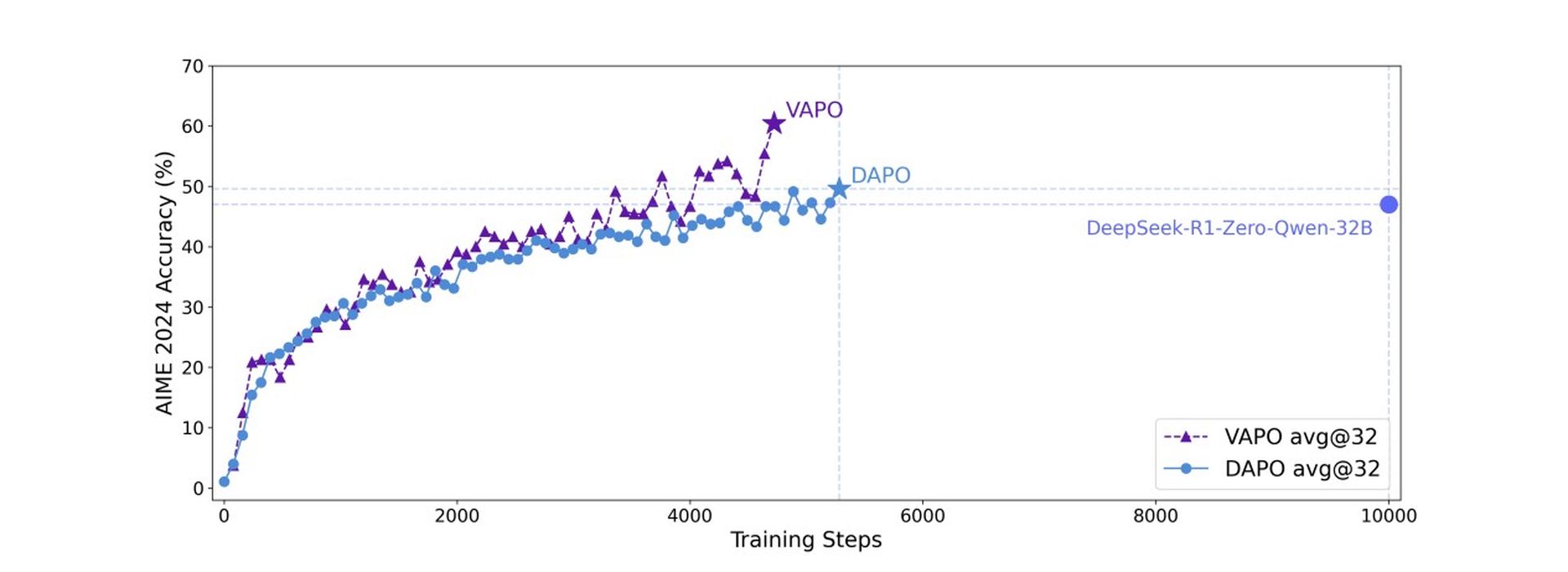

VAPO bouwt voort op het proximale beleidsoptimalisatie (PPO) -algoritme, maar bevat belangrijke wijzigingen om de wiskundige redenering te verbeteren. Trainingsanalyse onthulde vapo vertoont soepelere trainingscurves in vergelijking met de waardevrije DAPO-methode, wat wijst op stabielere optimalisatie.

Vapo vertoonde ook een betere lengteschaling voor verbeterde generalisatie, snellere scorgroei toe te schrijven aan de korrelige signalen uit zijn waardemodel en lagere entropie in latere trainingsfasen. Hoewel verminderde entropie mogelijk de exploratie kan beperken, evenwichtig dit effectief in evenwicht, waardoor de reproduceerbaarheid en stabiliteit worden verbeterd met minimale prestatie -impact.

Op de Aime24 -benchmark behaalde Deepseek R1 met behulp van GRPO 47 punten en DAPO bereikte 50 punten. Vapo, met behulp van het QWEN-32B-model, kwam overeen met de prestaties van DAPO met slechts 60% van de updatestappen en stelde een nieuwe state-of-the-art score van 60,4 in 5.000 stappen in. Vanilla PPO daarentegen scoorde slechts 5 punten vanwege het instorten van het waardemodel leren.

Deze benchmark vraagt of AI kan denken als een ingenieur

Ablatiestudies bevestigden de effectiviteit van zeven verschillende modificaties in vapo. Waarde-pretraining voorkomt het instorten van het model; Gecoulpled GAE maakt volledige optimalisatie van lange reacties mogelijk; Adaptieve Gae balances korte en lange responsoptimalisatie; Clip-higher moedigt grondige verkenning aan; Het verlies van tokenniveau verhoogt de weging voor lange reacties; het opnemen van positief-voorbeeld-LM-verlies toegevoegd 6 punten; en groeps-sampling droeg 5 punten bij aan de eindscore.

Onderzoekers bescheiden Dat VAPO, met behulp van het QWEN2.5-32B-model, aantoont dat deze op waarde gebaseerde aanpak beslissend over waardevrije methoden zoals GRPO en DAPO kan presteren, een nieuw prestatieniveau op te zetten voor complexe redeneringstaken en het aanpakken van fundamentele uitdagingen in trainingsmodellen voor langdurige scenario’s.