Antropische CEO Dario Amodei gepubliceerd Een essay op donderdag benadrukt het beperkte begrip van de innerlijke werking van toonaangevende AI -modellen en stelde een doel voor antropisch om de meeste AI -modelproblemen tegen 2027 betrouwbaar te detecteren.

Amodei erkent de uitdaging voor de komende uitdaging en verklaart dat hoewel Anthropic vroege doorbraken heeft gemaakt om te traceren hoe modellen tot hun antwoorden komen, meer onderzoek nodig is om deze systemen te decoderen naarmate ze krachtiger worden. “Ik maak me grote zorgen over het inzetten van dergelijke systemen zonder een beter handvat op de interpreteerbaarheid,” schreef Amodei en benadrukte hun centrale rol in de economie, technologie en nationale veiligheid.

Anthropic is een pionier in mechanistische interpreteerbaarheid, met als doel te begrijpen waarom AI -modellen bepaalde beslissingen nemen. Ondanks snelle prestatieverbeteringen heeft de industrie nog steeds een beperkt inzicht in hoe deze systemen tot beslissingen komen. Bijvoorbeeld, Openai’s nieuwe redenerende AI -modellen, O3 en O4-Minipresteer beter bij sommige taken, maar hallucineer meer dan andere modellen, waarbij het bedrijf niet zeker weet waarom.

Amodei merkt op dat AI -onderzoekers een verbeterde modelinformatie hebben, maar niet volledig begrijpen waarom deze verbeteringen werken. Anthropische mede-oprichter Chris Olah zegt dat AI-modellen ‘meer zijn gekweekt dan ze zijn gebouwd’. Amodei waarschuwt dat het bereiken van AGI zonder te begrijpen hoe modellen werken gevaarlijk kan zijn en gelooft dat we verder van het volledig begrijpen van AI -modellen zijn dan het bereiken van AGI, mogelijk tegen 2026 of 2027.

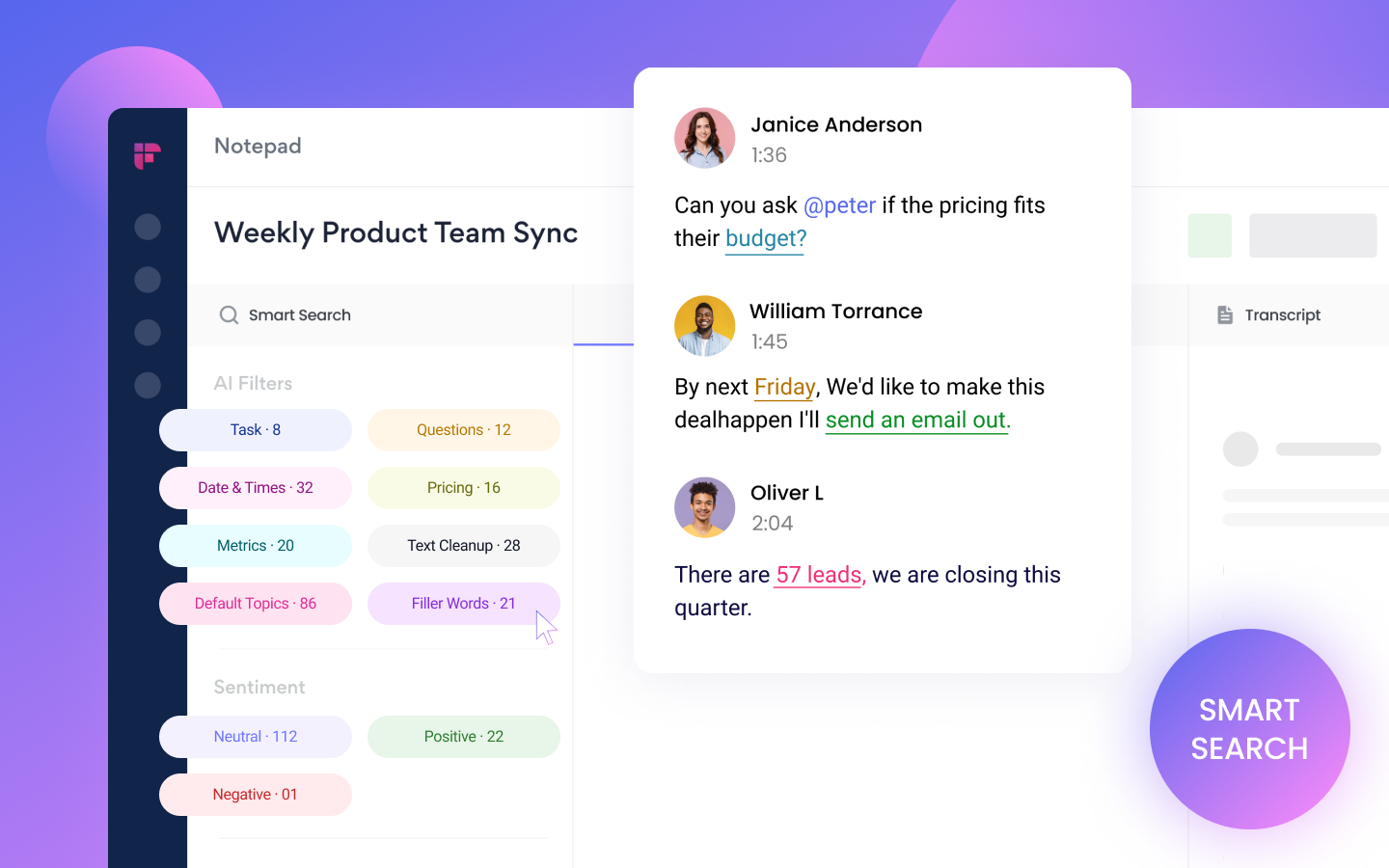

Anthropic is bedoeld om “hersenscans” of “MRI’s” van state-of-the-art AI-modellen uit te voeren om problemen te identificeren, waaronder neigingen om te liegen of macht te zoeken. Dit kan vijf tot 10 jaar duren, maar zal nodig zijn voor het testen en inzetten van toekomstige modellen. Het bedrijf heeft doorbraken gemaakt bij het traceren van AI -model denkpaden door “circuits” en identificeerde één circuit dat modellen helpt Amerikaanse stadslocaties binnen staten te begrijpen.

Antropisch heeft geïnvesteerd in interpreteerbaarheidsonderzoek en heeft onlangs zijn eerste investering gedaan in een startup die op het veld werkte. Amodei gelooft dat het uitleggen hoe AI -modellen tot antwoorden komen, een commercieel voordeel kan bieden. Hij riep Openai en Google DeepMind op om hun onderzoeksinspanningen te vergroten en vroeg overheden om “lichte” voorschriften op te leggen om interpreteerbaarheidsonderzoek aan te moedigen.

Amodei suggereerde ook dat de VS exportcontroles op chips aan China zouden moeten opleggen om de kans op een wereldwijde wereldwijde AI-race te beperken. Anthropic heeft zich gericht op veiligheid en heeft bescheiden ondersteuning voor de AI -veiligheidsrekening van Californië, SB 1047, die de veiligheidsrapportagestandaarden voor Frontier AI -modelontwikkelaars zou hebben vastgesteld.

Anthropic dringt aan op een brede inspanning om AI-modellen beter te begrijpen, niet alleen hun capaciteiten te vergroten. De inspanningen en aanbevelingen van het bedrijf benadrukken de noodzaak van een samenwerkingsbenadering van AI -veiligheid en interpreteerbaarheid.