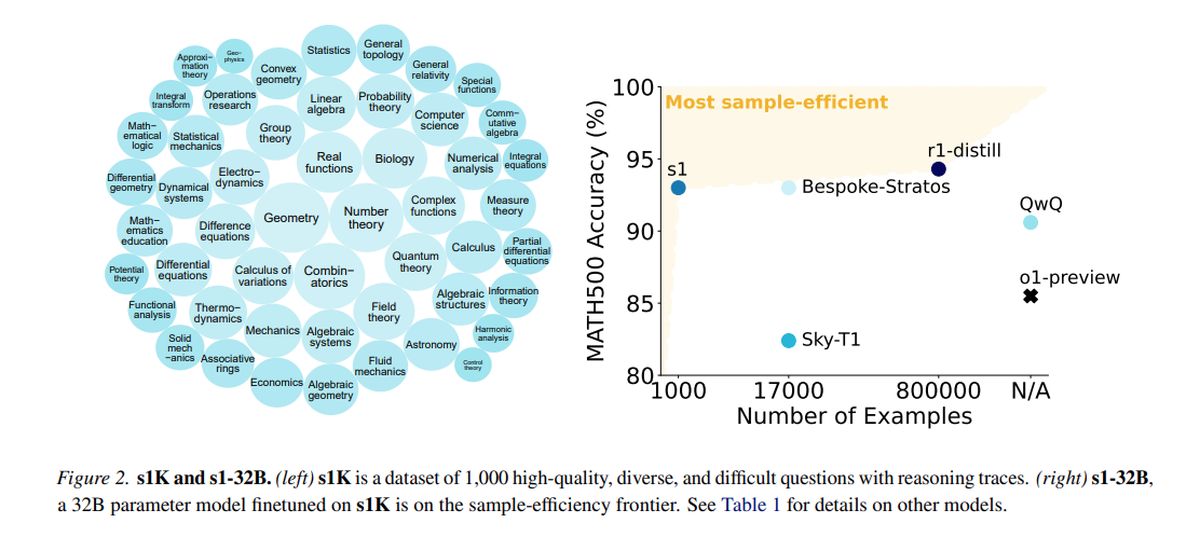

Een nieuw AI -model genaamd S1, onthuld In een paper die op 2 februari werd uitgebracht, krijgt de aandacht voor zijn kosteneffectieve prestaties die Openai’s O1 riveert, waardoor belangrijke mogelijkheden worden bereikt tegen een trainingskosten van slechts $ 6.

AI Model S1 komt naar voren als een kosteneffectief alternatief voor Openai’s O1

Het S1-model bereikt prestatieniveaus in de buurt van state-of-the-art, met behulp van een eenvoudiger infrastructuur. Het verbetert grote taalmodellen (LLM’s) tijdens de gevolgtrekking door “denktijd” uit te breiden door interventies zoals het vervangen van terminallabels door aanwijzingen zoals “Wait”.

Getraind op een gedistilleerde gegevensset bestaande uit 1.000 hoogwaardige voorbeelden van QWEN2.5, ontwikkeld door Alibaba Cloud, S1 gebruikte 16 NVIDIA H100 GPU’s, met een enkele trainingsrun die ongeveer 26 minuten duurde. De totale rekenkosten waren ongeveer $ 6, waardoor frequentere experimenten mogelijk zijn, zelfs voor teams met beperkte middelen.

Terwijl grotere organisaties zoals Openai en Anthropic afhankelijk zijn van uitgebreide infrastructuur, tonen innovaties zoals S1 het potentieel voor vooruitgang binnen beperkte budgetten. De introductie van S1 heeft echter bezorgdheid geleid met betrekking tot ‘Distending’, een praktijk waar modellen gedistilleerde datasets van andere AI -systemen gebruiken, waardoor ethische en juridische vragen worden opgeroepen die de industriële discussies hebben aangestoken.

In tests die wiskunde- en coderingsmogelijkheden meten, presteert S1 vergelijkbaar met toonaangevende redeneermodellen, zoals Openai’s O1 en Deepseek’s R1. Het S1 -model, inclusief de gegevens en trainingscode, is toegankelijk op GitHub.

Het team achter S1 begon met een kant-en-klare basismodel en verfijnde het door destillatie, een methode om redeneermogelijkheden te extraheren uit een bestaand AI-model met behulp van de antwoorden. In het bijzonder wordt S1 gedistilleerd van Google’s Gemini 2.0 Flash Thinking Experimental, die een vergelijkbare aanpak vertegenwoordigt die door Berkeley -onderzoekers werd gebruikt om een AI -redeneermodel te ontwikkelen voor ongeveer $ 450 vorige maand.

De mogelijkheid voor kleinere onderzoeksteams om te innoveren in de AI -ruimte zonder substantiële financiële steun presenteert zowel opwinding als uitdagingen. De vraag rijst over de duurzaamheid van eigen voordelen in een landschap waar dure modellen betaalbaar kunnen worden gerepliceerd.

Openai heeft ontevredenheid geuit en beweert dat Deepseek onjuist geoogste gegevens uit zijn API met het oog op modelstillatie. Onderzoekers wilden een eenvoudige aanpak bedenken die robuuste redeneerprestaties en “testtijdschaling” bereikt, waardoor AI-modellen een diepere analyse kunnen uitvoeren voordat ze reageren.

Het S1-onderzoek geeft aan dat redeneermodellen kunnen worden gedistilleerd met behulp van een relatief kleine dataset via een methode genaamd Supervised Fine-Tuning (SFT), die het AI-model instrueert om bepaalde gedragingen binnen een gegevensset te imiteren. Deze methode is meestal economischer dan de grootschalige leeraanpak van versterking die door Deepseek wordt gebruikt voor zijn R1-model.

Google biedt gratis toegang tot Gemini 2.0 Flash Thinking Experimental, hoewel het gebruik onderhevig is aan dagelijkse tarieflimieten en de voorwaarden ervan verbieden reverse-engineering-modellen om concurrerende diensten te creëren. Het S1 -trainingsproces omvatte het samenstellen van een dataset van 1.000 op maat gemaakte vragen en antwoorden, samen met de redeneerprocessen afgeleid van Gemini 2.0.

Na training, die minder dan 30 minuten duurde, vertoonde S1 sterke prestaties op specifieke AI -benchmarks. Niklas Muennighoff, een onderzoeker bij Stanford die bij het project betrokken was, gaf aan dat de nodige computerbronnen vandaag kunnen worden gehuurd voor ongeveer $ 20.

De onderzoekers hebben ook een techniek geïmplementeerd om de nauwkeurigheid van S1 te verbeteren door deze te instrueren om tijdens de redenering te “wachten”, waardoor de denktijd wordt verlengd en enigszins verbeterde antwoorden bereikte.

Uitgelichte afbeeldingskrediet: Google DeepMind/Unsplash