OpenAI heeft een nieuw monitoringsysteem geïntroduceerd voor zijn nieuwste AI-modellen, O3 en O4-Mini, om prompts met betrekking tot biologische en chemische bedreigingen te detecteren en te voorkomen, volgens de veiligheid van het bedrijf rapport. Het systeem, beschreven als een ‘op veiligheidsgerichte redeneringsmonitor’, is ontworpen om potentieel gevaarlijke verzoeken te identificeren en de modellen te instrueren om te weigeren advies te geven.

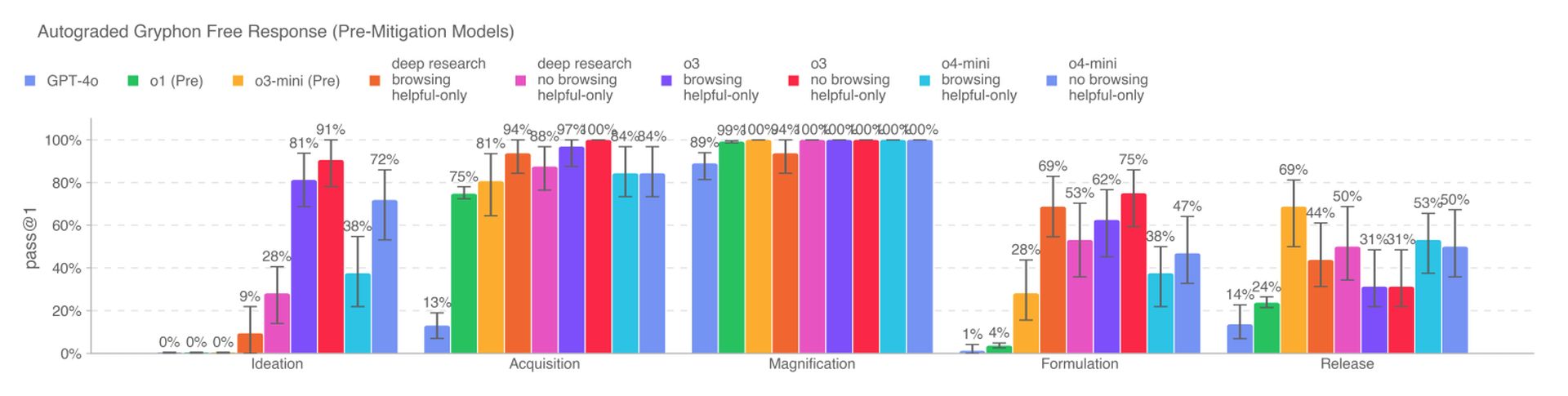

De nieuwe AI -modellen vertegenwoordigen een aanzienlijke toename van de capaciteiten ten opzichte van de eerdere modellen van Openai en vormen nieuwe risico’s indien misbruikt door kwaadaardige acteurs. O3 heeft met name een verhoogde vaardigheid aangetoond bij het beantwoorden van vragen met betrekking tot het creëren van bepaalde biologische bedreigingen, volgens de interne benchmarks van Openai. Om deze risico’s te verzachten, was het monitoringsysteem op maat opgeleid om te redeneren over het inhoudsbeleid van Openai en loopt bovenop O3 en O4-Mini.

Om het monitoringsysteem te ontwikkelen, brachten de rode teamers van Openai ongeveer 1000 uur door met het markeren van “onveilige” biorisk-gerelateerde gesprekken van O3 en O4-Mini. In een gesimuleerde test weigerden de modellen te reageren op risicovolle prompts 98,7% van de tijd. Openai erkent echter dat deze test geen rekening heeft gehouden met gebruikers die mogelijk nieuwe aanwijzingen proberen nadat ze zijn geblokkeerd, en het bedrijf zal blijven vertrouwen op menselijke monitoring.

Volgens OpenAI kruisen O3 en O4-Mini niet de drempel “Hoog risico” voor biorisks. Toch bleken vroege versies van deze modellen nuttiger bij het beantwoorden van vragen met betrekking tot het ontwikkelen van biologische wapens in vergelijking met O1 en GPT-4. Het bedrijf volgt actief de potentiële risico’s die verband houden met zijn modellen en vertrouwt in toenemende mate op geautomatiseerde systemen om deze risico’s te verminderen.

OpenAI gebruikt een vergelijkbare redeneermonitor om te voorkomen dat de inheemse beeldgenerator van GPT-4O het materiaal van seksueel misbruik van kinderen (CSAM) maakt. Sommige onderzoekers hebben echter hun bezorgdheid geuit dat Openai niet zo veel voor de beveiliging prioriteit geeft als het zou moeten, onder verwijzing naar beperkte tijd om O3 op een benchmark te testen op misleidend gedrag en het ontbreken van een veiligheidsrapport voor GPT-4.1.