Openai’s O3 AI -model scoorde lager op de frontiMath -benchmark dan het bedrijf aanvankelijk impliceerde, volgens onafhankelijke tests door Tijdperk AIhet onderzoeksinstituut achter FrontiMath. Toen Openai in december O3 onthulde, beweerde het dat het model 25% van de FrontiMath -vragen kon beantwoorden, wat aanzienlijk beter presteerde dan andere modellen.

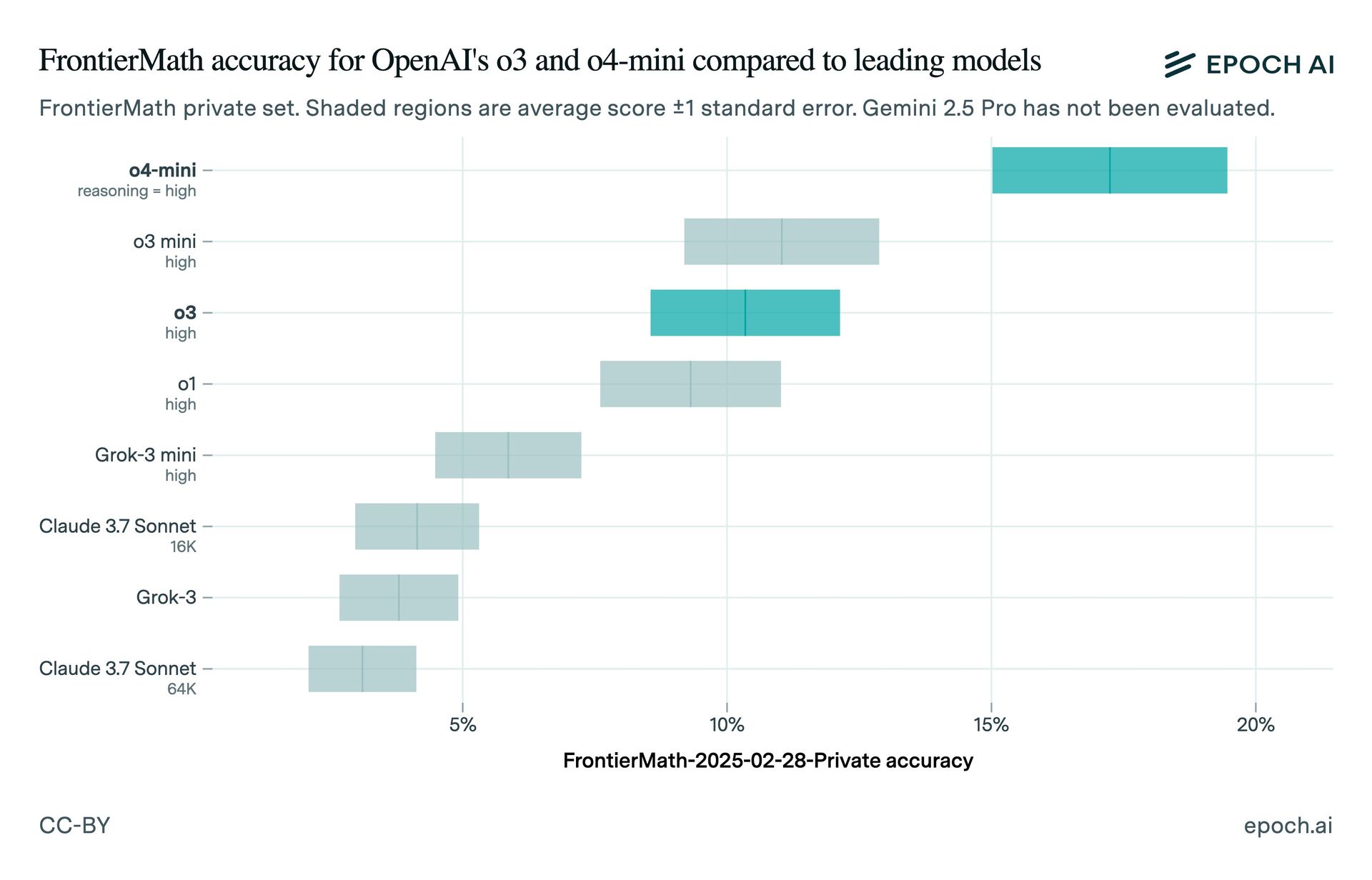

Epoch AI’s tests vonden dat O3 scoorde ongeveer 10% op FrontiMath. De discrepantie kan te wijten zijn aan verschillen in het testen van instellingen of de gebruikte versie van O3. Openai’s Chief Research Officer, Mark Chen, had verklaarde dat O3 bereikte meer dan 25% in “agressieve test-time rekeninstellingen.” Epoch merkte op dat de gepubliceerde benchmarkresultaten van Openai een lagere score vertoonden die overeenkomt met het waargenomen 10% score-tijdperk.

Het openbare O3-model is “afgestemd op chat/productgebruik” en heeft kleinere rekenlagen dan de versie die door OpenAI wordt getest in december, volgens de Arc Prize Foundation, die een pre-release-versie van O3 testte. Openai’s Wenda Zhou uitgelegd dat het productie-O3-model “meer geoptimaliseerd is voor gebruiksgevallen in de praktijk” en snelheid, wat kan leiden tot benchmarkverschillen.

Openai’s O3-Mini-High- en O4-Mini-modellen presteren beter dan O3 op FrontiMath. Het bedrijf is van plan om de komende weken een krachtigere O3-variant, O3-Pro, uit te brengen. Dit incident benadrukt de noodzaak van voorzichtigheid bij het interpreteren van AI -benchmarks, vooral wanneer ze worden gebruikt om commerciële producten te promoten.

De AI -industrie heeft onlangs verschillende benchmarking controverses gezien. In januari werd Epoch bekritiseerd omdat hij de financiering van Openai niet heeft bekendgemaakt tot nadat het bedrijf O3 had aangekondigd. XAI werd beschuldigd van het publiceren van misleidende benchmarkgrafieken voor zijn GROK 3 -model, en Meta gaf toe dat hij benchmark -scores had aangeprezen voor een andere versie van een model dan die voor ontwikkelaars.